- Windows 10

- Otthoni hálózat és internet megosztás

- Harcot hirdetnek a digitális szexbűnözés ellen, célpont a Telegram is

- Bevált az AI, egy nagy cégnél sorra váltják le az embereket

- MinDig TV

- A kriptobányászok energiáját akarja az AI-szektor

- Windows 11

- Milyen routert?

- Telekom otthoni szolgáltatások (TV, internet, telefon)

- DIGI kábel TV

-

IT café

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

PuMbA

titán

válasz

Alogonomus

#41003

üzenetére

Alogonomus

#41003

üzenetére

Erre én is gondoltam.... eddig, de az NVIDIA által kiadott DLSS 3 nélküli sebesség adatokat nézve nem lesz akadály, mert hozza a 3060Ti-től magasabb sebességet fele akkora valós memória sávszélességből. Ezek szerint mégis csak az effektív számít jobban és a nagyobb L2 cache ugyanolyan jól működik, mint az Infinity cache az AMD-nél. De azért várjuk meg a végleges teszteket, lesz-e olyan játék, ahol a 3060 Ti alá esik sebességben.

[ Szerkesztve ]

-

Én úgy tudom,az L3 nem tudja a Vram sávszélt kompenzálni,csak az L2.Más a szerepük. valami ilyesmi volt a múltkor Tom's egyik cikkében.

429-449$ Még talán elfogadható lenne.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

PuMbA

titán

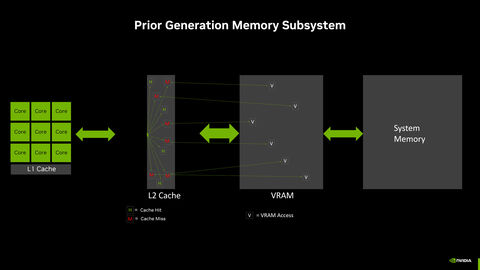

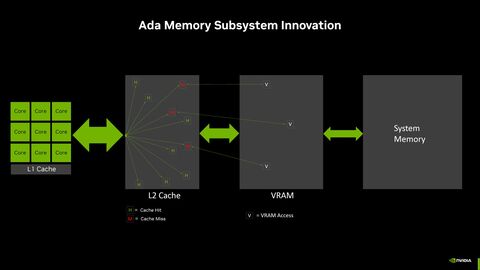

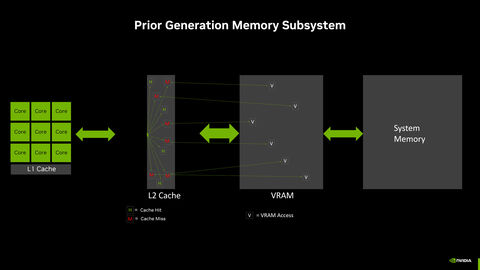

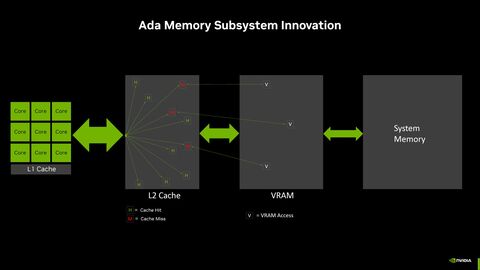

Itt az NVIDIA hivatalos magyarázata az effektív sávszélességre: [link]

Átlagosan 50%-kal csökkent a 32MB L2 cache miatt a memória busz forgalma. Így "számolták" ki

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

A valóság az, hogy az effektív sávszélesség ugyanolyan bullshit az NV-nél is, mint az AMD-nél. Van a cache-nek sávszélje és kész. Attól nem lesz neked effektív sávszéled, hogy x MB-ra több van. Ez valószínűleg azért kell nekik, hogy elmagyarázzák, hogy miért jó a 128 bit 500 dollárért.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Raymond

félisten

Tehat ahogy varhato volt, jon egy 3070 teljesitmenyu kartya 3070 aron*:

GeForce RTX 4060 8 GB: Juli, 329 Euro (299 USD)

GeForce RTX 4060 Ti 8 GB: 24. Mai, 439 Euro (399 USD)

GeForce RTX 4060 Ti 16 GB: Juli, 549 Euro (499 USD)Forras: [link]

*aktualis piaci arak [link]

Privat velemeny - keretik nem megkovezni...

-

Nem akarom különösebben védeni a két gyártó

össze-vissza hazudozó parasztjaitkomoly felkészültségű marketinges szakembereit, de valami olyan fogalmat, mint az "effektív", tényleg be kellett vezetniük. Nyilván a komolyan megnövelt L2 vagy L3 cache a gyakorlatban azt jelenti, hogy átlagosan ugyanakkora teljesítményt jelentősen kisebb memória-sávszélességgel is el lehet érni. Azt meg sajnos az életbe' nem magyarázod meg az átlag vevőnek, hogy az új 288GB/sec + bazi nagy L2 az hol úgy fog viselkedni, mintha 300GB / sec lenne, hol úgy, mintha a 600 - és nyilván az elsőt nem is akarod![;]](//cdn.rios.hu/dl/s/v1.gif) Szóval kellett valami olyan fogalom, aminek van a valósághoz legalább egy kevés köze, a vásárló jó eséllyel megérti, és elég rövid ahhoz, hogy a szó vége előtt nem adja fel a küzdelmet. Vszleg lehetett volna jobb / kevésbé hasbaakasztós szót is találni, de ez most így sikerült...

Szóval kellett valami olyan fogalom, aminek van a valósághoz legalább egy kevés köze, a vásárló jó eséllyel megérti, és elég rövid ahhoz, hogy a szó vége előtt nem adja fel a küzdelmet. Vszleg lehetett volna jobb / kevésbé hasbaakasztós szót is találni, de ez most így sikerült..."... and with your wicked wishes we will rise again"

-

paprobert

senior tag

Én úgy emlékszem, hogy ugyanez a helyzet az Infinity Cache megjelenésekor még pozitívan volt bemutatva.

"De jó hogy 256bit is elég, regiszternyomás-rezisztens architektúra, energiatakarékossági bajnok kártya, esport-ra már csak Radeont érdemes venni" stb.Csak azóta vált agyafúrt megtévesztőeszközzé, mióta a zöld kártyákat kitömték L2-vel.

Összességében, mivel a technológiai előrelépésnek nincs a vásárlóknál lecsapódó pozitívuma, az effektív

fontossága megkérdőjelezhető ennek.

fontossága megkérdőjelezhető ennek.

A technikai részletekért rajongó oldalam persze kíváncsi, de közben mindkét cég bek*phatja.[ Szerkesztve ]

640 KB mindenre elég. - Steve Jobs

-

Abu85

HÁZIGAZDA

Ezt lehetne úgy jelezni, hogy Last Level Cache bandwith, és akkor nem kell hülyeséget írni.

Az effektív egy marketingszó, amit mindkét cég használ, természetesen rosszul.

#41012 paprobert : Eleve az L2 cache megnövelése és az Infinity Cache nem ugyanaz. Az L2 gyorsítótár egyetlen GPU-ban sem victim cache, méghozzá jó okkal. Az Infinity Cache viszont victim cache, szintén jó okkal. A funkciójuk teljesen más. Le is van írva a cikkekben.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

válasz

FLATRONW

#41011

üzenetére

FLATRONW

#41011

üzenetére

Probléma akkor is van (az effektív akkor is hülyeség), és a mostani probléma is csak egy szűk körnek tűnik fel, úgyhogy igazából mindegy.

#41013 Abu85: hát, a LLCB-nek meg az információtartalma közelít a nullához. Valami olyasmire van szükség, amitől összevethetővé válik az előző generációval, és nem azt látja a potenciális vásárló, hogy az előző generációhoz képest kapott a sávszélesség egy fajsúlyos vágást.

#41012 paprobert: fontosnak éppen fontos, mert sokféleképpen lehet variálni a fizikai sávszélesség és a cache arányát, nem lehet azt mondani, hogy az Ampere megoldása jobb, mint az Ada-é, vagy fordítva. Úgy érzésre kicsit soknak tűnik a vágás a fizikai sávszélességből, meg a 4K tesztek is erre utalnak, de egy rendes elemzést jó lenne róla látni.

[ Szerkesztve ]

"... and with your wicked wishes we will rise again"

-

paprobert

senior tag

Olvastam, tudom.

Az NV L2-je úgy lett óriási méretű, hogy még épp betölti az L2 szerepét, az AMD L3-ma pedig egy nagyon erős L3 lett.

A végeredmény mindkét esetben emelt effektív sávszél, máshol jelentkező limitekkel.#41014 gbors Egyetértek. Azt vettem alapul, hogy ha minden más maradna úgy, mint az előző genben, akkor előrelépésről beszélnénk.

Az NV viszont zsebre rakja a fejlesztést azzal hogy, jelen esetben *50Ti kártyát árul *70-*80 áron, vagyis ez a fejlesztés a gyakorlatban csak BOM csökkentésre jó, csak az Nvidiának.[ Szerkesztve ]

640 KB mindenre elég. - Steve Jobs

-

TPU lehozott egy cikket az Ada memória alrendszeréről az L2 sávszélről, ha már ez volt ma a téma: [link]

van benne elég sok marketing is, de talán van valamennyi valóságalapja is.

Szerintük a gyors és nagy L2 hasznosabb, mint a nagyobb de lassabb L3.

Szerintük legalább 32 MB L2 50% körül csökkenti a memória busz terhelését egy 2 MB L2 GPU hoz képest.

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Abu85

HÁZIGAZDA

"Szerintük a gyors és nagy L2 hasznosabb, mint a nagyobb de lassabb L3."

OMG mekkora szöveg. Közben meg az AMD-nek az RDNA 3-féle Infinity Cache-je kétszer gyorsabb, mint nekik az L2-jük. Na most akkor mi az igaz? Az állítás itt durván szembemegy a tényekkel. Persze lehet, hogy a saját képességeikhez mérik magukat, akkor lehet igaz, csak ugye más tud sokkal gyorsabbat is építeni, tehát az állításuk kizárólag a saját rendszereikre értendő.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

PuMbA

titán

"Közben meg az AMD-nek az RDNA 3-féle Infinity Cache-je kétszer gyorsabb, mint nekik az L2-jük."

Ez biztos? Chips and Cheese mérése szerint az NVIDIA-é a gyorsabb.

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

Biztos. A C&C tesztben eleve a mérés nem ugyanaz, mert más a size, almát hasonlítanak a körtéhez. Az Infinity Cache egy victim cache. Az a tiling adatokat tartalmaz. Ezért van szétválasztva az AMD-nél ez a dizájn. A wave-ek az L2-be írhatnak, míg a tiling adatok a ROP-ból nem kerülhetnek az L2-be, azoknak ott az Infinity Cache védőhálóként. Szándékosan ilyen, hogy ne legyen túl nagy a szemetelés. Ezt amúgy egy GPU-nál irgalmatlanul nehéz megcsinálni. Az AMD-nél is a CPU-s team csinálta az Infinity Cache-t, mert nekik volt erről tapasztalatuk, lásd Ryzen L3. GPU-s team valószínűleg nem tudta volna így megcsinálni, arra lettek volna képesek, amire az NV, vagyis kvázi lett volna egy nagy L2. De akkor meg ott van az a probléma, hogy a wave és tiling adatok egymás tárhelyét szemetelik. Ez fontos amúgy, mert ha mérsz egy első frame-es eredményt, akkor kurva jó lesz a hit, de ha mérsz egy tízezredik frame-est, akkor már jelentősen visszaesik, ha nincs szétválasztva a cache, és beleköp a lecsóba a szemetelés.

Az NV-nél a 32 MB-os L2 sávszélje 554 GB/s. A Navi 33-nál a 32 MB-os Infinity Cache sávszélje 1160 GB/s.

Nyilván erről az NV akkor fog majd beszámolni, amikor lemásolják az Intel és az AMD megoldását. Addig azt mondják, hogy az Intel és az AMD csinálja rosszul, annak ellenére, hogy minden szám mást mond.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

PuMbA

titán

Értem

"Addig azt mondják, hogy az Intel és az AMD csinálja rosszul, annak ellenére, hogy minden szám mást mond."

Amíg az RTX4090-nel nagy különbséggel övék a leggyorsabb VGA, sajnos vagy nem sajnos, ezt könnyű szerrel megtehetik. A felhasználók csak az fps értékeket látják és az a faék egyszerűséggel levonható következtetés az fps értékből, hogy az NVIDIA tudja a legjobban, hogy mik a legjobb architektúrális megoldások. Ha az AMD megoldása lenne a jobb, akkor övéké lenne a teljesítmény előny. Így gondolkozik az emberek nagy része.

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

Csinálhatna az AMD is 76 milliárd tranzisztorból álló GPU-t, csak gazdaságilag nem hasznos. Egyrészt kevesen vesznek 1600 dollárért hardvert, másrészt a rendszer fejlesztési költsége nagyon magas lesz arra a kevés vásárlóra.

Ez egy gazdaságossági probléma, nem pedig technológiai. Az AMD egy bizonyos minimum nyereség alatt nem is dolgozik. Egyszerűen némelyik terméken túl kicsi a realizálható profit, hogy megérje mérnöki erőforrást pazarolni rá. Tipikusan azokon a termékeken, amelyek túl drágák, hogy nagy mennyiségben eladhatók legyenek.

A felhasználók bármit elhisznek, amit a gyártók mondanak. Egyszerűen nem értenek hozzá, és ezért töményen isszák a marketinget, mert attól okosnak hiszik magukat.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Petykemano

veterán

Jó, de ha ebben a szobában kérdezed, akkor sokak szerint a 4080 is jobb, mint a 7900XTX. pl: Összességében kisebb lapkaterület, jobb fogyasztás, valamint a monolitikus felépítés miatt talán icipicivel rosszabb kihozatal, de lényegesen kisebb kockázat és kisebb packaging költség.

Egyébként szerintem nem azért nem éri meg az AMD-nek arra a piacra tervezni, ahol a 4090 van, mert az önmagában annyira pici, hanem sokkal inkább azért, mert az a piaci részesedés volna nagyon pici, amit a rendelkezésükre álló technológiával és mindshare-rel abból a szegmensből el tudnának hozni.

Találgatunk, aztán majd úgyis kiderül..

-

Tragger

tag

Vajon várható 4080Ti a nyáron? Elég nagy a csend vele kapcsolatban.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#41022

üzenetére

Petykemano

#41022

üzenetére

Erre vannak a tesztek, amely szerint meg nem jobb. Az mindegy, hogy ki mit képzel.

A csúcstermékeknél mindig az határozza meg a megszületését, hogy mennyit lehet belőle eladni a tervezett áron. Ha túl keveset, akkor a tervezésébe sem érdemes belevágni. Egyszerűen nem jön vissza ennyi pénz, hogy mérnöki erőforrást pazaroljanak rá. Ettől technológiailag kivitelezhető az egész, mert beépítenek pár extra multiprocesszort és kész.

#41023 bitblueduck : Nem a haszon a lényeg, hanem a haszon mértéke. Ha más terméken több profit van, akkor oda kell rakni a mérnöki erőforrást.

Általában a legrosszabbul a leggyorsabb hardverek teljesítenek a profit szempontjából, mert ezek ára túl nagy, hogy tömeges szinten vásárolják őket. Eleve az árazásuk is aránytalanul túl van lőve, mert benne van az e-pénisz faktor.#41025 gV : Mert az az NV-nek az egyetlen 24 GB-os VGA-ja. De ha csinálnának egy kisebb 24 GB-ost, akkor simán az érné meg jobban.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Busterftw

veterán

Ezzel nem ertek egyet, mert a die mindenkeppen elkeszul es abbol lesznek a kulonbozo kategoriak.

Vegyuk a RTX 3090 es az RTX A5000 esetet, nem az tortent, hogy megcsinaltak az RTX 3080-at, aztan full nullarol beleoltek a mernoki eroforrast egy 3090 GPU-ra.A piaci igenyeknek megfeleloen elkeszult az GA102, full chip ez modositva RTX 3090(ti) lett, abbol vagva RTX 3080(ti) es 3070Ti.

Az GA102 mar kesz van, ezt kiadva pedig a csucskategoria.

Az Nvidia ebben a kategoriaban mindent bezsebel, mert egyeduralkodo, rengeteg embernek kell a legjobb.Az AMD-nel is tervezhettek volna igy, csak hat a NAVI31 ennyire kepes, mert 700W kellett a 7900XTX-hez, hogy raszterben megkozelitse a 4090-et.

Szoval ertem en, hogy tudna az AMD ilyet csinalni, csak igy a kutya nem venne.[ Szerkesztve ]

-

paprobert

senior tag

válasz

Petykemano

#41022

üzenetére

Petykemano

#41022

üzenetére

Az AMD csúcskártyája csak akkora lehet, amelynek az ára jelentősen visszavágva is profitot termel(ne). Ez az elmélet.

Érthető, hogy biztonsági játékot kell játszania az AMD-nek, mert alapból 5x kisebb a felhasználói bázis, a csúcson pedig még nagyobb a különbség. Nem lenne volumen, akár mondhatjuk, hogy nincs igény egy még drágább AMD kártyára. Ezért marad csak ez a szolidabb kártya csúcsnak.

A gond viszont az, hogy jól számolod, ezzel a biztonsági játékkal is elvesztette a BOM versenyt az AMD, emellett a hatékonysági versenyt is. A rélytrélyszing versenyt is. A szoftvercsomag versenyt is.

Vagyis a csúcsra maradna egy drága, rosszul fogyasztó, RT-ben kikapó, szoftverben másodvonalas termék. Jó döntés nem hozni.

Szerk:

Abu megfogalmazása azt sugallja, hogy nincs elég profit az Nvidiánál 1500 dolláros árcímke mellett, és ezért az aprópénzért már büdös lehajolni az AMD-nek.

Az első állítás szimplán nem igaz, a második pedig nem azért és nem úgy igaz, ahogy Abu állítja.[ Szerkesztve ]

640 KB mindenre elég. - Steve Jobs

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#41027

üzenetére

Busterftw

#41027

üzenetére

Az a rengeteg ember elenyésző szám azokhoz viszonyítva, akik középkategóriát vásárolnak. A legtöbb profit onnan jön.

Az órajelből mindig több fogyasztást jelent emelni, mint multiprocesszorok hozzáadásával. Ha lenne plusz 15 milliárd tranyó egy Navi 3x-ben, akkor az sem fogyasztana többet 350 wattnál, mert alacsony órajelet lehetne beállítani neki.

#41028 paprobert : Magával a piaccal van a probléma. Szűkül az egész, mert egyre kevesebb ember akar 1500 dolláros VGA-t költeni egy olyan PC-s portra, ami három hónapnyi patch után is akad a hardveren, miközben az 500 dolláros konzolokon pöcre fut.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Uhhh, ez kemény volt. Ezeket a sületlenségeket el is hiszed?

Egyrészt a 4090 halo termék, aminek a brand-értékét elsősorban nem per eladott kártyával kell számolni.

Másrészt vitték, mint a cukrot, úgyhogy erősen kétlem, hogy ne lett volna profitábilis (nem adtak el esetleg belőle többet, minta 7900 XTX-ből?)

Harmadrészt, az AMD-nek skálázódási problémái vannak a 7900-asokkal. Biztos tudtak volna csinálni 33%-kal nagyobb chipet, csak nem biztos, hogy örültek volna, hogy 10%-kal gyorsabb. Szóval ez nagyon is technológiai kérdés.Azért nagyon mulatságos, hogy egy technológiailag újfent versenyképtelenné vált cégről megmagyarázod, hogy ők csinálják jól

"... and with your wicked wishes we will rise again"

-

Abu85

HÁZIGAZDA

Sokkal drágább gyártani a 4090-et, mint a 7900 XTX-et. Ez a csúcstermékekkel a gond. Túl drága az egész gyártási költsége, és a piac nem vesz annyit, hogy masszív nyereség keletkezzen rajta. Ha pedig egy adott nyereség nem hozható, akkor inkább hozzá sem fognak a cégek a tervezéshez, mert lekötné a mérnöki kapacitást olyan hardver elől, amely tudna hozni nagyobb nyereséget.

A multiprocesszorok skálázódása más, mint az órajel skálázódása. Simán jobban tudsz skálázni úgy, hogy raksz még hozzá 30%-nyi multiprocesszort, meg még két GDC-t, és 512 bites buszod lesz a memóriához. Ez nem csak 10% lesz.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Yutani

nagyúr

Szerintem engedjük ez ezt a "nincs profit a csúcsterméken" dolgot, hiszen a gyártó egy egész termékskálát kínál, és azon belül az egyes termékeknek megvan a saját feladata: a csúcstermék elülteti a zemberek fejében, hogy azt a márkát kell venni, és a zemberek megveszik a gyártó középkategóriás termékeit, amelyeken a tényleges haszon van. A teljes termék portfóliót kell nézni, nem az egyes termékeket kiragadni.

Szerintem tudod te ezt jól, csak szórakozol a zemberekkel itten.

#tarcsad

-

Busterftw

veterán

Többért is adják, nem látom mi a probléma.

Ha 7900XTX áron adnák akkor értem a logikát, de nem így van.A Gaming bevételük pedig köszöni szépen jól van, a szokásos Nvidia marginnal.

Egyszerűen nem támaszt alá a matek.De még mindig nem kaptam választ az "extra mérnöki erőforrásra" amikor épp nem ez történik, a már kifejlesztett chipet hozzák le gaming piacra, nincs külön erőforrás a csúcs kategóriára.

A fókusz nyilván az RTX A széria, hiszen ott a GA104 5-6ezer dollár.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#41032

üzenetére

Yutani

#41032

üzenetére

Nem az lényeg, hogy nincs profit, hanem az, hogy mennyi az annyi.

Ez egy jelentős kérdés, mert a mérnöki erőforrást úgy szokás beosztani, hogy minél nagyobb profittal lehessen terméket eladni.

#41033 Busterftw : A gaming bevétele az NV-nek nem igazán van jól. Q4-ben éves szinten 46%-ot estek. Nem véletlen, hogy limitálják a GeForce-ok gyártását.

És mennyit adnak el RTX A sorozatból? A teljes Professional Visualization részleg negyedéves bevétele ~230 millió dollár.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Alogonomus

őstag

Sőt annyira kapós a 4090, hogy egyenesen nem is győzik utántölteni a polcokon a 4090-es szekciókat, mert a vásárlók úgy tépik ki a raktárból éppen csak kilépő eladószemélyzet kezéből a dobozokat.

A Mindfactory viszont még ki is akar szúrni magával, ezért akciózza is a 4090-t, hogy még nagyobb tülekedés legyen a kártyáért, miközben a bolt saját nyeresége még csökken is.

Kezdetben lepörögtek a presztízsvásárlások, aztán ki is fogyott a "szél" a 4090 "vitorlájából", mert $1600-ért még 4k esetén is a generáció leggyengébb ár/érték ajánlata, és most nincs bányászláz, ami még a hasonlóan elrugaszkodottan árazott 3090-eket is "felszívta" a polcokról.

[ Szerkesztve ]

-

De ők nem az írták, hogy gyorsabb, hanem hogy hatékonyabb. Ami már többször kiderült Raytracing szempontjából igaz is. valószínűleg ők erre építik az egész kártyát és ezen szemszögből szemlélik. C&C pont ezt mérte ki, hogy az L2 mennyire fontos az hitrate szempontjából. Az L3 más szempontból nyújt előnyt.

Igen te meg mindig azt mondod az nvidia csinál mindent rosszul aztán folyamatosan a kiderül hogy tévedsz.

lásd az FSR bemutatkozása amiben kommenteken keresztül részletezted mennyire szar hogy Nvidia Mozgásvektor alapú megközelítést hazsnál aztán jött az FSr 2.0...[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Komolyan lyen valótlan dolgot leírsz megint? te azt gondolod az Nvidia kiad egy kártyát amin nincs haszna? Ráadásul nem is csúcs GPU hanem vágott verzió...Ki hiszi ezt el?

Dylan Patel már leírta többször hogy a 150 dolláros hűtővel számolva kb-800 dollár a kártya valós előállítási költsége, Erre rájön a logisztika csomagolás, legyen +150dollár...és ez az FE verzió, az Asus simán rátesz erre egy lapáttal.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Yutani

nagyúr

válasz

Alogonomus

#41035

üzenetére

Alogonomus

#41035

üzenetére

Éppen akartam írni, hogy biztos szívtál valamit, mert az itteni vélemények szerint a 4090 a legmegérősebb kártya mind közül. Aztán mondom megnézem a TPU-n a legutolsó perf/$ chartot, erre az jön ki, hogy $1600 áron a legrosszabb kínálatok között van. Egy sz@rabb van, a 6500XT. Bizony. Az összes többi kártya jobb mutatóval rendelkezik.

Ez alapján mintha baj lenne a zemberek fejével itten.Ez 4k tábla, de az 1080p és 1440p táblán konkrétan a 4090 a legrosszabb mutatójú kártya, de nyilván az nem érdekes, mert 4k-ra veszik a 4090-et.

#tarcsad

-

Abu85

HÁZIGAZDA

Sugárkövetés szempontjából biztosan nem igaz, mert a sugárkövetés problémája, hogy a sugarak többsége nem koherens. Ergo nem alkalmazható a lokalitási elv, vagyis nem sok haszna van a cache-nek, mert nagyon random a memóriaelérés. Ha tényleg ezt mondták, akkor hazudtak nektek.

#41037 b. : Minden VGA-n van haszon, csak kérdés, hogy elég-e. Azért ezeknek a termékeknek fejlesztési költségük is van. Nem a per haszon a lényeges, hanem az, hogy eladnak-e akkora mennyiséget, hogy egyáltalán legyen rajta egy normális nyereség, vagy hasznosabb az erőforrást olyan helyre rakni, ahonnan több pénz jön vissza.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Nyjah, vszleg akár 100 dollárral is drágább a gyártása. Ja hogy 600-zal drágábban adják? Az nem gond, az nem számít bele a profitba. Oh wait

![;]](//cdn.rios.hu/dl/s/v1.gif)

Meg aztán mi a nagy különbség -mérnökileg- a 4080 meg a 4090 között? Ugyanaz, amit leírtál a Radeon kapcsán - több modult kell behajítani. Szerintem pont a fordítottja van annak, amit leírsz - csináltak ugyanarra az arch-ra egy halo cuccot minimális extra efforttal, eladták halo áron, és ők a teljesítménykirályok, magasan, ami lecsorog az összes többi szintre.#41035 Alogonomus: az ugye megvan, hogy múltidőt használtam?

"... and with your wicked wishes we will rise again"

-

Abu85

HÁZIGAZDA

A külön lapka mindenképpen jelentős költség, főleg olyan node-okon, ahol az első tape-out ~600 millió dollár. Még ha a validáció nagyrészt átmenthető, akkor is bő 150-200 millió dollár egy extra termék, ami külön lapkát használ.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Igen biztos nem igaz. Gondolod úgy hogy 20 % kal több új gererációs Nvidia kártya megy el 20 % kal drágább MSRP-n ( kis matek) akkor az Nvidia veszteséges az AMD nyereséges ?

Ajánlom figyelmedbe : [link][ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Abu85

HÁZIGAZDA

Ha a gaminget nézzük, akkor a két cég gaming üzletága kb. fej-fej mellett halad. A nyereséget nehéz követni, mert az NV azt nem adja meg per üzletág szintjén.

De persze ezeket nagyban torzítja az is, hogy óriási a raktárkészlet, így az NV sem tud akármit gyártani, mert túlságosan leviszik a termékek árát a kereskedők.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

-

gV

őstag

válasz

Yutani

#41038

üzenetére

Yutani

#41038

üzenetére

nézd meg a CP2077 RT-be mit megy és mit a többi, kezdve azzal, hogy natív 4k-t a 4080 tudja még a 4090-en kívül futtatni úgy ahogy. árak: 4080 ventus 537e Ft, 4090 ventus 706e Ft ez +~31%. fps-ek 1% min 31.4 vs 42.4 +~35%. OD RT DLSS-el a legjobb 4090/4080 között +55%. szóval nincs baj a fejemmel ha rám is gondoltál ezzel:

Ez alapján mintha baj lenne a zemberek fejével itten.

csak máshol találod az igazságot. -

Alogonomus

őstag

Igazából elsőre nem is gondoltam reagálni az eredeti hozzászólásodra, de azt már túl erős kijelentésnek éreztem, hogy "vitték, mint a cukrot". Valójában pedig csak a kiadása utáni pár hétben volt rá komolyabb kereslet, és az is főleg azok részéről, akik mindenáron a legjobban felhájpolt kártyát keresték. Mostanra pedig látszólag már 20%-os árengedményt is kell bevetni, hogy a keresletet valamennyire szinten tarthassák.

Szóval az a hatalmas érdeklődés gyorsan lecsengett, ezért éreztem túlságosan félrevezetőnek az alapján a pár hétnyi időszak alapján a megjelenése óta eltelt időszakra vonatkozó általánosító kijelentésedben foglaltakat. -

PuMbA

titán

válasz

Alogonomus

#41049

üzenetére

Alogonomus

#41049

üzenetére

A megjelenése után 1-1,5 hónappal 250 ezres eladásról volt szó a 4090 esetén. Azóta mondjuk legyen 300 ezres, ha tényleg minimum eladásokkal számolunk. Ha ezt a számot beszorozzuk az eladási árral, akkor lehet elmélkedni az ebből származó bevételen és a profiton is, hiszen tudjuk a körülbelüli margin-t.

[ Szerkesztve ]

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Hibátlan - GIGABYTE Geforce GTX 1080Ti AORUS 11GB 352bit - brutális

- 3080/3080 TI !!! KERESEK !!!

- 3 év Gari! / Új, Bontatlan! / SAPPHIRE NITRO+ AMD Radeon RX 7700 XT 12G, Ha másfajta kéne, írj!

- Hibátlan - GIGABYTE Radeon RX 5700 Gaming OC 8GB GDDR6 VGA videókártya

- RTX 3070 Vision Fehér/ garancia/ ingyen foxpost

Állásajánlatok

Cég: Ozeki Kft

Város: Debrecen

Cég: Ozeki Kft

Város: Debrecen

![;]](http://cdn.rios.hu/dl/s/v1.gif)