- Milyen routert?

- Trump szerint sokan kapkodnak a TikTokért

- One otthoni szolgáltatások (TV, internet, telefon)

- Milyen program, ami...?

- Információbiztonság, kiberbiztonság, adatvédelem

- Facebook és Messenger

- Windows 11

- Kodi és kiegészítői magyar nyelvű online tartalmakhoz (Linux, Windows)

- Hálózati / IP kamera

- Google Chrome

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48290

üzenetére

paprobert

#48290

üzenetére

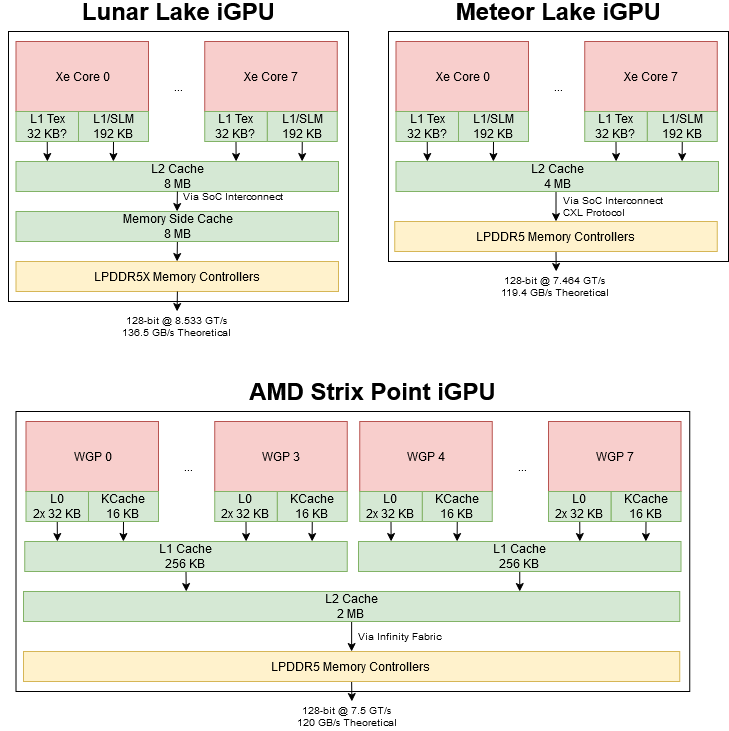

Az nem az összes cache.

Az Intel már az első Arcból kivette a fast path áramköröket a régi API-kra, ebből sokat spórolnak. Cserébe nagyon-nagyon lassan fut a DirectX 11-es játékok többsége. Ugyanezt az AMD és az NV is meg tudja majd tenni, de ennek ez az ára. Most még nem olyan gyorsak az IGP-k, hogy ez vállalható legyen. Ez egy nagyon paradox választás, mert azt hinnéd, hogy elég erős lesz a hardver a 10 éves játékokra, de azok azért gyorsak a GPU-kon, mert vannak különböző fast path áramkörök a kontroll logikában, plusz van rájuk natív támogatás.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48288

üzenetére

paprobert

#48288

üzenetére

Nem számolják bele a 8+8 MB cache-t, ami kell a működéshez. Erre van tervezve a GPU, hogy azok a cache-ek ott vannak. Az RDNA 3-hoz nem kell ekkora cache. Elég 2 MB.

Ezen fog változtatni az Xe4, hogy nem kell óriási cache, és nem kell lokalitási elvre optimalizálás, hogy működjön a dizájn. Emiatt közelebb kerül az egész ahhoz, ahogy az AMD és az NV GPU-k működnek.

A másik jelentős különbség az a GPU-k etetése. Az AMD és az NV még ma is beépíti azokat a fast path módszereket a hardverbe, amelyek szükségesek a DirectX 11-es címek gyors futtatásához. Az Intel ezeket már teljesen kihagyja. Emiatt sokkal egyszerűbb az Arc kontroll logikája, mert el lehet távolítani a specifikusan DirectX 11-re szabott adatutakat. Ennek az előnye, hogy kb. 90%-ot spórolnak kontrol logika szintjén a tranzisztorokkal. A hátránya, hogy régebbi API-kkal nem versenyképes a dizájn, és nagyon sok teljesítmény marad benne bizonyos alkalmazásokban. Ez amúgy előnye az Intelnek, hogy nekik nincs összehasonlítási alapjuk az Arc előttről. Nem fogják felróni nekik, hogy egy régebbi DirectX 11-es cím az új IGP-ken 3-6x lassabb, mint a régin. Az AMD-nek és az NV-nek ezt felrónák. Mert kb. ennyi lassulással kell ezen áramkörök nélkül számolni. Nem véletlen, hogy az Arc meghajtónál 200-300%-os gyorsulásokról voltak hírek egy-egy játéknál, amire írtak direkt támogatást. De kb. van több ezer DirectX 11-es cím, és ebből fehérlistás úgy 100-200. Tehát a többség még mindig emulálva fut.

[ Szerkesztve ]

-

S_x96x_S

addikt

válasz

paprobert

#48275

üzenetére

paprobert

#48275

üzenetére

> Azt tudom csak elképzelni, hogy az integrált RAM jótékonyan hat az arch

> kihasználtságára, és ettől kilő a teljesítmény a relatíve kis méretben.A lunarLake és az előző generáció között teljesen más tervezési filozófiát

és valószínüleg teljesen más tranzisztor könyvtárt használtak ( TSMC3 vs. INTEL4 )"""

George Cozma:

Again, back to the previous generation, you had a GPU, tile, an SOC tile, and an iGPU tile. On Lunar Lake, that’s now all been reintegrated on to a single die. What was the why move back to a more monolithic design for those parts of the design?

Arik Gihon:

Yeah. So it was a trade off, actually. When you start building the project, you start to think which transistor you want to put on which node. And since we have selected the entry, we could fit, more transistors into entry in one monolithic die. And the second is that it was an optimized die just for a specific segment.

You don’t need to stay for the entire family and up to desktops with that. And also, we could just put all of the transistors, all of the compute transistors, on the same die very close to the memory and therefore gain latency and gain performance. So you both gain good process for all of those as well as for the SoC components and the memory components, and closer to the memory.

George Cozma:

And so then sort of a follow-up to that, why did you leave the what you’re calling the platform controller die, as its own separate die? Was that because the stuff on that die doesn’t scale as well with newer nodes?

Arik Gihon:

It just didn’t need to scale. Those transistors are usually controllers for IOs. They can fit nicely into N6’s process, and the IOs are working there very good. So it was a nice partition.

"""

https://chipsandcheese.com/p/an-interview-with-intels-arik-gihon-about-lunar-lake-at-hot-chips-2024-------

Ami még érdekes lehet az Xe2 és az AMD-s tervezési eltérésekről:

"Lunar Lake’s iGPU: Debut of Intel’s Xe2 Architecture"

https://chipsandcheese.com/p/lunar-lakes-igpu-debut-of-intels

-

S_x96x_S

addikt

válasz

paprobert

#48272

üzenetére

paprobert

#48272

üzenetére

> Lunar Lake 3nm:

> 140mm2 a compute tile, amiből a GPU 25%inkább ~ 33% körül lehet;

pl. a "Display Control Logic" - az NPU tól balra található - a 4E core alatt."Next to the NPU is the Xe2 Battlemage integrated GPU,

which, along with its display and media controller components,

occupies nearly one-third of the Compute tile's die area. "

https://www.guru3d.com/story/intel-lunar-lake-processor-architecture-die-and-pch-annotated/

> Strix Point 4nm:

> 232.5mm2 a teljes lapka, amiből a GPU 30%a reddit-en a strix-point - GPU -t 21% -ra becsülték.

"""

Using the best I can get as the subtraction of 2 rectangles (screenshot limitation), the CPU, GPU, and NPU consume 26%, 21%, and 7% of the die area.

4 RDNA3.5 work groups is 3.7% of the die area. The NPU compute is 2.9%.

"""[ Szerkesztve ]

-

paprobert

őstag

válasz

paprobert

#48259

üzenetére

paprobert

#48259

üzenetére

Számoltam die shotok alapján:

Lunar Lake 3nm:

140mm2 a compute tile, amiből a GPU 25%

azaz ~35mm2 a Battlemage GPU méreteStrix Point 4nm:

232.5mm2 a teljes lapka, amiből a GPU 30%

azaz ~70mm2 az RDNA3.5 GPU méreteHa nincs 100%-os sűrűségbeli ugrás a 4nm és a 3nm között (legjobb tudomásom szerint nincs), akkor az Xe2 átlépte az RDNA3.5-öt teljesítmény/lapkaméret metrikában.

Az Alchemist - RDNA2 összehasonlítást látva ez elég hihetetlennek hangzik, de ez jött ki gyors pixelszámolással.

[ Szerkesztve ]

-

S_x96x_S

addikt

válasz

paprobert

#48103

üzenetére

paprobert

#48103

üzenetére

> Az Asus vagy a Lenovo szemszögéből persze hogy drágább

> a Lunar, mint egy Celeron vagy egy Mendocino,

> de látni kell hogy közben az almánál milliószámra hordják

> a vásárlók kb. ugyanezt a szintű hardvert (drágábban).Hogy tisztázzuk a félreértést:

Az Asus és a Lenovo

- meglepő módon nem gyárt Apple-t

- és a saját nyeresége érdekli - nem az ami a mások zsebébe csorog.

> Szóval hol megy félre a versenyképesség?

Ez csak egy jelzés, hogyha drága az Intel,

akkor az AMD alapú gyártást fogják jobban preferálni, mert arra lesz jobban kereslet. -

hokuszpk

nagyúr

válasz

paprobert

#47817

üzenetére

paprobert

#47817

üzenetére

"A Zen1-nél még bő 1GHz előnye volt az Intel-nek, ami mostanra el is fogyott, kis lépésekben."

ezen nagyon nem lepodnek meg, sacc a gyartastechnologia behatarolja az elerheto orajelet ; es mivel az AMDhez hasonloan most az Intel is a TSMCnel gyartat, ezzel kb. ugyanott vannak. Oke, az Intel fejlettebb nodera vett kapacitast ; viszont nekik ez az elso nekifutasuk ; epp eleg mernoki kihivas lehetett a sajat processrol atugrani ; de majd belejonnek, es a kovetkezo iteracioban megjon az orajelplusz is.

[ Szerkesztve ]

-

gejala

őstag

válasz

paprobert

#47742

üzenetére

paprobert

#47742

üzenetére

Alder Lake csak gyorstapasz volt, aztán a Raptorral rögtön totálkárosra is törtek mindent. Most már el kell engedni ezt a történetet, Nehalem óta megszolgálta az idejét. Már nem lehet sem IPC-ben, sem magszámban skálázni ezt az architektúrát anélkül, hogy imádkozni kelljen, hogy ne essen szét valahol.

[ Szerkesztve ]

-

válasz

paprobert

#47277

üzenetére

paprobert

#47277

üzenetére

Xess már vagy 60+ játékban van és kiforrott. A legjobb minőség és teljesítményhez persze kell neki Arc mert annak a hardverét használja (pontosabban az ai gyorsító részt)

Összehasonlítás cyberpunkban:

Cyberpunk 2077: XeSS 1.1 vs. FSR 2.1 vs. DLSS 3 Comparison Review

A legjobb persze az lenne ha az összes létező ilyen tech egyből elérhető lenne minden nagyobb játéknál ami kijön.

Starfieldben modderek pillanatok alatt összerakták hogy működjön frame gen is, csak azért mert fejlesztők hanyagul (vagy direkt) kihagyták a támogatást.[ Szerkesztve ]

-

válasz

paprobert

#47274

üzenetére

paprobert

#47274

üzenetére

A problémát nem a skálázásban látom, hanem abban hogy minden felskálázásnak benne kellene lennie egy A kategóriás címben ha azonos elven működnek. Itt egyértelmű, hogy Intel miatt van benne egyedül XeSS, tehát megint az van hogy korlátoznak, a szponzorációjukért cserébe ami felháborító egy fos dolog 70-80 dolláros játékokban csillagászati áru hardvereken. Ez nem jó tendencia a jövőre nézve és nem jó üzenetet hordoz.

A jó minőségű XeSS csak Intel hardveren fut a DLSS 3,5 pedig nagyon ellépett mindegyiktől minőségben. nemsokára CP 2077 debüt lesz, de már most Redditen nagyon jó tapasztalatokat írnak a DLSS 3,5 ről azok a szerencsések akik kipróbálhatták.

Az FSR meg ugye hozza a framegent az AMD / Nvidia non Ada széria számára is. Tehát mind az FSR mind a DLSS előnyöket élvez jelenleg az XeSS -sel szemben de nem lesz választási lehetőséged.[ Szerkesztve ]

-

huskydog17

addikt

válasz

paprobert

#46851

üzenetére

paprobert

#46851

üzenetére

Logikus, nem lennék meglepve, ha valami ilyesmi történne a jövőben, mert az alapok már adottak ehhez. Bár tippem szerint ez talán jelentősen növelné a játék fejlesztésének idejét és ezzel együtt a költséget is. Ennek ellenére nem lennék meglepve, ha a jövőben majd akadna 1-2 olyan szponzorált játék, ahol lenne az általad is említett Ultra+ szint (mondjuk például a textúrabeállításnál).

-

Petykemano

veterán

válasz

paprobert

#46667

üzenetére

paprobert

#46667

üzenetére

én el tudom képzelni. 2022 elején még azért enyhén leszálló ágban, de azért a csúcs közelébe volt még a bányászat.

Én nem gondolom, hogy az elképesztő GPU árak kizárólag a boltokban kialakult hiány miatt alakult ki. Értem ez alatt azt, hogy a GPU alkatrész gyártók is tervezett mennyiségekkel és árakkal dolgoznak, ha a bolti GPU szűkösség miatt növelni akarják a termelést akkor a tervezetthez képest GDDR6-ból, rézből, alumíniumból is hiány alakulhat ki, ami azok árát is felveri.

Az ábrán a felszálló ág nem látszik, csak a leszálló.Én úgy vélem, hogy az RTX 3000 széria msrp árai nem voltak eleve, tervezetten kamuk. Persze az AIB kártyák ára mindig jellemzően magasabb, de nem annyival, mint amilyen különbség 2020 végétől elkezdett kialakulni. A kialakult extrém kereslet az alkatrész árakra is nyomást gyakorolt, azok árát is felverte és én úgy már tényleg nem fért bele az msrp-be. Nem fogjuk sosem úgy megtalálni, hogy ki járt jól, hogy egyvalakire rá lehet mutatni. Az egész láncban a tervezőtől, félvezetőgyártótól a réz, alumínium szállítótól, összeszelőn át a szállítóig és boltig mindenkinek vastagabban fogott a ceruzája.

Valahol azt is érthetőnek tartom, hogy egy ilyen váratlan és vélhetően nem tartós piaci sokkra nem reagáltak a hivatalos msrp árak folyamatos igazításával.

Úgy fogalmaznék, hogy az akkoriban a hivatalos $329 ellenére $500-600-ért árusított RTX3060-ba valószínűleg tényleg $180 értékben kerülhetett VRAM.

-

Raymond

titán

válasz

paprobert

#46667

üzenetére

paprobert

#46667

üzenetére

Termeszetesen az NV es az AMD nem akkor es nem olyan arakon veszi a RAM-ot, igaz egy 3060 kategorianal nincs megkotes es a partnerek ott veszik ahol akarjak ha jol tudom. Ott pedig ugyanugy nem tudod, de a spot price amolyan worst case aminek veheted es meg akkor se problemas mert MSRP ide vagy oda egy mondjuk MSI Ventus masfel eve meg 600-700EUR-ba kerult es nem 309-be mint most [link] igy belefert az a $13-as arszint

-

Petykemano

veterán

válasz

paprobert

#46161

üzenetére

paprobert

#46161

üzenetére

Én inkább úgy mondanám, hogy egy álló óra is naponta kétszer a pontos időt mutatja.

Ami pedig Abut illeti...

Azért nehéz kérdés - szerintem - mert nem mindig egyértelmű (talán saját maga számára sem), hogy amiket mond, amilyen álláspontot képvisel, az a szakma (grafikus szoftverfejlesztők) álláspontja, vagy az AMD mondja tollba. -

Petykemano

veterán

válasz

paprobert

#45965

üzenetére

paprobert

#45965

üzenetére

"De nem igazán értem, hogy miért még mindig költségeket számolunk, amikor az árak önkényesen vannak megszabva mindkét cég által."

Az, hogy az árakat a költségek indokolják-e leginkább abban a vitában (vagy ha esetleg nem is feltétlenül nevezhetjük két eltérő állásponton levő tábor közötti vitának, de mindenképpen nevezhetjük egy belső vívódásnak), hogy úgymond érdemes-e megvenni.Ha arra jutunk, hogy az árakat az elszabaduló gyártási és szállítási költségek indokolják, vagy legalábbis úgy értékeljük, hogy a megszadott ár, az kellően jó ár/érték arányt jelent, akkor hát nincs más lehetőség, ki kell csengetni a dellát.

Ha viszont arra jutunk, hogy az árakat - ahogy azt sejteted - nem a költségek, sokkal inkább valami növekvő profit-várakozás eléréséhez való piaci igazodás határozza meg, akkor - ha kényszer nincs - be lehet inteni és meg lehet várni, míg a piac láthatatlan keze lejjebb viszi az árakat.

Persze aztán innentől ez chicken game és lehet, hogy kitartanak a cégek.

-

válasz

paprobert

#45904

üzenetére

paprobert

#45904

üzenetére

Ez például egy ok a 110 fokos hotspottra és egyszerűen orvosolható.

Olyan létezik, hogy túl sok paszta. Ez akkor gond ha nem igazán jó minőségü .mert rosszabb a hővezető képessége mint a hűtőnek magának vagy a nem megfelelő kontaktot pont ez okozhatja ha nincs jól ráhúzva ráigazítva a hűtő.Ezek tömeggyártással készülnek ugye.

Ha megnézd a kommenteket van aki eltávolította az eredetit és újrapasztázta vékonyan jó fajta pasztával és lényegesen jobb hőmérséklet kapott.[ Szerkesztve ]

-

Csupingo

veterán

-

Gyuri27

félisten

válasz

paprobert

#45904

üzenetére

paprobert

#45904

üzenetére

Vastag igénytelen pasztázás (a paszta minősége is kérdéses). Vastag thermalpadok.

Rendesen megcsinálva akár 15-20 fokot is lehet nyerni (jó minőségü cucckkal talán többet is).

És akkor még az is kérdéses így rendesen fel van-e rakva a hűtés.

Láttuk asusnál milyen az amikor csak rá van dobálva. -

HSM

félisten

válasz

paprobert

#45898

üzenetére

paprobert

#45898

üzenetére

Nekem a konzisztenciával volt a kisebb bajom CF-nél. A nagyobb az input lag volt, ugyanúgy késett a kép 60FPS-el, mint ahogy 30-al, nem jó úgy játszani. Kb olyan élmény volt, mintha egy befőttesgumival próbálnám rángatni a karaktert....

A CF is ideális tartományban ezt hozta, magas lag, valamivel simább képi élménnyel.

A CF is ideális tartományban ezt hozta, magas lag, valamivel simább képi élménnyel.

A CF-et is ezért vetettem el annak idején, amiért itt is feleslegesnek tűnik. 55-60 FPS ha már megvan, akkor duplázás nélkül is jó az élmény, főleg egy megfelelő sync-képes monitorral (enyém 48-144Hz között működik, jobbak legalább hasonlót tudnak már). 20-40-ről lenne jó duplázni, de ott meg ismét nem jó, mert egekben a lag.... Akkor jó most ez valamire?

Az FSR-t is sokan dícsérik, nálam kb. 10 másodperc sok is volt belőle... Aki ezt bírja nézni natív helyett, egészségére.

DLSS-t nem néztem még, most épp polcon van az RTX3060-am.[ Szerkesztve ]

-

Petykemano

veterán

válasz

paprobert

#45891

üzenetére

paprobert

#45891

üzenetére

Azért ehhez kellett 5 év.

2017-ben még úgy jelent meg a 6-8 magos ryzen, hogy "á minekaz? 4 mag mindenre is elég"

Aztán persze ez relatív hamar megdőlt, és a 6 mag indokolttá vált, de a 8 fölötti magszám már inkább olyan prémium volt, amit csak azok engedhettek meg maguknak, akik dolgoztatták is a magokat.Ez alapján most úgy tűnik, hogy a generációnkénti jelentős IPC emelkedés ellenére a 6-8 magos CPU-kra lehetne azt mondani, hogy mindenre is elég és a 12-16 magos procikra azt, hogy "áh, minekaz?" és úgy tűnik, nemsokára eljön a pillanat, amikor 12-16 magos processzort kell majd játékra venni.

Vagyis... ez most egy ilyen VS

Mert ha DLSS-t használsz, akkor talán nem.

De amit mondani akartam az épp az, hogy az AMD kezében tulajdonképpen most ott van egy fegyver ez ellen. Ahogy érvényes mondás lehet az, hogy "minek vegyek drága sokmagos CPU-t, ha ott a DLSS3, ami megvéd a CPU limittől", úgy legalább annyira érvényes mondás lehet, hogy "minek használják DLSS3-at a CPU kíméletének céljából, ha egyébként van elég erős CPU elérhető áron""ha van elég erős CPU elérhető áron"

Lehetne pl a $200-250 Ryzen 5: 8 magos

És $300-350 egy Ryzen 7: 12 magosMost ezt nem azért mondom, merthogy én erre vágyom és máris rohannék a boltba.

Csak hogy ebben a kérdésben az AMD-nek lenne mozgástere.Felmerült bennem még az a kérdés is, hogy vajon a CPU terhelése AMD kártyával is ilyen magas?

-

Busterftw

nagyúr

-

Petykemano

veterán

válasz

paprobert

#45588

üzenetére

paprobert

#45588

üzenetére

Azon gondolkodom, vajon praktikus lenne-e az Intelnek sűrűbb fejlesztési ciklussal - tick-tock módszerrel - fejleszteni?

Az AMD és az nvidia manapság 2 éves fejlesztési ciklussal dolgozik. Ebben általában benne van egy gyártástechnológia és egy architektúra váltás is. Régen nem így volt. Egyrészt kb évente jött új generáció, másrészt minden második generáció az architektúra finomhangolása és felskálázása volt azonos gyártástechnológián

Szóval vajon hasznos lenne-e.az intelnek, ha a Battlemage azonos gyártástechnológián (N6) egy a szűk keresztmetszeteket korrigáló, felskálázása lenne (most itt a lapkaméret növelésétől tekintsünk el, mert így is elég nagy), ami hamar jön.

-

Yutani

nagyúr

válasz

paprobert

#45558

üzenetére

paprobert

#45558

üzenetére

A 300 mm waferből egy 406 mm2 felületű chip esetén 133 darab jön le, mondjuk legyen 10% a selejt (lehet, hogy kevesebb igazából), így durván 120 darab a használható chip. A wafer ára valahol $10k körül van (ennyi volt a 7nm esetén), így egy chip olyan 83 dollár körül jön ki az A770 GPU-jának az ára. Így ebből persze, hogy drága kártya lesz, ami az előállítását illeti.

Ugyanez Nav23 esetén 47 dollárra jön ki.

-

Petykemano

veterán

válasz

paprobert

#45556

üzenetére

paprobert

#45556

üzenetére

> Mindegy, lesz honnan engedniük az árból.

Gondolod, hogy ez a 329 már nem önmagában önköltségi ár?Ha ezen még mindig van némi nyereség is, akkor az elég brutál árrést jelent a hasonló teljesístménnyel bíró és hasonló áron adott, de feleakkora Navi23 esetén.

És elég brutál árrést fog jelenteni a mondjuk 3080-ra lövő Navi33 esetén, ami még a navi23-nál is kisebb, viszont Abu szerint $400-500* magasságban kívánják értékesíteni.* Nem kizárt, hogy ez a $400-500 alapvetően a bánya korszak csúcsán létrejött elképzelés volt, amikor az anyagárak és csúcson voltak, amit a bányaomlás, a használt kártya piacon megjelenő áruk és persze a energiaárak által átszabott költségvetések alapvetően fognak megváltoztatni

Ugyanakkor ez a 400-500 dollár alapvetően irányban van az Nvidia most bejelentett árazásával. -

Petykemano

veterán

válasz

paprobert

#45261

üzenetére

paprobert

#45261

üzenetére

"Szóval ugyanakkora lapkát, ugyanakkora teljesítménnyel, de teljesen áttervezve? Az egy helyben járás esete lenne, és pénzbe kerül."

Nem, mert elvileg alacsonyabb a fogyasztása.

De ez majd kiderül, ha a N5-ön készülő Zen4-et lehet hasonlítani a szintén N5-ön készült M1-gyel, vagy az N4-en készülő mobil lapkát az M2-vel.Illetve hát 1-2 éven belől talán megjelenik a Nuvia szerver chip is, amit feltételezem, hogy a Qualcomm fog akarni kipörgetni mobil lapkákba is.

-

Petykemano

veterán

válasz

paprobert

#45257

üzenetére

paprobert

#45257

üzenetére

"Szerintem legnagyobb különbséget az adja, hogy az Apple egy konkrét node-ot, konkrét célokkal, konkrét irányszámokkal, jó mérnökökkel vesz kezelésbe, és van erőforrása eltérni az ARM univerzálisan-univerzális döntéseitől."

én úgy tudom, hogy az arm designok esetén is mindig megvan a target node. Attól persze el lehet térni, de a számokat az arm úgy mutatja be. Azt gondolnám, hogy ha nagymértékben számítana.az, hogy az arm mag könnyen portolhatóan különböző gyártástechnológiákra, akkor ha az arm nem is, pl a qualcomm biztos elkészítene egy olyan változatot amit egy specifikus node-ra optimalizálva learathatja az előnyöket. De az utóbbi időben a qualcomm is felhagyott a módosított arm magok tervezésével. Vagy legalábbis nagyon kicsi a különbség.És így belegondolva az Apple esetén sem teljesen igaz, az, hogy szuperfókuszált célok mentén készült volna az architektúra.

Az igaz, hogy az arm univerzális magokat készít. De azért a fókusz alapvetően a mobil és kis fogyasztás volt mindig is. Nem is lehet gyári arm magból versenyképes asztali processzort csinálni.

Az is igaz, hogy az intel és az AMD a szerver szegmensre fókuszál és onnan származtat más piacokra.

De az se igaz, hogy az Apple processzora csupán egy piacot célozna - hiszen ugyanaz az architektúra fedi le az iphone és a sokmagos bigmac piacot is.Azt lehetne újra felvetni, hogy jójójó, de a szerverpiac abban különbözik az eszközpiactól, hogy ott ki kell szolgálni egymástól független programszálak gyors futását. Emiatt nagyobb hangsúlyt kap a privát cache, míg a jellemzően csak egy (vagy néhány kevés erőforrást igénylő) foreground processz kiszolgálásához megengedhető, sőt hasznos az erőforrásmegosztás. De ez csak az L2$ esetében állja meg a helyét.

"A magasabb IPC nem jelent automatikus perf/watt előrelépést, sőt."

Persze hogy nem. Az jelenthet perf/w előrelépést, ha alacsonyabb órajelen, leginkább ha alacsonyabb feszültségen működik a processzor.

A magas órajel elérése sincs ingyen', mármint ahhoz is kell tranzisztor - abu ezt szokta mondani.

Nekem az a gyanúm, hogy a magasabb teljesítmény elérésehez mindig több tranyó / nagyobb lapkaterület és több fogyasztás szükséges. Ha IPC-ből hozod össze, akkor jellemzően inkább a tranzisztor és lapkaterület költsége lesz nagyobb, ha frekvenciából, akkor pedig a fogyasztás.

Az nem mindegy, hogy ki milyen korlátokba ütközik és milyen költséget tud áthárítani. Nekem az a gyanúm, hogy az AMD és az intel is képes lenne olyan architektúrát lerakni az asztalra, mint az Apple. Csakhogy az apple saját piacának kiszolgálása érdekében nem ütközik sem kapacitás, sem árérzékenységi korlátba. Tehát bevállalhat másfélszer akkora lapkát is, mert a TSMC le fogja tudni szállítani a szükséges mennyiséget és a vásárlók meg fogják fizetni kerüljön bármibe.

Az AMD és az intelt nagyobb és árérzékenyebb piacot szolgál ki. Ha spórolni tudnak a lapkaméreten, akkor azzal nem csak eladásszámaikat tudják növelni az alacsonyabb ár miatt, hanem mert szűkös kapacitásaikkal több terméket tudnak előállítani. A teljesítménybeli előrelépést a lapkaterületen spórolva inkább magasabb frekvenciávak oldják meg - annak költségét így a vevőre átterhelve.Ebben az elméletben csak egy szépséghiba van

Konkrét számaim nincsenek, de az látványos, hogy N7-en az Apple és más arm designok megközelítették a névleges tranzisztorsűrűséget, addig az AMD jócskán elmaradt. (50-70%)

Tehát ha azt feltételezzük, hogy a gyengébb tranzisztorsűrűséget csupán a magas frekvenciára célzás okozza, akkor jogos lenne felvetni, hogy nem lehetne-e vajon ugyanazt a teljesítményt ugyannakora lapkaterületből több, sűrűbben elhelyezett, de alacsonyabb frekvencián működő tramzisztorból kihozni úgy, hogy az IPC magasabb.

Na és itt mondom azt, hogy az Apple eltalálhatott Valamit, mert egyszerűen nem látok más magyarázatot egy ilyen design megszületésenek elmaradására,.minthogy tényleg nem tudja megcsinálni az Intel és az AMD.

Vagy mert nem nőne olyan mértékben a tranzisztorsűrűség, vagy mert nem rendelkeznek azzal a tudással, hogy kéne magasabb IPC-t elérni. (Cserébe persze lehet, hogy az arm/Apple sem tudna 5-6GHz-es procit ledobni csak úgy, alapos újratervezés nélkül) -

Petykemano

veterán

válasz

paprobert

#45254

üzenetére

paprobert

#45254

üzenetére

Jó a leírásod, de picit azért vitatkoznék vele.

Ha a kérdést nem úgy tesszük fel, hogy Apple vs Intel/AMD, hanem hogy Apple vs Arm akkor egyrészt kiszűrtük az architektúra és a "más fókusz" tényezőket is.

A hagyományos Arm architektúrák (X1-X3) miközben ugyanúgy nem lőnek magas órajelre (abunak valószínűleg igaza lehet abban, hogy ehhez speckó/saját library kell), ugyanúgy hiányzik onnan az Apple által elért IPC, mint az x86 esetén.Széles körben ismert, hogy a magas IPC-t eredményező széles architektúra sok tranzisztort igényel. Az Apple nyilván pénz nem számít alapon tud olyan méretű lapkát készíteni, ami az igényeknek megfelel, és akár kétszer drágább is lehet. Viszont a magas frekvencia elérése sincs ingyen, ahhoz is tranyókat kell áldozni, meg kisebb tranzisztorsűrűséget lehet csak.elérni,.stb.

A semianalysis.cikke.szerint az M2-ben egy P magra ~5.3mm2 jut. Ha ezt felszorzod 8-cal, akkor kisebb lapkát kapnál, mint a zen4 CCD. (72mm2)

Valamit az Apple nagyon megtalált, vagy eltalált.

Ez lehet a széles architektúra - az Intel és az arm is próbál szélesíteni, de még nem tartanak ott. Valószínűbb, hogy az alacsony késleltetésű és Nagy L1$ és L2$ az igazi Nagy durranás. (A széles architektúra és a nagy cache persze feltételezik egymást)

Azért gondolom ezt, mert Abu is és a ChipsandCheese is méltatta az AMD-t, hogy milyen remek a L3$-ük. Tehát az tényleg létező dolog a CPU tervezés terén, hogy egy jó SRAM cache designnál előnyre lehet szert tenni.

(Valamit persze közben az AMD is alkotott, mert kb ugyanakkora lapkaterületre külön gyártva kb kétszer akkora cache kapacitást hoztak ki a 3dcache-hez.)Szóval az eltérő fókusz magyarázhat a különbségből valamennyit, de szerintem mindenképpen van ott tudás, amit még az arm sem hozott, pedig ugyanaz a fókusz.

Nem mellesleg szerintem az AMD és Intel fókusza a szerverpiac, ahol szintén jobban járnának, hogy magas órajel helyett inkább kisebb lapkákkal és/vagy magasabb frekvencia helyett magasabb IPC-vel tudnánnak dolgozni.

-

Busterftw

nagyúr

válasz

paprobert

#45254

üzenetére

paprobert

#45254

üzenetére

Plusz itt arra is kell gondolni, hogy az Apple egy zart okoszisztemaval indul.

Naluk van a szoftver es a hardver is, sokkal egyszerubb a platformot osszegyurni annak minden elonyevel (es hatranyaval).Ha az AMD/Intel kiadna valami hasonlo kaliberu ARM cuccot, a Windowson pl eleg sokat bukna a dolog. Ezzel szemben az Apple ugy tudta fejleszteni a sajat OS-t, hogy az megfeleloen mukodjon az erkezo ARM designnal es forditva.

Szerintem is mindkettonek megvan a maga piaca, szerintem nem egyertelmu ez a "kreativ" dolog. Haverom is "kreativ" szakmaban dolgozik, de Ryzen+Nvidia gpu-val dolgozik, ahogy naluk mindenki a cegnel.

-

válasz

paprobert

#44939

üzenetére

paprobert

#44939

üzenetére

Ez 3 nm vagy alatta varhato.5 es 4 nm mar a TSMC nel lesz,ez biztos.Abban meg intel varhatóan jó lesz már.

Nem vagyok benne biztos amugy, hogy ez nem valamifele hatterben megbujo egyeb megallapodast takar.Nvidia odalapatolja a gyartasert a penzt aztan gyartason kivul lesz masrol is megallapodas.Eleg erdekes mar most is az Intel Nvidia osszeborulasa DLSS XeSS nel .Ezet irtam hogy a vegen lesz licensz x86 hoz...[ Szerkesztve ]

-

Busterftw

nagyúr

válasz

paprobert

#43279

üzenetére

paprobert

#43279

üzenetére

Azt is vedd figyelembe, hogy mondjuk 2016-ban 300 dollar iden mar 340 dollar. Plusz az emberek fizetese is no.

Szoval oke, hogy kell egy budget kartya, de hany evig legyen a budget 250 dollar? Amig 250 dollar egy doboz gyufa lesz?

Hasonlo pelda a 60 dollaros jatek, hany evtizede 60 dollar az AAA?

Most hogy 20 ev utan novelnek 70-80 dollarra, mindenki kiakadt.

-

HSM

félisten

válasz

paprobert

#43279

üzenetére

paprobert

#43279

üzenetére

A szabadságnak is megvan az ára, nemigaz?

![;]](//cdn.rios.hu/dl/s/v1.gif)

"nincs modern gaming $350 alatt"

Az RTX3060 amúgy szerintem annyira nem rossz belépő holmi a 330 dolláros MSRP-jén, azzal némi kompromisszummal azért meg lehet próbálkozni mai címekkel is. Majdnem olyan fürge, mint egy régi 1080 Ti, azért az nem olyan rossz. Főleg, hogy egy éve 280 dollár volt egy 5600XT is. Házon belül is sokkal barátságosabb vétel, mint annak idején 350 dollárért a sima 6GB-os 2060 volt.

Főleg, hogy egy éve 280 dollár volt egy 5600XT is. Házon belül is sokkal barátságosabb vétel, mint annak idején 350 dollárért a sima 6GB-os 2060 volt.[ Szerkesztve ]

-

HSM

félisten

válasz

paprobert

#43277

üzenetére

paprobert

#43277

üzenetére

"Ha ma több folyik be, abból leginkább bónusz és osztalék lesz."

Ennek ellentmond a pénzügyi beszámoló, mindkét cég jelentősen többet költött R&D-re, mint egy évvel ezelőtt ugyanebben a negyedévben. Persze azzal nyilván egyetértek, hogy a sok pénz önmagában nem garancia a következő jó termékekre."két betűvel is tudom érzékeltetni hogy mi volt a gond"

Pont erről beszéltem, hogy extrém "kockázatos" befektetés egy ilyen cég, elég volt egy picit rosszul időzíteni egy terméket (a szoftverek még nem álltak készen ilyen sok szálat hatékonyan használni) és még némi gyártástechnológiai pech (az órajel se jött össze) és már akkora volt a baj, hogy majdnem magával vitte az egész céget."Előbbi esetben a cégek a helyzet elszenvedői, és csak úsznak az árral, míg utóbbi esetben az okozói."

Nyilvánvalóan van/volt ráhatásuk. De a usernek is van ám ráhatása elég komolyan a pénztárcájával. Megveszi-e, kifizeti-e, avagy szépen megvárja, míg a számára megfelelő árszintre nem süllyed a termék. Ez a szabad piac, nem igaz?

Ez a szabad piac, nem igaz? -

HSM

félisten

válasz

paprobert

#43275

üzenetére

paprobert

#43275

üzenetére

A céges racionalitás ha tetszik, ha nem az, hogy a cég működőképes és profitábilis legyen, amihez az kell, hogy tartósan versenyképes maradjon.

Én azt látom, hogy a 2021Q1 nem mutat jelentős eltérést az "árrobanás" előtti 2020Q4-es számokhoz képest [link] . Az is szépen látszik, hogy az összes bevétel 54%-a volt a termékek önköltsége, ami nagyon nagyon nem 5%, mint amit említettél (főleg, hogy egy VGA esetén még költség a PCB, hűtés, VRM és egyebek is, az AMD úgy tudom csak a GPU-t és a ramokat hozzá biztosítja a partnereknek). Ha az egyéb költségeket is hozzáveszed, mint pl. R&D, marketing, akkor úgy látom, a végén a 3445 millió USD árbevételből keletkezett 662 millió dollár tiszta profit. Azért az szvsz nem feltétlen az "úszunk a pénzben" esete egy ekkora cégnél.

"Visszatérnek a teljesen normális, büszkeségre okot adó profitrátához, ami 25 évig elég volt."

Arra gondolsz, amikor egyik veszteséges negyedév követte a másikat?

Ha már vs. topik érdekes lehet összevetni a konkurencia beszámolójával [link] . Úgy látom, náluk azért valamivel vastagabban fogott azért a ceruza.

![;]](//cdn.rios.hu/dl/s/v1.gif)

[ Szerkesztve ]

-

HSM

félisten

válasz

paprobert

#43273

üzenetére

paprobert

#43273

üzenetére

Egyébként úgy tudom nem az AMD/Nvidia hajtotta fel az árakat, ők elvileg nem emeltek árat a partnereik felé, ha vaalkinek van erről biztos információja, jelezze.

Természetesen nekik így is pokoli jó most, hogy kb. mindent eladnak, amit le tudtak gyártani. De azért vegyük észre azt is, hogy nemrég még az AMD pl. a csőd szélén állt. És lehet, pár év múlva ismét nem lesz olyan fényes a helyzetük, nyilván az Intel, az Nv és most már az Apple sem nézi tétlenül a történéseket és az egyéb, RISC alapú versenytársak is erősödnek. Tehát most nagyon is fontos profitot termelni, és a jövőbeli termékek fejlesztésére fordítani, hogy megmaradjon a versenyképességük. A lapka fejlesztési költségeiről pedig manapság fontosabb beszélni, mint valaha, mert pokoli drága lett egy lapkát piacra vinni. Lásd pl. [link] .

És még arról sem árt filozofálgatni, hogy mi fog történni, ha mondjuk negyed- fél év múlva komolyabban alább hagy az idei nagy bányász idény, és a korábbiakhoz hasonlóan ellepi az aprót a használt VGA dömping... Az AMD egyszer már megütötte ezzel a bokáját az R9 390-es lapkával, alig győzték kisöpörni őket a raktárból, pedig előtte mekkora üzletnek tűnt, hogy mindent elvittek míg szezon volt.....

[ Szerkesztve ]

-

HSM

félisten

válasz

paprobert

#43208

üzenetére

paprobert

#43208

üzenetére

"natívnál kisebb render soha nem lesz a monitoromon!"

Személy szerint én maradok a natívnál, eddig bevált.

Ezeknek a technológiáknak a létjogosultságát két esetben látom:

- Nincs elég harapós VGA a gépben a natív felbontáshoz, és még ez ront a legkevesebbet a képen

- Túl nagy a monitor felbontása a méretéhez képest, és úgysem látjuk a különbséget (pl. 4K 28") -

válasz

paprobert

#43122

üzenetére

paprobert

#43122

üzenetére

Szerintem nincs lemaradásban. ha igaz amit írnak akkor a 6800 3070 Ti körül teljesít. persze a 6800xt-6900- 3080 -3090 nincs meg de ezt nem nevezném lemaradásnak , max a felső kategóriás GPu hiányának. legtöbb embernek még a 2080 Ti szint nincs meg mert ugye az új generációk az átlag pénztárcájú emberekhez nem értek el még. Szerintem ez év végére 16 GB rammal vonzóbbá teheti, mint az nvidia Ampere szériát , főleg ha alááraznak. Mondjuk $399 egy 3070 teljesítményért.

-

Petykemano

veterán

válasz

paprobert

#43053

üzenetére

paprobert

#43053

üzenetére

Hát ez olyan kérdés, hogy mindig vannak trade-offok.

Én azt gondolom, hogy a működtethetősége két dologtól függ:

- mennyi magra skálázódnaka programok.

Elvileg itt már 2022.végétől talán jöhet mageső, 24 magos zen4, stb. Bár mindig ott lebeg az egymásra várás (nem skálázzuk a programot,.mert úgysincs hardver, ami kihasználná, nem adunk több magot, mert...), ez szerintem mindig inkább hardver-driven lesz. Mármint előbb látom eladhatónak a több magos CPU-t, amit egy ideig még kevés szoftver használ ki, mint a több magra skálázódó szoftvert,.akihez nincs' elég mag.

- a skálázódás során mennyi az alacsony lésleltetésű clusterbe szervezhető magok számának minimuma.

Ugye a zen2->zen3 esetén láttuk, hogy ennek azért volt jótékony hatása. Most ez a 8mag/L3$ optimálisnak tűnik.Tehát akkor.tud működni a big.LITTLe (little = efficiency core), ha skálázódás magas, de a cluster minimum kicsi. Mondjuk 8/32

Szerintem. -

HSM

félisten

válasz

paprobert

#43053

üzenetére

paprobert

#43053

üzenetére

Attól, hogy ketten is beleugranak a kútba, attól még nem biztos, hogy ez volt a jó döntés...

Elképzelhetőnek tartom, hogy idővel ez lesz a jó irány, de azért sokmindenen elbukhatnak ezek a koncepciók. Pl. az Alder esetén a kis magok eltérő utasításkészlete pl. határozottan nem tűnik jó rajtnak.

-

-

válasz

paprobert

#42984

üzenetére

paprobert

#42984

üzenetére

hát a radeon 7 az kb 2080 super majdnem 3060 Ti szint. Ha arra ráhúz még egy kis órajelet akkor azért a 3070 vagy fölötte lehet. Azt azért szintén Raja alatt adták ki pár éve, elavultabb gyártáson- Én nem tartom elképzelhetetlennek a 3070 körüli szintet, néhol akár fölötte is.

-

válasz

paprobert

#42815

üzenetére

paprobert

#42815

üzenetére

Vega vs Pascal idejében is magasabb volt ez már, kb 0- 10 % körüli értékben az új API-k alatt.

De ebből nekem az jön le amit Abu írt, hogy a szoftveres optimalizáció hiányzik, nem driveres gond,. maga a következtetés a driverre levonatkoztatva hibás a tesztben szerintem.[ Szerkesztve ]

-

-

Laja333

őstag

válasz

paprobert

#42802

üzenetére

paprobert

#42802

üzenetére

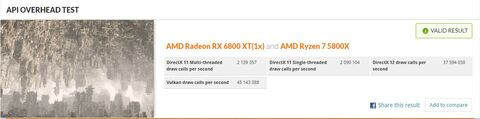

Mondjuk egy 3080/3090-nél talán ebből nem lesz probléma, mert oda illik egy erős CPU-t rakni. Viszont 3060/3070-nél már nem biztos, hogy mindenki alárakja a top CPU-t (az i5 kihajcsaje?). Egy gyengébb CPU-val az emberek lehet jobban járnak a 3070 helyett egy... 5700XT-vel.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Egyébként én is kíváncsi voltam erre és pár hónapja futtattam egy API Overhead tesztet a 6800XT-vel meg a 3080-al ugyan abban a configban, ezek lettek:

[ Szerkesztve ]

-

huskydog17

addikt

válasz

paprobert

#42802

üzenetére

paprobert

#42802

üzenetére

Ez az első HW Unboxed teszt, ami az én szememben eléggé sántít, ugyanis AMD oldalon csak 6 magos CPU-kat tesztelt Steve, míg Inteltől egy darab 4 magosat, ez így eléggé fail. Ahogy FLATRONW is mondta a 4 magos Intel CPU jobb teljesítményt hozott, mint az első két genes Ryzen, ami nem meglepő, hisz tény, hogy a Ryzenek első két generációja jóval gyengébb IPC-ben a Comet Lake-nél. Úgy lett volna fair, ha egy Core i5-10400F is benne van a tesztben, ez a CPU ráadásul még olcsóbb is, mint a tesztben szereplő Ryzen 2600X.

Elkezdtem nézni a videót, de amint megláttam, hogy a 6 magos Ryzeneket a 4 magos Comet Lake ellen küldte, kikapcsoltam.

Értem én, hogy AMD-nél jobb volt a tempó, na de mi van ha egy 10400F mellett teljesen eltűnik az NV "hátránya"? -

FLATRONW

őstag

válasz

paprobert

#42802

üzenetére

paprobert

#42802

üzenetére

Igazából ez csak Low end CPU-knál jelent problémát, alacsonyabb felbontás és minőség mellett. Úgy tűnik, hogy egy i3 10100 az 2600x teljesítményét hozza. Kíváncsi lettem volna arra is, hogy ilyen beállítások mellett egy 6/12-es Intel milyen teljesítményt hozna ki az NV GPU-kból. Lehet, hogy csak a AMD CPU mellet ilyen nagy a különbség.

-

#09256960

törölt tag

válasz

paprobert

#41836

üzenetére

paprobert

#41836

üzenetére

"Az hogy fordulhat elő, hogy az Intelnek megéri egy kb. ~300 dolláros kártyát egyből a TSMC 6nm-es gyártósorára vinni, míg az Nvidia-nak és az AMD-nek ugyanez a node túl drága jóval drágább"

Úgy fordulhat elő hogy Mikor NV odament hogy Helló kellene 7nm nekem jó sok, van kedvezmény?

Akkor azt mondták neki hogy Helló 2 éve megy a 7nm ezt nem lehet csak úgy elkezdeni amikor akarod.

Intel odament amikor tervezték a 6nm-ert neki van.

A chipletnek pont ez a rohadt nagy előnye, csinálsz egy ilyen Tilet , csempe mozaik, nagyon hülyén hangzanak magyarul, de ez sokszorosítható ameddig akarod és megvan a portfólió.

Ők kiadtak egy ilyen zsebsárkányt 1 Tilevel fél éve, de nem kereskedelmi forgalomba hanem megtanulnak rajta drivert írni, és mikor megy akkor beindul a nagyüzem. A chiplet állítólag teljesítménybummot hoz 2-3 szoros teljesítmények lesznek RDNA 3 is már erre épül.

Hogy hol éri meg úgy hogy ilyet csinál belőle, és a mérete ellenére nagyon kicsi a Vafer veszteség!

Na ez már GPU Ha meg elromlik jó hólapátnak is

Ha meg elromlik jó hólapátnak is

[ Szerkesztve ]

-

Pug

veterán

válasz

paprobert

#41820

üzenetére

paprobert

#41820

üzenetére

En 250 watt folott nem erzem magam annyira kenyelmesen, ha barmelyik komponens fogyaszt... mondom ezt ugy, hogy 8 eve egy kazan CPU-t es VGA-t nyuzok, es mindketto OC es full load mellett 250 folott eszik...

Engem a mostani nV paletta fogyasztasa se zavar... csak annyira tipikus, hogy azok a fanboyok, akik frocsogtek erre az elmult evekben, ugy hallgatnak mint a sir.... (nem akarok neveket mondani, de annyira azert nem lepet meg, hogy pl Egon nem veri az asztalt a 3080/3090-es topikban...

)

) -

Petykemano

veterán

-

do3om

addikt

válasz

paprobert

#40752

üzenetére

paprobert

#40752

üzenetére

Az a baj hogy a hardver gyorsulása nincs arányban a kapott képi minőséggel. Pl. pc-n ott a mindig felhozott crysis, amikor kijött azóta hányszor gyorsabbak is a hardverek? A minőség arányos ehhez képest?

Akár mennyi erőforrást képesek a fejlesztők elpocsékolni, úgy hogy azt gondolt mindent kihasznál (maxon pörgő vga, cpu, le nullázott ram), pedig jobb megfogalmazás rá hogy feléli, de nem hasznosan.

-

válasz

paprobert

#40745

üzenetére

paprobert

#40745

üzenetére

azt értem de a több és részletesebb objektum elsődleges feltétele a gyorsabb központi számolóegység, nem a Vram mennyisége. Egy RX 580 16 GB rammal sem lesz 5700 XT. Maga a Vram ha eddig korlátja volt bárminek az a textúrák felbontása szerintem amit nem nevezhetünk forradalmi opciónak.

Attól hogy lesz 20 GB ram egy PS4 pro vagy egy 5700/ 2070 nem lehetne jobban terhelhető számításokkal, max a textúra felbontását lehetne kitolni és kb ennyi. Lásd Radeon 7.

Nekem ez egy kicsit vissza fele gondolkodásnak tűnik.

Ettől függetlenül lehet, hogy igaz.[ Szerkesztve ]

-

wjbhbdux

veterán

válasz

paprobert

#40438

üzenetére

paprobert

#40438

üzenetére

Olyan jólét van most (mondhatni Magyarországon is), hogy se egy drága PC se egy drága konzol nem kiadás. Csak azt nézik hogy kinek mi a kényelmes, mivel játszanak a haverok. A PC úgy lendült fel az utóbbi években, hogy rekord drága volt sok alkatrész, DDR4 lehúzás, GPU bányászláz, Intel "készlethiány", senkit se zavart.

Ez a garasoskodás hogy most a konzol olcsóbban kijön max akkor lesz ütőérv ha lesz egy újabb gazdasági válság és nem töltik majd talicskával a pénzt az emberekre egy ideig. -

válasz

paprobert

#40438

üzenetére

paprobert

#40438

üzenetére

Mondjuk azért a Switch kb annyi eladást produkált az Nvidiának fele annyi idő alatt,mint az Xbox One az összes verziójával az mellett elkelt jó pár millió shield is.

smerve Nvidiát még azt is elképzelhetőnek tartom hogy pénzt is jóval többet kerestek rajt, mint AMD.

De nem a hardver határozza meg továbbra sem szerintem egy konzol életképességét.

Ráadásul egy meg sem jelent konzolgenerációt magasztalunk rengeteg ismeretlennel ,aminek a kijöveteléig valószínűleg Nvidia a piacra dobja az Ampere generáció és ha tartják a szokásukat akkor a 3060 kb 2080 erősségű kártya lesz.....Mondjuk akkor azért kíváncsi lennék mi lenne ha az Orin soc visszaköszönne az Új Nintendo asztali konzolban

Kolbi_30 :

2080 is van a cikkben nem csak a 2080 Ti.[ Szerkesztve ]

-

DudeHUN

senior tag

válasz

paprobert

#40201

üzenetére

paprobert

#40201

üzenetére

Ez minden(!) gen váltásnál előjön. Ez nem így megy. Ha így gondolkodnának sosem indulna be az új generáció. Negyedévente egy 1,5-2 milliós eladást produkálnia kell a gépnek különben nem lesz sikeres. Ha meg nem lesz meg egy év alatt az 5 millió kb. az a platform bukott. Egyik cég sem akar dollár milliárdokat bukni. Az MS és a Sony is egyszer vállalta ezt csak be. Sony majdnem belerokkant.

A PS4 jelenleg 3 milliós negyedéveket hoz folyamatosan. Karácsonykor meg 6-8 milliókat. Xbox kb. fele.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

MLiD biztos szívott valami durvát, hogy ilyesmit behaluzott.

MLiD biztos szívott valami durvát, hogy ilyesmit behaluzott.

Megsporolhattal volna magadnak 25percet ha nem nezed meg.

Megsporolhattal volna magadnak 25percet ha nem nezed meg.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Ez a szabad piac, nem igaz?

Ez a szabad piac, nem igaz?