Hirdetés

- Felháborodott az Apple, a Meta az iPhone-felhasználók üzeneteit akarja olvasni

- A luxusmárkáknak kell a bitcoin, az USA jegybankjának nem

- Letiltja az USA a politikusokat a telefonhívásokról és szöveges üzenetekről

- Nagy áttörés jön a napelemek piacán, nem kell annyi hely a paneleknek

- Belenyúlt az USA az Epic Games igazgatótanácsába, nyomoz az NVIDIA

- Windows 11

- OpenMediaVault

- Internet, TV, és telefon szolgáltatók, pro és kontra

- Bittorrent topik

- Vodafone otthoni szolgáltatások (TV, internet, telefon)

- JavaScript topic

- Telekom otthoni szolgáltatások (TV, internet, telefon)

- WLAN, WiFi, vezeték nélküli hálózat

- Kodi és kiegészítői magyar nyelvű online tartalmakhoz (Linux, Windows)

- Linux kezdőknek

-

IT café

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Petykemano

veterán

DLSS3

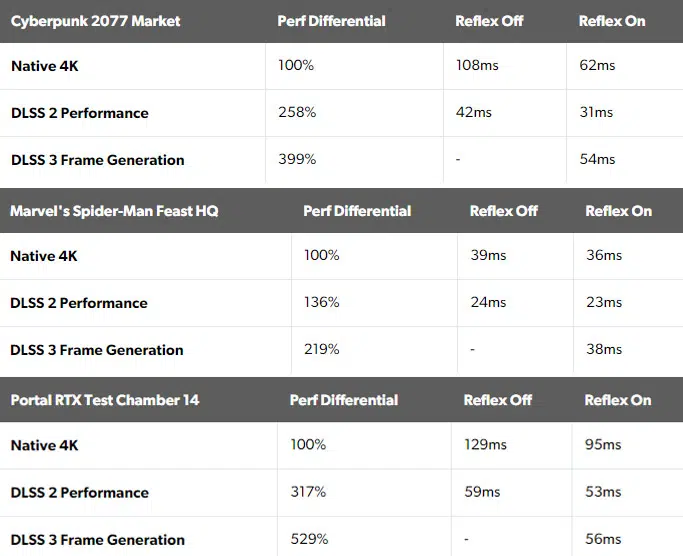

Amikor bejelentték, nekem az volt a meggyőződésem, ez jött le a leírásokból, hogy a CPU és GPU együttműködéséből renderelt két képkocka között a DLSS3 renderel egyet az előzőekből számolva, párhuzamosan, de gyorsabban, mint ahogy a CPU-GPU renderelt képkocka elkészülne.

De úgy tűnik, hogy nemhogy csökkenti, hanem növeli a frame-time-ot. (a csak felskálázást alkalmazó DLSS2-höz képest)

[link]

Ami arra utal, hogy tulajdonképpen nem úgy működik, hogy "megjegyzi" az utolsó két képkockát, amit már kiküldött a kijelzőre és amire a felhasználó megfelelő reakcióidő mellett reagálhat, hanem az utolsó egy-két képkockát tulajdonképpen visszatartja, elkészíti az AI generált 2.5-ik képkockát és csak utána engedi a kijelzőre.

Én nem hiszem el, hogy az AI képgenerálás annyira hosszú ideig tartana, hogy tehát hogy tényleg hosszabb ideig tartana, mint a rendes frame generálás. Biztos, hogy sokkal kisebb erőforrás és időigénye kell, hogy legyen.

Azt sem hiszem el, hogy a GPU ne tudná megjegyezni az utolsó két CPU-GPU által generált képkockát és a következő CPU-GPU által generált képkocka generálása közben annál sokkal gyorsabban legenerálni a 2.5-iket.Az egyetlen magyarázat, amire én gondolni tudok, hogy azért nő a frametime, azért kell visszatartani az utolsó CPU-GPU generált képkockát, mert ha az AI generált képkocka aközben készülne, miközben az utolsó CPU-GPU által generált képkocka már ki lett küldve a kijelzőre, akkor arra a user már reagálhat és nagyobb hibák keletkezhetnek a valóság és a AI generált képkocka között.

De ez meg azért nem áll össze, mert ugyanaez a CPU-GPU generált képkockával is megtörténne.Szóval valaki el tudja magyarázni nekem, hogy miért nő a frametime DLSS3 használata mellett?

Találgatunk, aztán majd úgyis kiderül..

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Asus Tuf 3080ti 12gb

- BESZÁMÍTÁS! Gigabyte RX 6800 XT Gaming OC 16GB videokártya garanciával hibátlan működéssel

- SAPPHIRE RX 7900 XTX 24GB GDDR6X NITRO+ GAMING OC VAPOR X - Új, tesztelt - Eladó! 360.000.-

- AKCIÓ! Sapphire NITRO+ RX 5700 XT 8GB videokártya garanciával hibátlan működéssel

- ASUS ROG STRIX Geforce RTX 3080 Ti OC 12GB GDDR6X 384bit

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest