-

IT café

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Jack@l

veterán

válasz

DudeHUN

#16658

üzenetére

DudeHUN

#16658

üzenetére

Két dolog: ez nem amd topic

a konzolokban kis szutyok proci és gpu van és ezután is az lesz(különben akkora méretben felső kategóriás cuccot fél millió alatt nem árulnának). Egy normálisabb gaming PC már sokszor gyorsabb mint a konzolok, az is marad amíg gyártják.[ Szerkesztve ]

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

válasz

DudeHUN

#16658

üzenetére

DudeHUN

#16658

üzenetére

Hát az a köze, hogy ugyan ezt hangoztatták a jaguár procikra. Dobhatjuk ki a 980 kártyákat mert felszántja az egészet. Aztán ment a küzdelem a FHD ért meg a 60 FPs ért és kijött már 3 új xbox verzió 2012 óta és 3 új Ps4 verzió.Zen megsokszorozza? ugyan mivel tenné ezt meg elárulnád?Azért mert zen?Itt a korlátot a beépítésre kerülő hardverek ára, fogyasztása és a játékok fejlesztésére rendelkezésre álló idő/ pénz szabja meg . Így is tele vagyunk félkész béta fázisú játékokkal. Koránt sem biztos, hogy AMD lesz továbbra is.Remélem nem, akkor talán előrelépünk, ha NV- IBM lesz újra a konzolokba.

Troll off.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#16663

üzenetére

DudeHUN

#16663

üzenetére

Egy alapvetően szoftveres korlátokkal küzdő hardverben. Mert bármilyen hihetetlen azért van hardveres korlát mert nem sikerült átlépni a szoftveres korlátokon.Értsd nincs low level API, olyan szinten mint kellene, és ehhez képest lett csak gyenge ez a hardver,nincsenek alapjaiból írt Dx 12 motorok, csak pár multimilliomos stúdiónak és nincs pénz fejleszteni mert csillagászati összegekre rúg egy A kategóriás játék előállítása.

Az hogy te azt gondolod, hogy pusztán a Zen mag miatt majd az Xbox One x többszörösét kapod és tele lesznek erőforrással szerintem tévedsz.

Minden szóban forgó gyártó tudna adni ( Intel , NV , AMD is)külön külön ennél gyorsabb hardver most ,de komplex és olcsó megoldást nem sok, ezért van ez .

Maga a Zen mag mint megváltóként emlegetést nem értem, mert egy Xboxba ha csak Zen alapú magot tennél ezekhez a grafikai képességekhez nem lenne megváltás senkinek. Az egész komplex rendszer maga majd képes lesz megtöbbszörözni a dolgokat, de az gondolom megint egy speciális fejlesztés lesz, még ha zen alapú is lesz egy Vega Navi párosítással.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#26259

üzenetére

DudeHUN

#26259

üzenetére

Hát, ha csak 20 dolcsiva számolunk az 470, majdnem 500 főleg ha jó szokás szerint az a 470 dollár az egy az egybe lesz átváltva Euróra... De 5 éve még az üzemanyag is és a szolgáltatások, raktározás, is olcsóbbak voltak. Meglátjuk.. De 470 dollár is nálunk kb 170-190 K...Mint most egy 2070 super ,remélhetőleg a köv genben ez az összeg pedig egy minimum 2080 Ti sebességű kártyát eredményez...

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Dyingsoul

veterán

válasz

DudeHUN

#27001

üzenetére

DudeHUN

#27001

üzenetére

Ja van PC-re is... csak erre a sz@rra 2 évente 4-500 ezret elköltök... És még csak nem is cserélek mindent és nem is a legjobbakra...

(#27002) Segal: Lehet, hogy kapja be a bokám.

(#27003) b.: Nem az új nextgen címeket kell nézni hanem azt, hogy mi lesz 3 év múlva... PC: Veheted a következő VGA-t meg a játékokat.

[ Szerkesztve ]

- Szakmai kérdésekre privátban nem válaszolok, mivel másoknak is hasznos lehet. Erre való a szakmai fórum! -- YT: youtube.com/dyingsoulgaming -- FB: facebook.com/DyingsoulGaming/ Stream: http://twitch.tv/dyingsoul

-

KillerKollar

senior tag

válasz

DudeHUN

#28578

üzenetére

DudeHUN

#28578

üzenetére

Támogatni fogják az új kártyák a 4.0-át ez egyértelmű és ezzel nincs is semmi baj. Azzal lenne baj, ha komoly teljesítményveszteséget jelentene ha 3.0 x16 slotban használod a kártyát 4.0 helyett. Ha tesztekben kimutatható egy mérhető különbség ami 1-2% na bumm.

Ha viszont 5-10%-ot elbuknál emiatt az már probléma, mert azt a plusz teljesítményt is kifizeted amikor megvetted a kártyát, de nem tudod kihasználni, ezért lehet, hogy az egyel olcsóbb/gyengébb kártyát veszed amit már nem limitál a 3.0.

Ennek viszont nem igazán örül az NV, mert azon a kártyán jóval kevesebb a haszon. Vagy egyáltalán nem veszel semmit, mert a kártya árát még szívesen kifizetted volna, de amellé még egy új alaplap + proci már sok lenne, ezért tele lesz a tököd az egésszel és veszel 500$-ért egy konzolt.

-

Hellwhatever

aktív tag

válasz

DudeHUN

#38668

üzenetére

DudeHUN

#38668

üzenetére

Attól tartok hogy ez egy gyanúsan egyoldalúan előadott sztori az EVGA részéről, furcsán mindenre van válasz, igaz néhol kicsit sántít az összkép.

Én arra gondolok hogy feltettek mindent a crypto piac kiszolgálására (érdekes módon amíg ment a szekér nem volt gond a marzzsal), túlrendelték magukat (ahogy az RTX 20-as szériánál is anno) aztán szépen rájuk omlott az egész most pedig magyarázni kell a bizonyítványt.

Nyilván az nVidia-t se kell félteni, amit elmondtak róluk mint partnerekről azok valószínűleg mind igazak.

-

válasz

DudeHUN

#38700

üzenetére

DudeHUN

#38700

üzenetére

Abból a szempontból ez irreleváns, hogy hatalmas bevételhez jutottak a VGA eladásból.

Amúgy ezt honnan tudod biztosan mekkora árréssel dolgoztak az AIB partnerek a nagykerek felé vagy mekkora volument adtak el?[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#38706

üzenetére

DudeHUN

#38706

üzenetére

Értem amit írsz az EVGA szempontjából,

de nézd meg amiket linkeltem bevételi grafikonok. Asus 2021 ben 500 milliárd Taiwani dollárt ért el és ebből 33 % volt a gaming szegmens ( 50% növekedés 2019 hez képest) MSI 239 % növekedést produkált. Az egész piacot a Krypto felrántotta és ezért bekészleteztek.

2 év alatt 3 évi árbevételt produkáltak . kidurrant a kripto és zuhannak vissza Mindegyik partner. MSI 89 % Asus 75 % 2022 ben eddig. VGA eladásból.

tehát most az kellene hogy Nvidia mindenkinek fizessen pénzt mert bekészleteztek és legyárottak maguknak hatalmas mennyiséget mikor tavaly novemberben már meg volt jósolva hogy tavasszal vége lesz a dolognak?Nvidia zuhant a legnagyobbat amúgy ebben a negyedévben az AMD nagyobb árbevételt produkált mint ők 8 év után előszőr.

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#39394

üzenetére

DudeHUN

#39394

üzenetére

Pontosan.Plusz az extra hosszú, 3 ventis kártyáknál hátsó ventilátor gyakran rezonálhat, mint az Én kártyámnál is érezhető, és ez mozgatja az egész hátsó burkolatot. nem jelentős, de jelen van.

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#39447

üzenetére

DudeHUN

#39447

üzenetére

Intel szerintem jó lesz, nem véletlenül akar Nvidia hozzájuk menni. Nekik a saját termékeik miatt eleve megtérülős a fejlesztés, a bérgyártás ráadás. Szerintem ők lesznek ebből a kút.

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Abu85

HÁZIGAZDA

válasz

DudeHUN

#39447

üzenetére

DudeHUN

#39447

üzenetére

Semmit sem érne. A Samsung van a legközelebb hozzájuk, sőt, a GAAFET-tel meg is előzték őket, de az nem elég, hogy van egy jó node-od. Gyár is kell hozzá. Invesztálni meg nem akar senki 400 milliárd dollárt arra, hogy itt is felnőjenek a TSMC-hez.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

evitiguF

senior tag

válasz

DudeHUN

#39810

üzenetére

DudeHUN

#39810

üzenetére

Az a baj, hogy a tömeg nem így gondolkodik, és venni fogják így is…

tpu és cb komment szekcióban is megy a háborgás, meg itt néhányunktól, de ismerősöket körbekérdezve addig látnak, hogy: most ilyen a piac, most minden drága, ha 400k körül lesz a kártya, abba már beletörődik, és veszi…

és van itt fórumtag, akinek szintén ennyi az ingerküszöbe. -

fLeSs

nagyúr

válasz

DudeHUN

#39810

üzenetére

DudeHUN

#39810

üzenetére

Elolvasol egy-két review-t a neten, azok is kimondják az "igazat", de nem ilyen stílusban, nem ilyen színvonalon és un-professzionális trollkodó módon.

Ez a "teszt" egy sz@r volt már bocs.

Egyébként meg miközben Steve beszél nekem mindig olyan benyomásom van mintha erőlködne (pl. sz@rás közben ), emiatt nehéz végignéznem de ez csak én vagyok.

), emiatt nehéz végignéznem de ez csak én vagyok."I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

fLeSs

nagyúr

válasz

DudeHUN

#39837

üzenetére

DudeHUN

#39837

üzenetére

Jó hát eltér a véleményünk.

Sztem bohócot csinál magából ebben a videóban miközben a fanoknak akar tetszelegni, megismételve újra és újra és újra és újra hogy ez a kártya drága és az NV marketingje át akar verni a 3x-es slide-dal.

Ne felejtsük el, hogy ezeknek a yt tesztelőknek a klikkek hozzák a pénzt, több dráma = több klikk."I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

PuMbA

titán

válasz

DudeHUN

#40095

üzenetére

DudeHUN

#40095

üzenetére

"Az assetek elkészítése és a világok benépesítése ezekkel elképesztően sok meló."

A grafika nagy részt attól függ, hogy mennyi munkát tettek bele a fejlesztők. Amit írtál, God of War: Ragnarok, ami majd ha PC-re megjelenik jól fog futni és kiválóan fog kinézni, mint ahogy a Red Dead Redemption 2 is kiválóan néz ki a mai napig, pedig 5 éves és semmiféle csúcs hardver nem kell hozzá. Az, hogy PCI-E 5.0 SSD jelenik meg vagy RTX5090, attól nem lesz jobb a grafika, vagyis nagyobb részben nem ettől lesz jobb a grafika. Legnagyobb részt a bele rakott munka miatt lesz jó a grafika.

A grafika nagy részt attól függ, hogy mennyi munkát tettek bele a fejlesztők. Amit írtál, God of War: Ragnarok, ami majd ha PC-re megjelenik jól fog futni és kiválóan fog kinézni, mint ahogy a Red Dead Redemption 2 is kiválóan néz ki a mai napig, pedig 5 éves és semmiféle csúcs hardver nem kell hozzá. Az, hogy PCI-E 5.0 SSD jelenik meg vagy RTX5090, attól nem lesz jobb a grafika, vagyis nagyobb részben nem ettől lesz jobb a grafika. Legnagyobb részt a bele rakott munka miatt lesz jó a grafika." Plusz ára is van ennek a nagy teljesítménynek. Egyikünk sem tapsikol a 400-500+ wattos kártyáknak szerintem."

Ez a gyártók sara. A kártyákat kiválóan lehet undervoltolni és underclockolni és máris 150W-ot faragtál, minimális teljesítmény eséssel.

[ Szerkesztve ]

-

GEIL

addikt

válasz

DudeHUN

#40844

üzenetére

DudeHUN

#40844

üzenetére

Sokra nem megyek vele....mert 1080p-s kártya és még Raytracinggel és csutka grafikán se tudok beletolni 7,5-8 Gb Vram igénynél többet....Fortnite-ban pl.

De szétmoddolt, texturapackolt GTA5 se teszi tele...az is 8 Gb körül megáll nálam.....

DLSS is módosit a Vram telítettségen,...

1440p-ben már tuti más volna...de oda más kártya kell...[ Szerkesztve ]

i7 13700k - 32Gb DDR5 - RTX4070 /// i5 9600k - 16Gb DDR4 - RTX3060 /// i5 4570s - 16Gb DDR3 - GTX1650 -------------------------------------------- PS5 /// Samsung S23 Ultra 5G /// Xbox Series X --------------------------------------------

-

válasz

DudeHUN

#41274

üzenetére

DudeHUN

#41274

üzenetére

A lényege az volt a hozzászólásomnak hogy a PC játékok skálázhatóak- jelenleg egyetlen játékban sem látok oltári nagy különbséget egy Ultra és egy high beállítás között, még AMD szponzorált címekben sem ahol erre kifejezetten ráhajtanak hogy 10 + Giga legyen a Vram igény.

Annyira nyúlnak bele ameddig a felhasználó fog belenyúlni, ez a z options fülecske lényege.

Egyetlen játékot sem tudok most aminél az Ultra textúra beállítás lenne az egyetlen járható út .

AMd-t könnyen mentesíti a magas árazás alól az Nvidiara való felelősség áthárítás. Erre leírtam a véleményemet feljebb, AMD lenne a legnagyobb szarban ha 4080- 799 dollár lenne a 4070 Ti meg 500$.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#41277

üzenetére

DudeHUN

#41277

üzenetére

egyáltalán nem normális csak nem tudom minek keverd ide a cégeket.

Én a felhasználók szemszögéből beszélek. Úgy van tálalva ez a Vram dolg hogy ez minden alól mentesíti az AMD-t a fos raytracing teljesítmény a szarabb FSR2 minőség miatt és még sorolhatnám miben marad el az Nvidia kártyaitól az előző genben. Pont ez volt lényege a hozzászólásomnak hogy az egyik oldalon a Vrammal és a textúrák minőségében kötsz kompromisszumot a másik oldalon mega DLSS, FSR, RT teljesítmény kuka, mikor a 6800 több RT játékban nem éri el a 3060 ti szintjét. Kinek mi számít de szerintem ezt világosan leírtam hogy attól hogy a 6700XT 12 GB Vrammal megy nem lesz jobb RT ben és DLSS ben mint egy 3060 Ti sajnos.és egy 3060 TI nem fog valószínűleg a jövőben ultra textúra beállításokat használni még FHD-n sem. Mindenki a saját igényeihez mérlegeljen, akinek 140 K van a zsebében.

Én személy szerint használt 3080 10 GB ha RT/ DLSS kell vagy 6700XT, ha ezek nem számítanak.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#41280

üzenetére

DudeHUN

#41280

üzenetére

Egyáltalán nem mosdattam Nvidiát. csak az a gond hogy minden hozzászólásomat erre fordítjátok le.

Szerintem egyszerűen leírtam hogy mi a véleményem erről, nem értem mit nem lehet ezen elfogadni. nem azt mondtam hogy a 6700 XT szar vagy a 3060 Ti jó.Nem érzelmi alapon kommunikálok illetve nem azon az alapon amire te gondolsz hogy Nvidia hívő lennek. Kizárólag azt írom hogy ez a Vram mizéria túl van tolva és állandósult joker kártya lett.

A 6700XT-t a legjobb vételnek nyilvánítottam a saját árkategóriájában már többször több topikban.Példa : [link]

kizárólag azt írtam itt , hogy ez nem ennyire egyszerű azért, nem egyértelműen jobb majd ez meg az a jövőre nézve.. [link]EZ felhasználás függő, ki miben fog kompromisszumot kötni. Van aki leveszi a majd médiumra a textúrát aztán boldogan játszik más meg nem kapcsolja be az RT-t aztán boldogan játszik.

AKi 3080 kártyát vesz az nagyjából elérte a maximális RT teljesítményt előző genben ( 6950XT ) AMD szintjén és kap mellé DLSS-t is.

AKI meg 6950XT-t vesz az meg kap tuti Ultra textúrákat cserébe, az RTX 3080 nál ez esetleges lesz .

Nem tudsz ezzel mit kezdeni amit adnak a Gyártók csak a nem vásárlással. Az a mese már elment hogy azért kell AMD-t venni mert akkor megváltozik minden is. Nem fog ez tisztán látszik. Mindenkinek a saját igényeit kell mérlegelni, mire van szüksége és ahhoz venni kártyát. Aki hősködni akar annak sok pénze van vagy elvakult.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#41282

üzenetére

DudeHUN

#41282

üzenetére

Lehet én fogalmaztam félre valamit hogy ez jött le vagy nem voltam egyértelmű. Mindegy is.

Nem védem őket a vram miatt egyáltalán, sőt.

Twiteren kaptam ez miatt eltiltást is, mert kemény kritikát fogalmaztam mega 4060 Ti- és 4070 Ti vel és az SKU-k elcsalásáról. ahogy itt is ebben a topikban is többször ugyan azt leírtam amit te feljebb : [link]

[link]

Ott nem jött elő az hogy AMD Defense Force

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

hahakocka

senior tag

válasz

DudeHUN

#41280

üzenetére

DudeHUN

#41280

üzenetére

Ez hívják marketing beszívásnak, emellett a márkahűség hosszú távon manapság sokszor nem mindig jó. Én nekem is volt már Intelem is AMD-m is NV m is AMD karim is mindenféle. Lehet még Intel kari is lesz majd ha fel fejlődnek. Ami éppen megéri nem átcsapás marketing és jó ár értéke van.

Joysefke jól leírtad az RT összefoglalód, meg hogy mivel versenyzik az FSR s a DLSS a natív ellenében

[ Szerkesztve ]

-

válasz

DudeHUN

#41721

üzenetére

DudeHUN

#41721

üzenetére

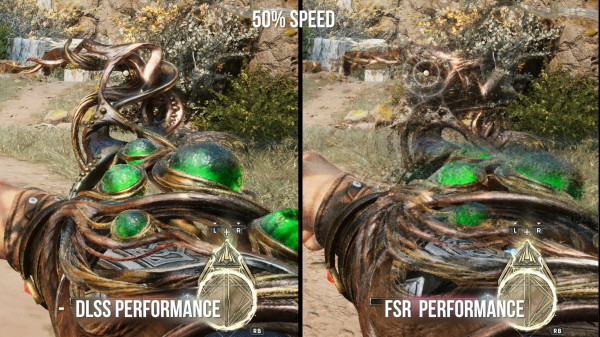

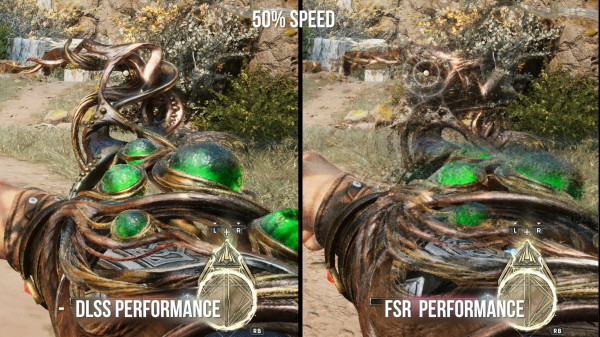

Őőőő... Ezek olyan apró artifactok, hibák, amelyek ott vannak, és rontják a képi élményt. Az, hogy fegyver váltáskor "ott marad" a fegyver szellemképe észre vehető, de az emberek nagy része legyint rá. Pedig ez is képminőség dolog. Ahogy az FSR felskálázáskor a gyengébb textúra minőség, modell minőség is ilyen (ezeket rakta be gV).

Hogy "nem lehet észrevenni" így finoman szólva is fals. Ha össze veted a DLSS-el, akkor látható, szemmel is befogadható. Egyszerűen jobb a kép minősége. Ha játszottál DLSS-el, és utána bekapcsolod az FSR-t, akkor Neked is feltűnne, hidd el...

Légvédelmisek mottója: Lődd le mind! Majd a földön szétválogatjuk.

-

válasz

DudeHUN

#41728

üzenetére

DudeHUN

#41728

üzenetére

Mondjuk azt hozzá kell tennem hogy részben egyetértek veled, az eddigi legjobb minőségű FSR beépítés,de látszik az hogy a DLSS-től elmarad. Aki kipróbálja ebben a játékban is a DLSS-t annak utána már zavaró tud lenni a szellemképesedés és a recés élek minősége.

Szerintem te nem vagy annyira érzékeny rá vagy nem tudom, mert az AMD-t topikban is erre:

azt írtad, hogy még így is jobban tetszik neked az FSR mint a DLSS, attól kicsit hanyattestem, mert kifejezetten gusztustalan ahogy kinéz abban a játékban az FSR a mozgó tárgyaknál.

Olyan szellemképet húz sokszor hogy szédülök tőle és ez most nem túlzás, mert miután beszéltünk, kipróbáltam hogy én nézek e be valamit a videós teszt [link] alapján, de nem.

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#41730

üzenetére

DudeHUN

#41730

üzenetére

"Aveumban szvsz az összkép az FSR felé billen mozgásban."

Továbbra is érthetetlen hogy írhatod ezt le, az ellenkezőjét, amit látok ,hisz Itt van a gépemen saját szemmel látom,.

A tesztelt DF videó is ezt mutatja és ezt emelik ki, hogy Pont mozgás közben szar , olyan szellemképes aurát hoz létra amit eddig még nem tapasztaltam másban.

Még esetleg arra tudok gondolni, hogy máshogy működik Nvidia kártyán, más ésszerű magyarázatot nem látok erre.

más ésszerű magyarázatot nem látok erre.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#41728

üzenetére

DudeHUN

#41728

üzenetére

Kipróbáltam, de az FSR-t csak megnéztem, aztán váltottam modded DLSS-re.

Az FSR féle háttérben mozgó dolgok vibrálása már a CP2077-ben is szörnyű zavaró volt számomra, ezért nem is szándékozom AMD-re váltani jelenleg, miközben viszont az nVidia féle VRAM hiány és árazás miatt az RTX 40x0-re váltás sem vonzó számomra.Szóval bőven kipróbáltam az FSR féle opció, Téged nem zavar, szuper, de engem sajnos nagyon.

Hozzá teszem, hogy a DLSS is hosszú idő alatt ért el ide, pl. anno a CP2077-ben is anno olyan ghosting volt járművek esetén, hogy csak na, aztán a DLSS 2.5-el ezt is javították gyönyörűen.

Légvédelmisek mottója: Lődd le mind! Majd a földön szétválogatjuk.

-

gejala

őstag

válasz

DudeHUN

#42129

üzenetére

DudeHUN

#42129

üzenetére

AMD-nél mindig nagy a hév, aztán semmi nem lesz belőle. RDNA2-nél is úgy volt, hogy most már évente jön új arch, reszkessen az NV.

![;]](//cdn.rios.hu/dl/s/v1.gif)

A valóság meg az, hogy quiet quittinget nyomtak a GPU piacon. A minimumot kiizzadják, hogy ringben maradjanak, de semmivel nem veszélyeztetik az NV 80-85% részesedését.[ Szerkesztve ]

-

válasz

DudeHUN

#42129

üzenetére

DudeHUN

#42129

üzenetére

A kövi gen az RDNA4.

Az RDNA5 meg a következő utáni.

Az nVidia meg 2024-ben feltehetően végig húzza a Super családot a teljes szérián (a 4070 és 4080 Super a közép- és középfelső ház, de eddig a kisebbekből is hozott Super-t, csak később), ami elég lehet az RDNA4 ellen.

2025 elején meg jöhet az RTX50 széria, pont azért nem kell sietniük, mert a Super-rekkel is kordában tudják tartani az AMD-t és az Intelt (a Battlemage a hírek szerint szintén 2024 H1, és a csúcs verziótól RTX 4070Ti szintet várnak játékokban).A probléma továbbra is az, hogy az nVidia és az AMD hozzávetőleg azonos bevételt generál (mindkettő kb. 6-6.5 milliárd US$-t a 2023Q4-re), csak éppen az nVidia bevételeinek oroszlánrésze az AI gyorsítókból és a GPU-kból származik, az AMD-nek viszont a procikból.

Egyszerűen az nV többet áldozhat K+F-re a GPU-k terén, mint az AMD, és ennek az a vége, hogy egyszerűen jobban is állnak technológiai szinten.

A fekete ló az Intel lett volna nálam, de a jelek szerint továbbra is az AMD-vel versenyeznek először, hogy a második helyet megkaparintsák...[ Szerkesztve ]

Légvédelmisek mottója: Lődd le mind! Majd a földön szétválogatjuk.

-

válasz

DudeHUN

#42129

üzenetére

DudeHUN

#42129

üzenetére

RDNA4 és az Nvidia következő generáció az egy én úgy tudom, ahogy írja Cifu.

Most az RDNA3 = Rx7000 a jelenlegi generáció vagy lehet félreértettem valamit abból amit írtál.

Én úgy látom, hogy előfordulhat az ami az RDNA elött volt ,hogy ilyen Nvidia után félidőben száll be az AMD, pár hónap eltolással.Arra meg lehet reagálni,ahogy már megszoktuk az 1070Ti kiadása óta.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

válasz

DudeHUN

#42656

üzenetére

DudeHUN

#42656

üzenetére

Mondjuk nekem nem annyiar gond, mert általában Asus lapokat használok ,de lehetne amúgy, egyetértek. Dizájnban is minden eddigit ver a kábel nélkülisége, rohadt jól néz ki, hogy nincs.

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Abu85

HÁZIGAZDA

válasz

DudeHUN

#42656

üzenetére

DudeHUN

#42656

üzenetére

Ez a kábeltől nem szabadít meg, mert annyi történik, hogy átkerül a csatlakozó az alaplapra. Ugyanúgy be kell majd dugni, csak nem a VGA-n.

#42662 hokuszpk : Ott lesz az alaplapon ugyanaz a csatlakozó, ami a VGA-kon van. Ha esetleg véletlenül leégne, akkor az alaplapot kell kidobni és nem a VGA-t.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

válasz

DudeHUN

#42667

üzenetére

DudeHUN

#42667

üzenetére

Én úgy látom az Asus oldalán [link] hogy hátul sima tápcsatik vannak,a kisebb 760 nál is. [link]

DE lehet benézek valamit vagy csak a kisebbeknél valóban.[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Azonnali processzoros kérdések órája

- Poco X6 Pro - ötös alá

- TCL LCD és LED TV-k

- Milyen cserélhető objektíves gépet?

- NVIDIA GeForce RTX 4080 /4080S / 4090 (AD103 / 102)

- Senua's Saga: Hellblade II - Íme a végleges gépigény

- Modern monitorokra köthető 3dfx Voodoo kártya a fészerből

- Vezeték nélküli fejhallgatók

- Samsung Galaxy Watch4 és Watch4 Classic - próbawearzió

- Okosóra és okoskiegészítő topik

- További aktív témák...

- Újszerű - POWERCOLOR Radeon RX 5500 XT 8GB GDDR6 VGA videókártya

- Hibátlan - GIGABYTE GTX 1660Ti Windforce OC 6G 6GB GDDR6 VGA videókártya dobozos

- BESZÁMÍTÁS! GIGABYTE WindForce 2X GTX 960 4GB GDDR5 videokártya garanciával hibátlan működéssel

- ASUS ProArt GeForce RTX 4080 SUPER 16GB GDDR6X OC (ASUS-VC-PRO-RT4080S-O16G) Bontatlan új 3 év gar!

- ELADÓ 32 DB Nvidia RTX 3060 Ti és 8 DB Zotac Gaming Geforce RTX 3080 Trinity / KOMPLETT BÁNYAGÉP

Állásajánlatok

Cég: Ozeki Kft.

Város: Debrecen

Cég: Promenade Publishing House Kft.

Város: Budapest

), emiatt nehéz végignéznem de ez csak én vagyok.

), emiatt nehéz végignéznem de ez csak én vagyok.

más ésszerű magyarázatot nem látok erre.

más ésszerű magyarázatot nem látok erre.

![;]](http://cdn.rios.hu/dl/s/v1.gif)