- Starlink

- Nemzetbiztonsági aggályok merültek fel a TP-Link kapcsán

- One otthoni szolgáltatások (TV, internet, telefon)

- Ezentúl Indiában készülnek majd az USA-ban árusított Apple iPhone-ok

- Mikrotik routerek

- VPN topic

- Trump vámjai miatt hiány lehet az elektronikai termékekből az USA-ban

- Sweet.tv - internetes TV

- Milyen routert?

- Windows 11

Új hozzászólás Aktív témák

-

5leteseN

senior tag

válasz

freeapro

#1899

üzenetére

freeapro

#1899

üzenetére

Az jó!

Most nemtom' megnézni, mert a a második nV-s VGA-m nem fér be tőle 2 slotra lévő VGA aljzatba a felette lévő 2,5-slot-os 2080Ti túlméretes hűtése miatt.

Körbenézek valami gyorsabb és sok-VRAM-os de csak egy-slot-os nV ügyében. Kicsi az esély, ezek Quadro-k szoktak lenni, civilek ilyet ritkán vesznek a 3-4-szeres áruk miatt.

-

d.janos

csendes tag

Van olyan ai ami úgy működik, mint pl. A chatgpt hangrögzítő/diktáló módja, de figyelmbe veszi a a beszéd szüneteket és úgy fordítja le. Érthetőbben: vissza olvasásnál ugyanolyan szünetekkel teszi meg. Asszem érthető.

-

DarkByte

addikt

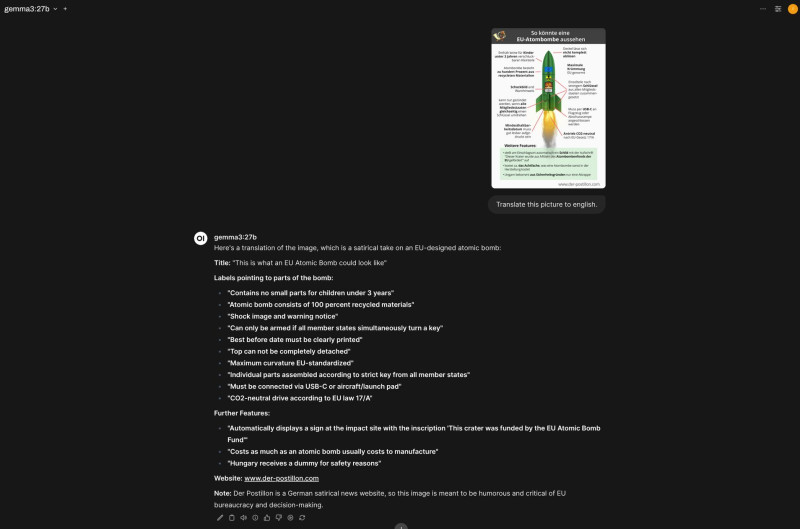

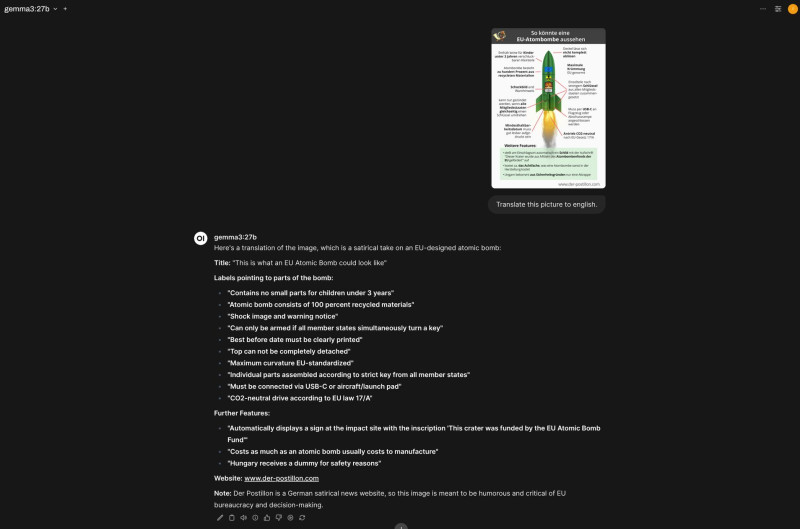

A multimodális képessége amúgy eléggé jó a Gemma3-nak.

-

DarkByte

addikt

válasz

consono

#1894

üzenetére

consono

#1894

üzenetére

Az OpenWebUI-on most már van "Code Interpreter" gomb a prompt boxnál, ennél kíváncsiságból be is kapcsoltam, de szerintem semmi hatása se volt jelen esetben.

Itt a normál LLM válasz végén az "which is 1" az sejtésem szerint ugyanúgy hallucináció gyanús, mivel hamarabb ott volt mint megnyomtam a "Run" gombot a script box szélén.

ChatGPT-n ha kérsz tool use-t, látod egyből hogy lefutatta és belefűzte a válaszába és úgy folytatja a prompt maradék részének kiírását. Szerintem itt is így kellene működnie, csak még nem jöttem rá milyen modell és beállítás kell ehhez. A Gemma3 nem tud tool use-t, legalább is az Ollama definíciója szerint biztosan nem.

Mindenesetre a kód amit írt helyes, és ezt akartam demonstrálni.

-

5leteseN

senior tag

válasz

5leteseN

#1891

üzenetére

5leteseN

#1891

üzenetére

Most vettem észre, hogy a csatolt képen csak egy 3090 van, tehát annál a konfignál nincs mit összeadni.

Mintha írtad is volna, hogy egy korábbi állapot volt a két VGA-s összeállítás.Most már nem tudod ezt a két-VGA-s esetet megnézni az LLM betöltődéssel(hogy az összevont méretű VRAM műxik-e)?

-

5leteseN

senior tag

válasz

freeapro

#1889

üzenetére

freeapro

#1889

üzenetére

1,

2, Azt esetleg meg tudnád nézni, hogy az összegzett VRAM mérethez illeszkedő méretű LLM-et csak a VRAM-okba tölti, vagy használja a rendszer RAM-ot is(kár lenne).

Ez utóbbinál ugyanis "bekapcsol" a rendszer RAM sebességéhez tartozó "csiga-biga üzemmód", amit a visszaeső token/mp számból lehet észrevenni(+a hosszabb "kávé-szünetből"). -

moseras

tag

-

S_x96x_S

addikt

válasz

S_x96x_S

#1882

üzenetére

S_x96x_S

#1882

üzenetére

(több gép összekapcsolás - TB5 + 2db M3 Ultra 512GB

Terv: 11 tok/sec jelenleg --->> 20 tok/sec --->> 40 tok/sec"Thunderbolt 5 interconnect (80Gbps) to run the full (671B, 8-bit) DeepSeek R1 distributed across 2 M3 Ultra 512GB Mac Studios (1TB total Unified Memory). Runs at 11 tok/sec. Theoretical max is ~20 tok/sec."

https://x.com/alexocheema/status/1899735281781411907"We’ll keep improving it in @exolabs. Once we approach the “theoretical maximum”, there’s a bunch of other stuff we can do to surpass it for sparse MoE, e.g. expert parallelism. I think we can get to 40 tok/sec."

https://x.com/alexocheema/status/1899737017866719506 -

5leteseN

senior tag

válasz

freeapro

#1884

üzenetére

freeapro

#1884

üzenetére

freeapro : "LM Studio egy gépben több VGA-t is tud kezelni észrevehető sebességcsökkenés nélkül. (3070+1080ti -t teszteltem)"Ez sem rossz! Ez igazán akkor lenne főnyeremény, ha összeadja a VRAM-okat!

Összeadta?

Az sem lenne rossz, ha a két LLM-es üzemmód(Spekulatív dekódolás, EBBEN a videóban ) esetén az egyik VGA-n (a kissebben) futna kis LLM, a másikon a nagy.

...vagy csak álmodozom? -

DarkByte

addikt

válasz

S_x96x_S

#1885

üzenetére

S_x96x_S

#1885

üzenetére

Gbps vs GB/s.

Az az összehasonlítás értelmetlen, a 70B Q4-nek kell közel 40GB VRAM.

Mivel a 24GB-ba nem fér be, beindul a RAM spillover, és onnantól kezdve a rendszer memória sebességét méred egy totál lefolytott 4090-el párosítva.Tipikus idióta marketing. Olyan mint hogy az 5070 hozza a 4090 sebességét játékokban. Persze, csak azt elfelejtették írni hogy DLSS4 és framegen mellett. Natív teljesítményben a 4090 lenyomja mint Süsü a cölöpöt.

-

S_x96x_S

addikt

válasz

DarkByte

#1883

üzenetére

DarkByte

#1883

üzenetére

> oké, de ez még mindig alig 1GB/s-es tempó,

nem 1 --> 11 !

A 11Gbps full-mesh hálózat ~= Minden eszköz közvetlenül 10Gbps kapcsolatokkal csatlakozik minden más eszközhöz.

és az USB4 biztosítja az operációs rendszer támogatást is.> összehasonlítva mondjuk

> egy 4090 1008GB/s VRAM sávszélességével, megmosolyogtaAttól függ

... kis modell vagy nagy modellmert önmagában a sávszélesség nem sokat ér - ha nincs mellette elég VRAM.

A LLama 3.1 70B-Q4 -esetén

egy StrixHalo 2.2x gyorsabb ( tokens/sec ) mint egy RTX 4090 (24GB) !!!

Ráadásul kevesebbet is fogyaszt!

-

DarkByte

addikt

válasz

S_x96x_S

#1881

üzenetére

S_x96x_S

#1881

üzenetére

Tisztában vagyok a destillation fogalmával (egy kisebb másik modellt tanítottak be, a nagyobbik modellt tanító modellként használva).

Nyilván ez sosem lesz ekvivalens a naggyal, de a nagyot meg esélyünk sincs lokálban futtatni, csak ezeken a böhöm dögökön amiket linkeltünk.

A Qwen-2.5 alapú DeepSeek 32B szerintem meglepően ügyes.

Mindegyiket a képességeinek megfelelően kell kezelni. Épp a napokban láttam egy ilyen videót hogy melyiknek milyen komplexitású feladatokat érdemes adni. [link]--

#1882: oké, de ez még mindig alig 1GB/s-es tempó, összehasonlítva mondjuk egy 4090 1008GB/s VRAM sávszélességével, megmosolyogtató.

De még akár a PCIe 4.0 8x/16x 16/32GB/s-es tempójával összehasonlítva is jelentős a különbség, és már az is eléggé megcsapja a sebességet ha két kártyának a PCIe buszon keresztül kell kommunikálnia. (konzumer NVLInk pedig ugye nincs) -

S_x96x_S

addikt

válasz

DarkByte

#1880

üzenetére

DarkByte

#1880

üzenetére

> A legfrissebb Framework Desktop videóban is

> valahogy kihagyták a több gép összekötésével elérhető

> sebesség bemutatását. Valószínűleg nem valami acélos.USB4 -összeköttetéssel - a 11Gbps mesh hálózat simán megvan.

Az újabb Mac-ek pedig már a TB5 -öt is ismerik. -

S_x96x_S

addikt

válasz

DarkByte

#1875

üzenetére

DarkByte

#1875

üzenetére

> pl. Deepseek R1-nél azt mondják a 14B a legkisebb amivel érdemes foglalkozni.

A "deepseek-r1:14b" valójában a

"DeepSeek-R1-Distill-Qwen-14B",

ami azt jelenti, hogy a Qwen-14B modellt finomhangolták (finetuned)

a nagy DeepSeek-R1 modell által kiválogatott

és generált 800 ezer érvelési mintán és adaton.Nekem a portói bor analógia jut eszembe - ami egy "fortified wine",

vagyis alkohollal dúsított(erősített) bor ;

és Qwen-14B - is fel van erősítve az R1 -el ; de nem egyezik meg az R1 -el.--------

És mivel a 7b és a 8b alapja más - érdemes mindkettőt tesztelni:A

deepseek-r1:8bpedigDeepSeek-R1-Distill-Llama-8B( Llama:8b alapú )

Adeepseek-r1:7bpedigDeepSeek-R1-Distill-Qwen-7B( Qwen:7b alapú )

..."""

The Qwen distilled models are derived from Qwen-2.5 series, which are originally licensed under Apache 2.0 License, and now finetuned with 800k samples curated with DeepSeek-R1.The Llama 8B distilled model is derived from Llama3.1-8B-Base and is originally licensed under llama3.1 license.

The Llama 70B distilled model is derived from Llama3.3-70B-Instruct and is originally licensed under llama3.3 license.

"""

https://ollama.com/library/deepseek-r1 -

DarkByte

addikt

válasz

Mp3Pintyo

#1878

üzenetére

Mp3Pintyo

#1878

üzenetére

Meg, de sajnos nem sok plusz teljesítményt lehet így kisajtolni, mert a hálózat/USB/Thunderbolt eléggé szűk keresztmetszet lesz ebben az esetben. [link]

A legfrissebb Framework Desktop videóban is valahogy kihagyták a több gép összekötésével elérhető sebesség bemutatását. Valószínűleg nem valami acélos.

-

5leteseN

senior tag

válasz

Mp3Pintyo

#1878

üzenetére

Mp3Pintyo

#1878

üzenetére

Tehát ha van két(akár nem azonos típusú)2080Ti 22GB-osom, akkor 44GB méretnek látja a program?

"Annyi" a gond csak(ha jól értem), hogy ebben az esetben a két 2080ti közötti sebesség lesz a szűk keresztmetszet(igen, tudom: botlenek

![;]](//cdn.rios.hu/dl/s/v1.gif) ), de kétszeres méretű LLM-ekkel tudok dolgozni, az egy 2080Ti-nél valamivel( még nem tudni mennyivel

), de kétszeres méretű LLM-ekkel tudok dolgozni, az egy 2080Ti-nél valamivel( még nem tudni mennyivel  ) lassabban?

) lassabban?Ha ezt kb jól láttam, akkor már csak az lenne a hab a tortán (de dúsan

), ha a Windows-os Linux-on(WSL 1-2 ?) is futna ez az exo...! LM Studio-t is kérek...

), ha a Windows-os Linux-on(WSL 1-2 ?) is futna ez az exo...! LM Studio-t is kérek...

PLs-pls.. -

Mp3Pintyo

aktív tag

válasz

DarkByte

#1875

üzenetére

DarkByte

#1875

üzenetére

Azt is megteheted, hogy összekötöd őket ezzel:

https://github.com/exo-explore/exo -

Mp3Pintyo

aktív tag

válasz

DarkByte

#1875

üzenetére

DarkByte

#1875

üzenetére

Vicces de amikor teszteltem az R1 apróbb verzióit akkor a 7B adta a legjobb eredményt.

DeepSeek-R1 7B, 14B, 32B teszt: Mire képes az eddigi legjobb ingyenes modell ha a saját gépen fut? -

DarkByte

addikt

M3 Ultra Mac Studio 512GB RAM, DeepSeek R1 671B Q4, 18 token/s, mindezt 200W fogyasztás alatt. [link]

Csak ülj le mielőtt megnézed mennyibe kerül.

Viszont ez még így is olcsónak számít ha azt nézed egy darab 80GB-s A100-at mennyiért lehet beszerezni itthon (és még egy elég se belőle, ha jól számolom kellene belőle legalább 6db ugyanerre a célra).

Viszont ez még így is olcsónak számít ha azt nézed egy darab 80GB-s A100-at mennyiért lehet beszerezni itthon (és még egy elég se belőle, ha jól számolom kellene belőle legalább 6db ugyanerre a célra). -

DarkByte

addikt

válasz

S_x96x_S

#1872

üzenetére

S_x96x_S

#1872

üzenetére

Mondjuk ezek a 3B és 8B modellek elég limitáltak sajnos.

Gondolkodós modelleknél még kevésbé elég ez a méret, pl. Deepseek R1-nél azt mondják a 14B a legkisebb amivel érdemes foglalkozni.Egyébként side projektnek nekem is listán van megnézzem mire lehet menni egy kis modellel. Van pár kihasználatlan Raspberry Pi 4 4GB-om, és nem real time LLM használatra éppenséggel befoghatóak lennének, egy gemma2:2b-instruct-q4_K_M elmegy rajtuk ahogy olvastam. Olyesmikre akartam megnézni mennyire bevethetőek, mint pl. időzített taszkban egy oldal szövegéből tartalom kinyerése és mondjuk egy Discord bot-on át továbbítás. Esetleg RSS feed-ek szűrése tag-ek szerint.

Ilyesmikre szerintem még képes lehet. -

S_x96x_S

addikt

Ha valakit CPU inference érdekel ...

9950X3D - AI Benchmark-ban ( Whisper.cpp ; Llama.cpp , ONNX - ResNet101 )

az élre tört - mégha nem is olyan hatalmas előnnyel

https://www.phoronix.com/review/amd-ryzen-9-9950x3d-linux/9

( az AVX512 miatt a Core Ulte 9 285K -nál mindenképpen jobb

de persze nem árt spéci kapcsolókkal lefordítani a programot! ) -

PHenis

senior tag

válasz

tothd1989

#1868

üzenetére

tothd1989

#1868

üzenetére

Én is kínai kamerákat használok csak nekem poe megy mindenfele a padláson. Van egy hikvison beltérim ami rögzít, ezért nem olyan égető. Engem inkább a frigate mindenféle tárgy és személy felismerő funkciója izgat amit majd ki szeretnék próbálni. Csak ahhoz is kell egy gpu vagy egy google coral vagy valami... én még nagyon messze állok attól hogy ilyesmit írjak magamtól, nemrég keztem a linuxot megismerni/használni.

Én személy szerint imádom a community cuccokat mert a tizedénél nem tartanék nélkülük, szoktam is donételni ha valamit használok vagy supportot kapok.

Jól értem , hogy wifis kamerákkal rögzítesz folyamatosan? Az úgy elég keményen hangzik

-

tothd1989

tag

Igazából az összes opensource nvr program kagás, legalábbis a nagyobbak, mindegyik elhasalt valahol nálam. Mondjuk nekem wifi-s kínai kameráim vannak, a ház nagy része vályog, nehéz átlőni megfelelő erősségű jellel így valszeg az is gond, hogy van némi timeout, de ha ezt a kis kínai a saját programjában le tudta kezelni, akkor mindenki le tudja. De ez szubjektív vélemény, nekem alapból van egy álláspontom a linuxról és az egész mögötte álló ökoszisztémáról és communityről, ami nem túl rózsás, mindezek ellenére én is használom - néhol eredményesebben mintha windows futna helyette. A kamerákra meg elkeztem írni egy "saját" programot ami ffmpeggel rögzít, ami minden bizonnyal nem a legprofibb, mégis megy, bármi történik.

-

Mp3Pintyo

aktív tag

-

DarkByte

addikt

válasz

consono

#1862

üzenetére

consono

#1862

üzenetére

Perplexity-n még célzottan egy-egy domain-re is lehet csinálni keresőt a Spaces alatt, erre csak pár napja jöttem rá.

Hétvégén kísérletezgettem vele, itt a PH-n van a "Miben tegyem a megtakarításaimat?" topik amit már nem győzök követni, és tök jól tudtam kérdezgetni tőle. (pl. "milyen ETF-eket javasolnak a fórumozók ami kevésbé USA nehéz")

A PH komment link formátumával meggyűlik a baja, de a PH keresőjével viszont nem tudsz szemantikus módon keresni. Ha nem tudod mire keresel, csak körbeírni tudod, akkor meg vagy lőve. Na ebben az esetben tök jó.Illetve a Perplexity általánosságban marha jó kutatásokhoz, termékeket összehasonlítani, vagy csak friss információkat igénylő dolgokat megtudni (pl. mikor lesz elérhető a Severance 2. évadának utolsó része, tök jól megkeresi az helyett hogy neked kellene a reklámokkal telerakott oldalakon időt pazarolni)

-

5leteseN

senior tag

A Qwen2.5 14B Coder LLM állítólag egész jó a programozás területén. Nem tudom, hogy ezen belül hol-miben.

Ez a tudás összemérhető a "Nagyok" on-line gépeivel?

Saját gépen is futtatható, 12-16GB VRAM-os VGA már elég a magasabb szinthez: LM Studio, gondolom máson is(Olama, ...). -

S_x96x_S

addikt

válasz

hiperFizikus

#1858

üzenetére

hiperFizikus

#1858

üzenetére

> A ChatGPT MI modellnek feltettem vagy 100 kérdést mégse vagyok sokkal boldogabb,

Mi volt a prompt ?

Amúgy a promptolás nem olyan egyszerű ... főleg hogyha a boldogság a cél.

De még egy o1 - generált válasz se ér semmit se, hogyha nem próbáljuk ki:

""""

Napi Boldogság-Checklist (kiegészítve újabb tudományos megállapításokkal)

1.) Reggeli hála- és célkitűzés-percek

Ébredés után szánj 1-2 percet arra, hogy végiggondold, mi mindenért lehetsz hálás (család, egészség, kis sikerek, meleg otthon stb.). Tűzz ki aznapra egy apró, konkrét célt (például: „Ma kedves leszek magamhoz, nem rohanok át a sikereimen.”).

2.) Mozgás és örömhormon-aktiválás

Ha teheted, iktass be 5-10 perc testmozgást (gyors séta, nyújtás, könnyed jóga vagy pár guggolás-fekvőtámasz). A legújabb kutatások is megerősítik, hogy már napi pár perc is segíti az endorfinok és dopamin termelődését, így jobb hangulattal indul a nap. Ha több időd engedi, sportolj intenzívebben (futás, úszás, súlyzós edzés), de a lényeg a rendszeresség és a szervezet „beindítása”.

3.) Tudatos reggeli és hidratálás

Kutatások szerint a kiegyensúlyozott, fehérje- és rostgazdag reggeli segít stabilan tartani a vércukrot és a hangulatot. Igyál elegendő vizet vagy teát, mert a hidratáltság segít a koncentrációban és a közérzet javításában.

4.) Mini-énidő a napi rutinban

Mielőtt belekezdenél a munkába vagy a családi logisztikába, teremts pár „szemlélődős” pillanatot. Nézz ki az ablakon, tedd rendbe a gondolataidat, vagy csak lélegezz néhányszor mélyen. Ez a tudatos megállás „bonbonként” működik: tölt és segít tudatosítani, hogy „itt és most” is jól érezhetem magam.

5.) Sikerek észlelése – rögtön, amikor megtörténnek

Egész nap figyeld az apró eredményeket (például: időben elindult a gyerek az iskolába, befejeztél egy feladatot, kedvesen szóltál valakihez). Azonnal ismerd el magadban: „Ezt megcsináltam!”, „Ez is sikerült!”. Ez a gyors dopaminlöket segít a további motiváció fenntartásában.

6.) Örömtérkép frissítése

Tarts magadnál egy kis jegyzetfüzetet vagy használj jegyzet-appot a telefonodon, hogy napközben feljegyezd, mi okozott örömöt (akár kicsi, akár nagy dolog). Így tudatosan figyeled, mi tölt téged, és könnyebben újra is alkalmazod ezeket a tevékenységeket. Legújabb kutatások kimutatták, hogy már a pozitív élmények puszta dokumentálása is javítja a hangulatot.

7.) Társas kapcsolatok és oxitocin

Legalább egyszer naponta tudatosan gratulálj vagy dicsérj meg valakit (családtagot, kollégát). Az ő örömük visszahat rád, és fokozza az összetartozás-érzést. Az érintés, az ölelés vagy akár a közös nevetés mind-mind elősegíti az oxitocin termelődését, ami a közelség és boldogság érzését növeli.

8.) Rövid szünetek – tudatos légzés vagy meditáció

Délután vagy a nap sűrűbb szakaszaiban állj meg pár percre, és végezz légzőgyakorlatot (például 4 másodpercig beszív, 4 másodpercig bent tart, 4 másodpercig kifúj). Ha belefér, 5-10 perc egyszerű mindfulness-gyakorlat (csendes ülés, figyelem a környezet hangjaira vagy a belső érzésekre) segíti a szerotoninszint kiegyensúlyozását és a stressz oldását.

9.) Nap végi összegzés és hálanapló

Lefekvés előtt gondold át a napodat: „Mi sikerült jól?”, „Minek örültem?”, „Miből tanultam?”. Írd le ezeket 1-2 mondatban. Ez segít az agyat átállítani hiányfókuszról a bőség tudatára – tudományos kísérletek kimutatták, hogy akik rendszeresen írnak hálanaplót, általánosan magasabb boldogságszintet élnek meg.

10.) Minőségi alvás előkészítése

Kapcsold ki vagy tedd félre a kütyüket legalább 30 perccel elalvás előtt, hogy a kék fény ne zavarja a melatonintermelést. Alakíts ki egy nyugtató esti rutint (például olvasás, halk zene, könnyű nyújtás, meleg zuhany), ami segít ellazulni. A jó alvás kulcsszerepet játszik a testi-lelki regenerációban.

""" -

woryz

senior tag

válasz

hiperFizikus

#1858

üzenetére

hiperFizikus

#1858

üzenetére

-

consono

nagyúr

válasz

hiperFizikus

#1858

üzenetére

hiperFizikus

#1858

üzenetére

Boldogabb? Nem hiszem

De tud segíteni.

De tud segíteni. -

consono

nagyúr

válasz

hiperFizikus

#1856

üzenetére

hiperFizikus

#1856

üzenetére

De én igazán ezért szeretem:

Ha nem bízol benne meg tudod nézni miből dolgozott.

Ha nem bízol benne meg tudod nézni miből dolgozott. -

woryz

senior tag

Nem tudom, hol kérdezzem meg, ezért ha esetleg rossz helyen tenném fel a kérdéset, akkor sry előre is...

Előfizettem a chat gpt-re és néha agyf@szt kapok tőle, hogy mennyit hibázik, mennyire pontatlan. Nézelődtem, hog esetleg váltanék - általam ismert - másik modelre (Gemini, vagy Copilot), viszont nincsen kedvem nulláról kezdeni megismerkedni vele / velük. Valakinek lenne tanácsa, hogy mit célszerűbb használni? Általános kérdésekre és programozásban való segítségre is használnám a lelkem.

-

PHenis

senior tag

-

tothd1989

tag

válasz

tothd1989

#1850

üzenetére

tothd1989

#1850

üzenetére

Úgy nézem, a readme szerint támogatja a gpu-s generálást, de arra nem tudtam rábírni. Valószínűleg kézzel kellene újraforgatni a kódot vagy nem tudom, igazából csak a benchmark eredmények miatt szerettem volna kipróbálni. Egyébként egy ilyen összesített táblázatot érdemes lenne összehozni, melyik eszköz, hogy teljesít különböző cpun/gpun.

-

tothd1989

tag

válasz

5leteseN

#1841

üzenetére

5leteseN

#1841

üzenetére

Lefuttatam a benchmarkot, hogy tudjak némi használható adattal is szolgálni.

FastSD Benchmark - PyTorch--------------------------------------------------------------------------------Device - CPU,Intel(R) Core(TM) i7-14700KFStable Diffusion Model - stabilityai/sd-turboImage Size - 512x512Inference Steps - 1Benchmark Passes - 3Average Latency - 4.134 secAverage Latency(TAESD* enabled) - 1.472 sec--------------------------------------------------------------------------------*TAESD - Tiny AutoEncoder for Stable DiffusionFastSD Benchmark - OpenVINO--------------------------------------------------------------------------------Device - CPU,Intel(R) Core(TM) i7-14700KFStable Diffusion Model - rupeshs/sd-turbo-openvinoImage Size - 512x512Inference Steps - 1Benchmark Passes - 3Average Latency - 3.468 secAverage Latency(TAESD* enabled) - 1.154 sec--------------------------------------------------------------------------------*TAESD - Tiny AutoEncoder for Stable Diffusion -

tothd1989

tag

válasz

Mp3Pintyo

#1847

üzenetére

Mp3Pintyo

#1847

üzenetére

Már tesztelgettem (amúgy túrót a fülébe minden olyan (hobbi) fejlesztőnek, aki nem írja oda, milyen shellt kell használni (bash, ps, cmd nem volt jó, miniconda lett a nyerő)). 2 perc csinált a 14700kf 4db képet 1024x1024-es felbontásban az alap modellel. Sajnos csak 77 tokent támogat, meg nem is a legjobb az alap modell, mert elég sok anomália a generált gépeken, direkt egy elmentett promptot próbáltam, ami fooocus alatt majdnem tökéletes kimenetet eredményezett. Mindenesetre köszönöm a linket!

-

Mp3Pintyo

aktív tag

-

PHenis

senior tag

válasz

DarkByte

#1844

üzenetére

DarkByte

#1844

üzenetére

Hát a szerverrel lehet túloztam kicsit, egy sff gép van az emeleten proxmoxal.

Videókari csak lowprofilos megy bele, a táp is elég karcsú, szóval gpu mostanában nem lesz sztem. Bár kéne a frigate-nak meg a plex-nek is, hosszútávon tervben van az upgrade... egyelőre marad a cpu.Köszönöm mindekinek a linkeket, tanácsokat, megnézem mi az ami linux parancssorból is megy. Kezdetnek ez így kiváló nekem

-

DarkByte

addikt

Kb. a fastsdcpu jöhet szóba, ez még úgy ahogy elketyeg egy Raspberry-n. De még ezzel is sokáig fog tartani mire kapsz valami értelmezhető kimenetet, főleg az újabb modellekkel. A minőség meg hát.. nos 1-2 step-től nem kell csodát várni.

Sajnos ez a műfaj GPU-t igényel.

Képgenerátoroknál különösen. Az hogy nem tudsz relatíve gyors iterációkban kísérletezni kb. megöli az egészet. -

5leteseN

senior tag

Erősen javasolt egy 8GB(+os még inkább) VRAM-os VGA beszerzése, mert CPU-s üzemmódban hamar ideges leszel a sok várakozás alatt elfogyasztott sok kávéktól (is)!

![;]](//cdn.rios.hu/dl/s/v1.gif)

Számokban(LM Studio, a magasabb érték a jobb):

- CPU: 6-7 token/mp, /

/

- AMD VGA(Vega56=>64, tuningolt): 22-30 token/mp /

/

- nVidia(2080Ti alap beállítások): 45-58 token/mp. /

/

AI-MI-t CPUval az

LM Studio-n(LLM-chat),

a Krita-n(kép, video-animáció, ez utóbbihoz brutál PC-VGA kell),

és mintha a Fooocus...is tudná az előzőek három üzemmódját(CPU-s, VGA-s: AMD/nVidia).

-

PHenis

senior tag

Sziasztok,

új vagyok, elkezdett érdekelni ez a téma engem. A házi "szerveremen" elkezdtem játszani modellekkel, debian lxc, Stable-diffusion webui, 4cpu mag és 38GB ramnyi lehetőségem van játszani, videókártya nincs. A huggingface-ről töltögettem le modelleket de elég esetlegesnek tűnik hogy működnek-e. Melyik az ajánlott írás/videó arról hogy hogy kell ezt jól csinálni? Többnyire zöld-rózsaszín pixelkupacot kapok képgeneráláskor mint régen mikor karcos cd-ről játszottam le az mpeg videót vagy összekutyulódott az ace mega codec pack... Gondolom gpu-ra optimalizát modellek miatt van vagy ilyesmi, de hogy szűrök rá a cpu-n is jól futó modellekre?

-

ptesza

senior tag

válasz

hiperFizikus

#1824

üzenetére

hiperFizikus

#1824

üzenetére

Sokkal. Ha nem fizetsz játsza a hülyét. Nem lehet képet feltölteni stb.

-

tothd1989

tag

válasz

5leteseN

#1826

üzenetére

5leteseN

#1826

üzenetére

Huhh, köszi a leírást (örvendetes, hogy, itt nem divat a ménemóvasolvissza').

Ha nem lettem volna teljesen egyértelmű (elő szokott fordulni), a k80-ra azért gondoltam, mert kis pénzért a sok vram + cuda csábító volt, és ha nem válik be - nem fáj, mert nem áldoztam sokat rá.

Nagyon referenciáim nincsenek mihez, vagy mivel mérjek - én csak a nyers tulajdonságokat látom...

Kb ahhoz viszonyítok mindent, hogy a 3070TI-m mennyire gyorsan számol, mert más AI ready kártyám nincs (a 6600xt-t nem tudtam rábírni, mert szerintem ott valami gubancot okoz, hogy egy virtualizált környezetben van, meg eleve szarok a radeon driverek).

P40: ezzel az a bajom, hogy ennyiért vagy minimálisan többért már egy rtx 3080-at be lehet szerezni amit könnyebb eladni ha esetleg cserélek.

VISZONT, mivel a 3080 csak éppen hogy a 3070 TI felett van, így nyilván nem veszek magánemberként olyan kártyát CSAK AI-ra, ami jobb mint ami abban a gépben van amin játszom (főleg úgy, hogy amúgy már egy ideje kinőttem a kártyát, mert nagyon kevés 4k 144fps-re). -

Zizi123

senior tag

válasz

consono

#1835

üzenetére

consono

#1835

üzenetére

Rengeteg lehetőség van, hogy miért nem lesz belőle semmi.

- 2 év múlva már elavult lesz.

- A kutya nem fogja venni a szoftveres támogatás hiánya miatt.

- Megveszi másik sokkal nagyobb piaci szereplő.Nem véletlenül nincs más piaci szereplő a nagyokon kívül évtizedek óta.

Amikor Kína (ahol ilyenekre pénz nem számít) is saját gyorsítón dolgozik, és nincs még kézzel fogható eredménye, akkor majd jön a semmiből 1 úriember, és bejelenti a tutit...

Hááát nem tudom....

Gyanum szerint a nagyok már régen tudtak erről, csak éppen nem tartották életképes ötletnek, és nem vásárolták meg már régen. -

consono

nagyúr

Az új AMD Adrenalin driver nagy gyorsulási hoz ROCm és Vulkan alatt is a 7000-es sorozaton: [link]

-

-

DarkByte

addikt

válasz

consono

#1832

üzenetére

consono

#1832

üzenetére

Szerintem annyira nem elképzelhetetlen hogy tényleg piacra kerül, pont azt csinálja amit páran már vizionáltak, történetesen hogy az open source RISC-V architektúrából tök jó kis GPU magokat lehetne csinálni, kiegészítve őket az ehhez szükséges utasításokkal.

Ha ők nem is, 2026-ig ezt más össze fogja hozni, annyira adja magát. Persze ez nekünk inkább csak jót jelent, mert lesz választék. Pont ilyesmi bejelentéseket szeretnék még látni.

---

Egyébként most George Hotz-nak is sikerült addig szadizni az AMD-seket, hogy küldtek neki egy MI300X szervert, hogy a bare metal tinygrad illesztésüket tudják rajta kalapálni. [link] A fickó erősen megosztó, de az unorthodox módszere úgy tűnik működik és még ez akár jót jelenthet az AMD cuccainak AI kompatibilitását illetően

[link] A fickó erősen megosztó, de az unorthodox módszere úgy tűnik működik és még ez akár jót jelenthet az AMD cuccainak AI kompatibilitását illetően

-

S_x96x_S

addikt

válasz

Zizi123

#1830

üzenetére

Zizi123

#1830

üzenetére

> a memória sávszélesség a legfontosabb

> a nagy LLM-ek használata közben, akkor ez eleve kizárja azt, hogy világverő legyen.Elnézést valószínüleg - félreérthető voltam.

azt irtam, hogy

"Max 4 chiplet lehet egyben és kétféle memóriát használ mindegyik chiplet:"

vagyis egy chiplet adatát adtam meg:

- gyors: 32 - 64 GB -os [ 273 Gb/s] LPDDR5X -es ( hasonló mint a Strix Halo ) ]

- és egy lassú So-DIMM -es DDR5 ~ 90Gb/s - sebességgeset.amit fel kell szorozni 4x - a 4 chipletes verzióhoz.

- max memória : 2.304 GB ( 256 GB LPDDR5X + 8x DDR5 DIMMs )

- és max sávszél - 1.45 TB/sLásd slide :

persze mire a Zeus megjelenik +2 év múlva, akkora

a [ Strix Halo / nVidia Digits ] utódja is kaphat nagyobb bővíthető memóriát ; -

Zizi123

senior tag

válasz

S_x96x_S

#1829

üzenetére

S_x96x_S

#1829

üzenetére

Akkor jól láttam, hogy olyan, mintha notebook memóriával lehetne bővíteni, na de itt ez már probléma is, hogy az viszont nem gyors....

Tehát ha hiszünk abban, hogy a memória mennyiség mellett, a memória sávszélesség a legfontosabb a nagy LLM-ek használata közben, akkor ez eleve kizárja azt, hogy világverő legyen.

Ha jól gondolom, akkor a 12 csatornás Pl Epyc szerverek memória sávszélessége 576 GB/s, ami "duplája" ennek a tervezett kártya a sávszélességének, és arra jutottunk, hogy a dual Epyc szerver alkalmatlan a nagy nyelvi modellek futtatására, mert tetű lassú.

A Mac Studio M3 Ultra 819GB/s, az RTX 4090 1008GB/s, H100 NVL 3.9TB/s.

Most 2025 elején...

2027 elején már nem ezek a számok lesznek.Tehát nem teljesen vágom, hogy is lesz ez világverő, de nyilván csak valamit nem vettem figyelembe.

-

S_x96x_S

addikt

válasz

Zizi123

#1828

üzenetére

Zizi123

#1828

üzenetére

(Bolt graphic )

> Mivel bővíthető egyébként, milyen memóriával?Sima laptop [ SO-DIMM DDR5 ] -el.

Max 4 chiplet lehet egyben és kétféle memóriát használ mindegyik chiplet:

- gyors: 32 - 64 GB -os [ 273 Gb/s] LPDDR5X -es ( hasonló mint a Strix Halo ) ]

- és egy lassú So-DIMM -es DDR5 ~ 90Gb/s - sebességgeset.a két típusú memóriát mintha együtt használná

és így 273+90 = 363 Gb/s sebességet adnak meg

a slide-okon - 1 chipletre. ( slide 36. )https://bolt.graphics/wp-content/uploads/2025/03/Bolt-Zeus-Announcement-External.pdf

> mire piacra kerülne lesznek sokkal jobbak, és így el sem kezdik gyártani...

IP Licenszet árulnának mint az ARM;

vagyis tervet - amit az ügyfél cutomizálhat. -

Zizi123

senior tag

válasz

S_x96x_S

#1819

üzenetére

S_x96x_S

#1819

üzenetére

Ha lenne annyi mFt-om amennyi ilyen ígéretes világmegváltó kártyából nem lett semmi...

Mivel bővíthető egyébként, milyen memóriával?Arról nem is beszélve, hogy az még durván 2 év mire ebből leghamarabb lesz valami. Kicsit csúszik majd, és mire piacra kerülne lesznek sokkal jobbak, és így el sem kezdik gyártani...

-

5leteseN

senior tag

válasz

5leteseN

#1826

üzenetére

5leteseN

#1826

üzenetére

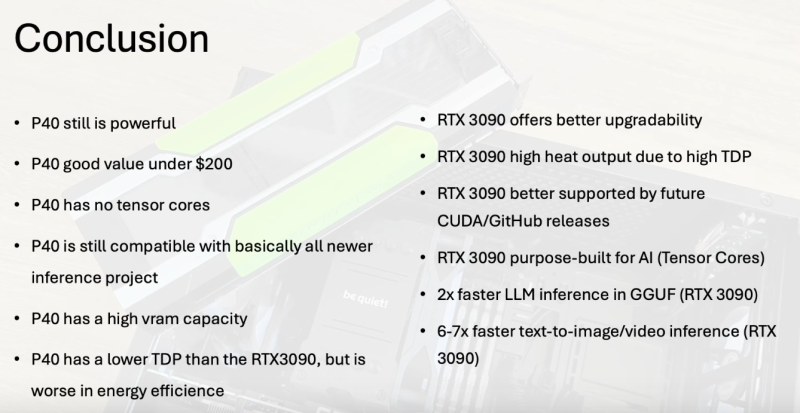

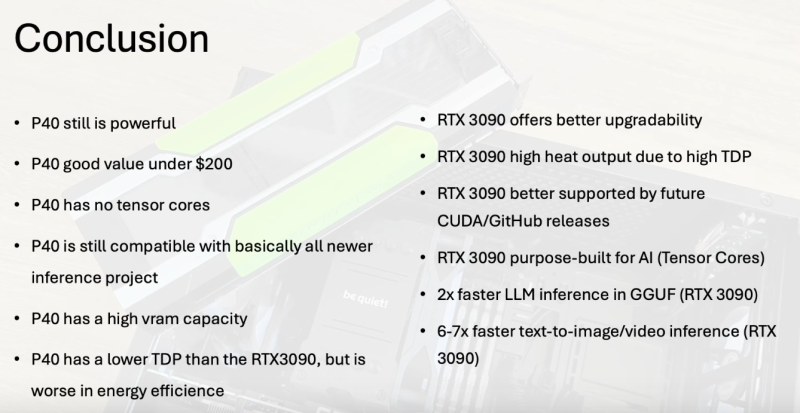

A 3090 vs. P40 Yt-videó alól egy hozzászólás (gép fordítással):

@FromDesertTown 1 nappal ezelőtt :

" K80 cards are interesting old monsters - only $50 for a 24GB GPU (used). Sure, it's so old that it only supports up to CUDA 11.4 v4, so you're out of luck trying to run most models, and the technical specs are very lackluster other than the high VRAM, but it's sure to tempt some folks!""A K80 kártyák érdekes régi szörnyek - mindössze 50 dollár egy 24 GB-os GPU-ért (használt). Persze, olyan régi, hogy csak a CUDA 11.4 v4-ig támogatja, így nincs szerencséje a legtöbb modell futtatásával, és a műszaki specifikációk nagyon halványak a magas VRAM-on kívül, de néhány embert biztosan csábít!"

-

5leteseN

senior tag

válasz

tothd1989

#1825

üzenetére

tothd1989

#1825

üzenetére

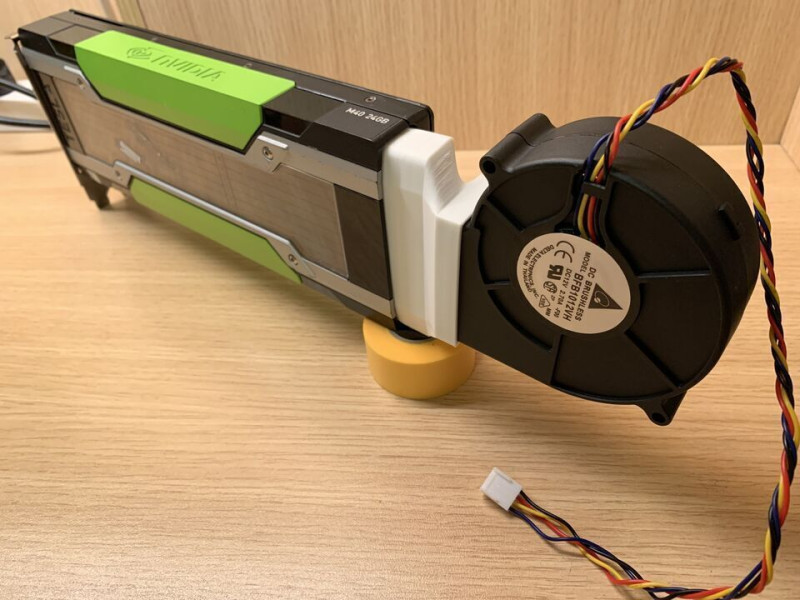

Én inkább egy nVidia TESLA P40-et javaslok, az "igazi" 24GB VRAM, nem a kérdéses 2x12GB. Ilyen "magában", PCIe=>EPS adapterrel(eBay: 200$ körül):

...asztali gépbe előkészítve(a +blower hűtővel, kompletten+, kb. 30€/$):

Korábban ide is linkeltünk egész korrekt értékelést a P40-ről, abból kb összegezve: szövegesekhez még jó, több P40-nel tanítani is, kép-videó generálásra már saját használatra is gyengusz, de belépőnek elmegy.

Saját kiegészítés: Kétséges, hogy jól(kb null-szaldós egyenleggel) lehet kiszállni majd belőle.Ilyen:

..is viszonylag megfizethetően kiépíthető(3x200$/€, + az alapgép), de igazán csak szöveges (chat) AI-MI-re, tanításra lesz jó, a kép-videó generáló szoftverekkel eléggé "várakozós".

AI-S induló start-up-nak, tanításra, LoRA, RAG kipróbálásra elég, kis anyagi kockázattal.A Yt-on szerintem pikk-pakk kidobja a P40 összehasonlítós videókat, köztük azt a szerintünk is elég-jó szakmait, amit már linkeltünk is.

Egy a sok közül, ami az etalonnak számító 3090-el hasonlítja össze(nem néztem meg, nemtom' milyen szintű értékelés):

ITT(Yt) .A végére: kis eBay-es "lesben állással" 50-100€ között komplett szervert(HP/DELL) is el lehet csípni hozzá 60(nekem sikerült 128GB) RAM-mal.

![;]](//cdn.rios.hu/dl/s/v1.gif)

A két asztali gépes +hűtő egység-csomag(kb 2x30€) többe kerül!

...kis szerencsével! -

tothd1989

tag

válasz

5leteseN

#1823

üzenetére

5leteseN

#1823

üzenetére

A hűtés nem hiszem, hogy probléma lenne, a blogomban leírt amd gépbe raknám, ami egy nzxt h7 flowban lakik. abban mindennek is van hely. tápcsatit írtam, hogy kell,

bár nem tudom nem e lehet esetleg direktbe a cpu konnektort beletolni, mert a tápon van még cpu output. nwm, túlterhelné azt a szálat a tápon, bár 1000w-os, de ügye pci-en van a nagyobb teljesítmény. a 24gb-ot néztem, hogy 2x12 (mivel gyakorlatilag két kártya van egyetlen nyákon), nem tudom megmondom öszintén, hogy kezeli. szeretnék valami kártyát csak AI-ra, de a legközelibb elérhető opció a 3060 vagy a 1080 (20-as szériában nem nagyon láttam olyat aminek több mint 8gb vramja van), ezért gondolkodtam el rajta. -

5leteseN

senior tag

válasz

tothd1989

#1818

üzenetére

tothd1989

#1818

üzenetére

A TESLA K80 2x12GB!! Gyanús, hogy egyben nem tudja 24GN-ként használni. A rajta használt Kelpler-GPU-t a mostani AI-MI szoftverek egyre jelentősebb része nem támogatja. Ez a folyamat csak rosszabb lesz.

Poénnak jó, jelentős napi gyakorlati használat szempontjából zsákutca.

Ahogy lassan a TESLA P4, P40 és AMD MI25ők is: elfogy alóluk a szoftver támogatás(CUDA, ROCm, ...).Ha nem szerverbe rakod, akkor még +venti-adapter és blower-venti is kell ám hozzá: +25-40€ összesen, kb!

Ismerős a helyzet P40 tulajdonoskén!

-

ptesza

senior tag

A chat GPT-nél nem lehet fizetni Revolut kártyával?

Ok megy csak letiltottam korábban az automatikus levonások elkerülése érdekében. -

S_x96x_S

addikt

új jelölt a Lokális LLM -re

bővíthető memóriája van !!!!!

van belőle több változat ..

( Sajnos 2026 Q3 előtt nem lehet tesztelni .. )

https://prohardver.hu/hir/bolt_graphics_zeus_gpu_dizajn.html

500W -on

+ Up to 2.304 GB @ 1.45 TB/s

+ 512MB on-chip cache

+ 6x 800 GbE

-

tothd1989

tag

Abszolút releváns kérdés, mit gondolsz, ha egyetlen szó analizálásában téved, akkor egy komplex kérdés esetén mi történik?

Más:

Túrtam az ebayt és találtam tesla k80-at 16000 jó magyar forintért (+a szállítás +be kell szerezni hozzá a tápkábel fordítót).

Megérné ennyi pénzt belefeccölni? Az megvan, hogy 11 éves kártya, de 2x 2496 cuda core és 24(!!!)gb vram. -

S_x96x_S

addikt

válasz

consono

#1807

üzenetére

consono

#1807

üzenetére

>> 5 db "eper" szóban - hány db "r" betű van ?

> De ez "buta" kérdés egy LLM-nek...de nem lehet minden kérdés "buta"

ha nem tud rá válaszolni egy

"mathematical reasoning, coding proficiency, and general problem-solving capabilities." -al

reklámozott modell.

és a "QwQ-32B" - ennek a "buta"' kérdésnek

még egyszerűbb formájával lett demózva - amire persze tudja a választ, de kontextusban már nem:

- prompt = "How many r's are in the word \"strawberry\""

https://qwenlm.github.io/blog/qwq-32b/persze az én promptomban annyi változás van, hogy magyar nyelvre át lett fogalmazva és hozzá lett adva, hogy "5db eper szó" -ra adja meg a választ.

És így már elbukik a "QwQ-32B" - pedig "papiron" igéretes lett volna.

"QwQ-32B is evaluated across a range of benchmarks designed

to assess its mathematical reasoning, coding proficiency,

and general problem-solving capabilities.

The results below highlight QwQ-32B’s performance in comparison

to other leading models, including DeepSeek-R1-Distilled-Qwen-32B,

DeepSeek-R1-Distilled-Llama-70B, o1-mini, and the original DeepSeek-R1."---

> Persze arra meg pont jó ez a kérdés, hogy rávilágítson arra,

> hogy nem mindenre jók az LLM-ek, nem minden a diffúzió, meg az attention.

tesztelésre jól lehet használni;

és a "QwQ-32B" - sajnos még nem ér fel egy eredeti DeepSeek-R1 -el.

"We are excited to introduce QwQ-32B, a model with 32 billion

parameters that achieves performance comparable to DeepSeek-R1,

which boasts 671 billion parameters (with 37 billion activated)." -

DarkByte

addikt

A nyers LLM-re kb. érdemes úgy tekinteni mint egy nagyon okos auto complete, vagy fogalmazó gép. A beszélt emberi nyelv szabályai mentén meglepően hihető szöveget képes neked írni, illetve ugyanígy az szavak összefüggéseit megérteni és átírni egy másik formára.

Okkal hívják az LLM-eket stohastic parrot-nak, vagyis olyanok mint egy papagáj amely meglepően hosszú emberi szövegeket képes megjegyezni és visszaadni, de fogalma sincs hogy amit ír az mit jelent.

Amit tartalomban leír arra semmi garancia nincs hogy az helyes.

Nem is tesztelik. Gondolj bele, kb. "feleltetni" kellene az LLM-et az emberiség teljes tudásából, ez lenne a kiadás előtti kritérium, hogy mindent is helyesen meg tud-e válaszolni. Lehetetlen, és nem is ezért lettek tanítva.

(Eleve nem is lehet minden kérdésre ezt egyértelműen tesztelni, mert még mi emberek sem tudjuk minden kérdésre egyöntetűen a választ, hiszen megoszlanak a vélemények.)Azt kell látni, hogy mindegyik ilyen internetes AI felület abba az irányba halad, hogy az LLM-et inkább nyelvi interfészként próbálja használja, vagyis az általad adott szabad szöveges kérdést áttranszformálják valami hagyományos algoritmussal feldolgozható bemenetre, ami alapján már lehet vele valamit kezdeni (pl. indítani egy webes/adatbázis keresést aktuális információk gyűjtéséhez; számológép/script használat; önellenőrzés, stb.); ugyanígy vissza irányba, van egy nyers embertelen gépi kimenet és megkérni az LLM-et ezt írja át emberileg olvasható szövegre.

Az LLM saját modelljébe kódolt tudást azt pedig inkább szókincsként használni. Mint egy sokat olvasott ember, aki képes választékosan írni, de még neki is kutatómunkát kell végezni ha pontos választ akar írni egy adott témában.

Erre jó az LLM. Csak aki ezt nem tudja hogy ezek így működnek, nyilván első találkozáskor a szavahihetőnek tűnő válasz alapján úgy tűnhet valami teljesen új élőlénnyel áll szembe. De erről szó sincs.

Csak ugye mint tudjuk: „Bármely kellően fejlett technológia megkülönböztethetetlen a mágiától.”

Ezért kell kicsit rászánni az időt és megérteni mi is ez.A hosszabban gondolkodó LLM-ek is csak azért tudnak pontosabb választ adni, mert szimplán ez a fenti működés velejárója, hogy minél több token van a context ablakában, a teljes modell lehetséges következő token problématere annál jobban leszűkül egy kis zsebére, ahol jó eséllyel ott van a helyes "megoldás", és ennek a keresésére több ideje van, hosszabb utat jár be, több lépésben, mintha azonnal egyetlen token-be sűrítve kellene kiválasztani a helyes megoldást abból a rengeteg kódolt tudásból (kvázi hasra ütés szerűen). De ezek a modellek sem tévedhetetlenek önmagukban.

consono: igen. Marha jól magyaráz a fickó, jó érzéke van hozzá. Pedig amit átad az marhára nem egyszerű.

Terveztem már nekiülök a Neural networks: Zero to Hero sorozatában vele párhuzamosan lekódolni amiket csinál játék mini AI-kat, de egyszerűen nincs rá időm. Meló mellett egyszer már végig hallgattam, de mégsem úgy marad meg, mintha végig kódolom én is. Sokkal vizuálisabb alkat vagyok ennél.

Meló mellett egyszer már végig hallgattam, de mégsem úgy marad meg, mintha végig kódolom én is. Sokkal vizuálisabb alkat vagyok ennél.

Plusz amit csinál egyébként redundáns, hiszen a Pytorch mind megvalósítja ezt. Csak nyilván sokkal jobban megérthető az a framework is mit csinál, ha tudod milyen problémát egyszerűsít.

A másik oldalról meg az is ott van, hogy ez egy olyan műfaj, hogy otthon a te kis GPU-ddal esélyed sincs olyan modellt tanítani ami a nagy modellek tudásának töredékét tudják, vagy évtizedekig kellene futtatni. Kicsit ez meg lelombozó. Visszatért az informatika a mainframe-es időszakba ezzel kicsit

-

DarkByte

addikt

válasz

Zizi123

#1812

üzenetére

Zizi123

#1812

üzenetére

Mert erre is meg kell tanítania valakinek.

Amire alapból tanítva van hogy adjon egy következő token-t neked statisztikai alapon. Akkor is ha az baromság. Ezért hallucinál, mert nincs más választása alap esetben. Álmodik neked egy szöveget, Karpathy így is hívja a nyers LLM-et: internetes dokumentum szimulátor.Ahhoz hogy azt tudja mondani "nem tudom" be kell "drótozni" utólagos finomhangolással az "agyának" azon részeit ami akkor aktiválódik amikor bizonytalan a megoldásban. De ahhoz előbb ezeket meg kell találni, hogy tanító példákat lehessen rá neki írni, ami már önmagában nem egyszerű.

A ChatGPT pl. már csinál ilyet, plusz az előfeldolgozója sokszor rájön hogy az alap LLM képtelen arra amit kérsz és elkezd inkább külső eszközöket használni. De, figyelembe véve hogy a probléma halmaz az "emberiség tudása" azért van pár variáció.

De tényleg, nézzétek meg a Karpathy videót. Rengeteg dolgot helyre tesz. Igen hosszú, de lehet több szakaszban.

Nem árt megérteni hogy az LLM tudása egy veszteséges tömörítése az internet egészének. Nem emlékszik mindenre kristály tisztán. Azokat a dolgokat amelyek nagyon sokszor vannak említve a tanuló adatbázisában (vagy mesterségesen priorizálva voltak, pl. egy Wikipedia szócikk) tisztábban "emlékszik" mint amelyeket csak nagyon keveset láttot. Utóbbiaknál sokkal nagyobb az esélye hogy kitalál neked valamit.

Minő érdekes, mi is pont így működünk. Ha valami tudást keveset vagy elvétve használtál, az homályos

-

Zizi123

senior tag

Szerintem az emberek 1 csomó olyan dolgot kérdeznek az AI-tól amire a Google is kidobja az "eredményt", mégsem azt használják, pedig könnyebb lenne, mint python egysorost írni...

Egyébként meg nyilván nem a végeredmény volt a fontos, hanem gondolkodás tesztelése.Amikor Zsolt felteszi a klasszikus kérdést, hogy "1 kerek asztalnál az embertől jobbra, és balra is 5-en ülnek, akkor mennyien ülnek összesen az asztalnál?" Őt sem az érdekli, hogy mennyi az eredmény, hanem, hogy jó-e, megtudja-e oldani, tud-e gondolkodni...

-

DarkByte

addikt

válasz

S_x96x_S

#1806

üzenetére

S_x96x_S

#1806

üzenetére

Nézzétek meg Karpathy videóját (most már van második része is). Tök jól elmagyarázza az LLM-ek működését, korlátait. Szerintem tananyag szintű amit ebben a két videóban átad.

Pl. ezt az "r" betű számolást is elmagyarázza, hogy azért hülyeség, mert az LLM nem is karakterekben "lát", mivel token-ekkel dolgozik, amelyek tömörítenek több karaktert egy új szimbólumba.

Ami "fejben számolást" ("mental arithmetic") igényel egy LLM-nek azt mint jó eséllyel elrontja a legtriviálisabb példákat leszámítva. (Ahogy te sem tudsz összeszorozni akármekkora számokat fejben hozzáteszem.) Ahogy Karpathy is mondja, az ilyeneknél inkább meg kell kérni írjon egy Python programot ami kiszámolja a problémát. (ahogy te is előveszel számológépet a nehéz problémáknál)

-

Zizi123

senior tag

Nem az a cél, hogy okosabb legyen az AI az embernél, olyan dolgokat fedezzen fel, amit az ember még fedezett fel, és olyan problémákat oldjon meg amit eddig az embernek nem sikerült?

Azért az elég fura, hogy 1 olyan rendszertől várjuk ,hogy megváltsa a világot, új dolgokat találjon ki, fedezzen fel, ami arra pont nem alkalmas, hogy "r" betűket megszámoljon.

Ellenben bármikor tud olyan programot írni, ami megszámolja az "r" betűket...

Hát ez elég érdekes...Ami még érdekes,. hogy a válaszadó LLM-ek 1 része "Reasoning", tehát nagyon gondolkodik, nagyon érvel, nagyon ellenőriz, és mégis hülyeséget mond????

Hát ez fura nekem. -

-

consono

nagyúr

válasz

S_x96x_S

#1806

üzenetére

S_x96x_S

#1806

üzenetére

De ez "buta" kérdés egy LLM-nek... A token predikcio definíció szerint nemntud számolni, nem tudom miért várjuk el.... Látszik is, hogy ami tud válaszolni az valami kerülő algoritmussal válaszolja meg a kérdést.

Persze arra meg pont jó ez a kérdés, hogy rávilágítson arra, hogy nem mindenre jók az LLM-ek, nem minden a diffúzió, meg az attention. -

S_x96x_S

addikt

Az én kedvenc teszt kérdésem :

5 db "eper" szóban - hány db "r" betű van ?

-------- [ Válaszok: ] -------

DeepSeek R1 (webes; valószínüleg a nagy model ) :

--> 5 darab "eper" esetén: 1 × 5 = 5 db "r" betű.ChatGPT o3-mini-high :

--> 5db !"ollama run qwq:32b "

--> **Answer:** 1"ollama run deepseek-r1:32b"

--> **Végső eredmény:** 1"ollama run phi4-mini "

--> "Így válaszolunk: Az ötdból álló szóban „eper” három db 'r' betű van.""ollama run mixtral:instruct"

---> 5 db "eper" szóban a "r" betűnek összesen 5 darabja van, mivel minden "eper" szó egy-egy "r" betűt tartalmaz."ollama run gemma2:27b-instruct-q8_0"

--> 5 db "eper" szóban **10 db** "r" betű van. Mert minden "eper" szóban 1 db "r" betű van, és 5 x 1 = 10."ollama run llama3.2-vision:11b"

--> A válasz 2"ollama run openthinker:32b"

--> There are 5 'r' letters in five instances of the word "eper"."ollama run openthinker:7b"

--> **Végső válasz:** A nyilvántartás szerint **összesen 5 db 'r' betű vannak az öt 'eper' szóban.**"ollama run qwen2.5:32b"

--> Tehát 5 db "eper" szóban 5 db "r" betű van. -

tylerddd

veterán

Üdv! Tengr.ai-t használ valaki? Az előfizetéses verzió (Basic) szöveg alapján történő képgenerálása nevetséges. Alapvető dolgokat nem ért meg jól körülírt formában sem. Mintha Google fordítót használna annak megértéséhez, amit írok. Tablet helyett tablettát tesz a képre

-

5leteseN

senior tag

válasz

5leteseN

#1803

üzenetére

5leteseN

#1803

üzenetére

Az előzőekhez tartozik a Thunderbolt-5 10GBps-os valósnak becsült sebességéhez képest, hogy a jelenleg többségi használatú alaplapokban a DDR4-ek 35-60GBps közötti sebességűek, kétcsatornás üzemmódban(tipikus-általános, megfizethető-kategóriás asztali-PC).

A DDR5-ösök ezt tudják duplázni 50-120GBp közé.

A Ph-Fórumos DDR5-legjobbra(házi-rekordra) én kb 150GBps-ra emlékszem, V.I.P-RAM-mal, vízhűtéssel, tuning-alaplappal, és természetesen ezek árával +a saját tesztelő-beállító munka.

A Thunderbolt-5 esetén az ezzel összehasonlítható érték ugye az azonos mértékegységbe konvertált 10GBps, és a x4-5-6-ős összeaddó érték az almás kütyük esetében(az első TH-5 100%, a többi x0,7 kb).Így összehasonlítható értékekkel kerek a "történet".

-

5leteseN

senior tag

válasz

S_x96x_S

#1800

üzenetére

S_x96x_S

#1800

üzenetére

Igen,

ez volt az az adat, amire említettem is, hogy nem 100%, hogy jól emlékszem.

ez volt az az adat, amire említettem is, hogy nem 100%, hogy jól emlékszem.Ez már egy szép érték, ehhez jön szűk keresztmetszetként a gépek közötti Thunderbolt 5-ös 120Gbps-ából a kb (általam becsült ! )valósnak tippelt és konvertált 10GBps x 4-5-6(Tb-5).

...ha kell majd egyáltalán egy M3 Ultra felhasználónak, mert ugye az 512GB-ba már minden "civilnek" szánt LLM bele fog férni aki rászánja az x-millió(mennyi is ) HUF-ot/€-t/$-t...

) HUF-ot/€-t/$-t...A piaci-keresleti mérleg serpenyőjében ott leszünk még sokáig majd az ehhez képest sokszor több millióan a korábbi(tipikusan 8-16GB között VRAM-mal szerelt) VGA-kal .

Ezek miatt a piaci arányok miatt nem aggódok azon, hogy nem lesznek rövid időn belül az általam említetthez hasonló további megosztott szoftverek illetve általános+célterület LLM párosítások. A mostani (valóban megdöbbentően eredményes ) Instruct-modelles szoftver alkalmazás mutatja az ebben rejlő lehetőségeket.

) Instruct-modelles szoftver alkalmazás mutatja az ebben rejlő lehetőségeket.Józan fejlesztő csoportok (szerintem) szntén eljutottak eddig a lehetőségig, és (úgy gondolom, hogy) már dolgoznak erre a logikusnak tűnő szoftver-válaszon.

...megemlítettem, mint egy (nekem logikus)lehetőség a naponta felbukkanó újak között!

Megtaláltam közben: az 512GB RAM-os Ultra M3 4,5millió HUF.

-

S_x96x_S

addikt

""""

...The M3 Ultra 512GB Mac Studio fits perfectly with massive sparse MoEs like DeepSeek V3/R1.

2 M3 Ultra 512GB Mac Studios with @exolabs

is all you need to run the full, unquantized DeepSeek R1 at home.The first requirement for running these massive AI models is that they need to fit into GPU memory (in Apple's case, unified memory). Here's a quick comparison of how much that costs for different options (note: DIGITS is left out here since details are still unconfirmed):

NVIDIA H100 (80GB): 37.5/s

AMD MI300X (192GB): 27.6/s

Apple M2 Ultra (192GB): 4.16/s (9x less than H100)

Apple M3 Ultra (512GB): 1.56/s (24x less than H100)Apple is trading off more memory for less memory refresh frequency, now 24x less than a H100. Another way to look at this is to analyze how much it costs per unit of memory bandwidth. Comparison of cost per GB/s of memory bandwidth (cheaper is better):

NVIDIA H100 (80GB): $8.33 per GB/s

AMD MI300X (192GB): $3.77 per GB/s

Apple M2 Ultra (192GB): $6.25 per GB/s

Apple M3 Ultra (512GB): $11.875 per GB/s

There are two ways Apple wins with this approach. Both are hierarchical model structures that exploit the sparsity of model parameter activation: MoE and Modular Routing.MoE adds multiple experts to each layer and picks the top-k of N experts in each layer, so only k/N experts are active per layer. The more sparse the activation (smaller the ratio k/N) the better for Apple. DeepSeek R1 ratio is small: 8/256 = 1/32. Model developers could likely push this to be even smaller, potentially we might see a future where k/N is something like 8/1024 = 1/128 (<1% activated parameters).

Modular Routing includes methods like DiPaCo and dynamic ensembles where a gating function activates multiple independent models and aggregates the results into one single result. For this, multiple models need to be in memory but only a few are active at any given time.

Both MoE and Modular Routing require a lot of memory but not much memory bandwidth because only a small % of total parameters are active at any given time, which is the only data that actually needs to move around in memory.

.....

"""

Új hozzászólás Aktív témák

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- AMD Navi Radeon™ RX 9xxx sorozat

- Milyen házat vegyek?

- Győr és környéke adok-veszek-beszélgetek

- Autós topik

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Hyundai, Kia topik

- Robogó, kismotor

- gban: Ingyen kellene, de tegnapra

- Azonnali alaplapos kérdések órája

- További aktív témák...

- BESZÁMÍTÁS! Gigabyte AORUS B450 R5 5600X 16GB DDR4 512GB SSD GTX 1080 Ti 11GB ASUS GT 301 FSP 700W

- 121 - Lenovo Legion Pro 5 (16ARX8) - AMD Ryzen 7 7745HX, RTX 4070 (48 hónap garancia!)

- AKCIÓ! MSI B450 R5 5500 16GB DDR4 512GB SSD RTX 2070 8GB GDDR6 Rampage Shiva Zalman 500W

- ÁRGARANCIA!Épített KomPhone Ryzen 7 5700X 16/32/64GB RAM RTX 3060 12GB GAMER PC termékbeszámítással

- Gamer PC új 12 hónap jótállás/Áfá-s számlával!

Állásajánlatok

Cég: Laptopszaki Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) ), de kétszeres méretű LLM-ekkel tudok dolgozni, az egy 2080Ti-nél valamivel( még nem tudni mennyivel

), de kétszeres méretű LLM-ekkel tudok dolgozni, az egy 2080Ti-nél valamivel( még nem tudni mennyivel  ) lassabban?

) lassabban? ), ha a Windows-os Linux-on(WSL 1-2 ?) is futna ez az exo...! LM Studio-t is kérek...

), ha a Windows-os Linux-on(WSL 1-2 ?) is futna ez az exo...! LM Studio-t is kérek...

Ha nem bízol benne meg tudod nézni miből dolgozott.

Ha nem bízol benne meg tudod nézni miből dolgozott. /

/