-

IT café

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Petykemano

veterán

Itt van egy csinos kis táblázat az infinity cache 2 kapacitás és felbontás szerinti hitrate értékeiről. [link]

Nem tudom, hogy az értékek honnan valók

Mindenesetre úgy tűnik, hogy 96MB felett 1080p esetén valóban már csak nagyon vékony a többlet-kapacitás hasznosága.

Nade 1440p-ben és főleg 4K-ben még a 128MB és 96MB között is még érezhető különbség lenne. És ha abból indulunk ki, hogy a IC duplázódott volna 192MB-ra, akkor 1440p-ben és főleg 4K-ban már elég vastag hitrate növekedést eredményezett volna.

Kár, hogy végül a 3D-stackelt verzió lekerült a roadmapről

Vagyis pontosabban:

Vajon végül miért kerülhetett le a 3D stackelt verzió roadmapről, ahogy Abu mondta?Szerintem lehet, hogy ez a táblázat a választ is megadja.

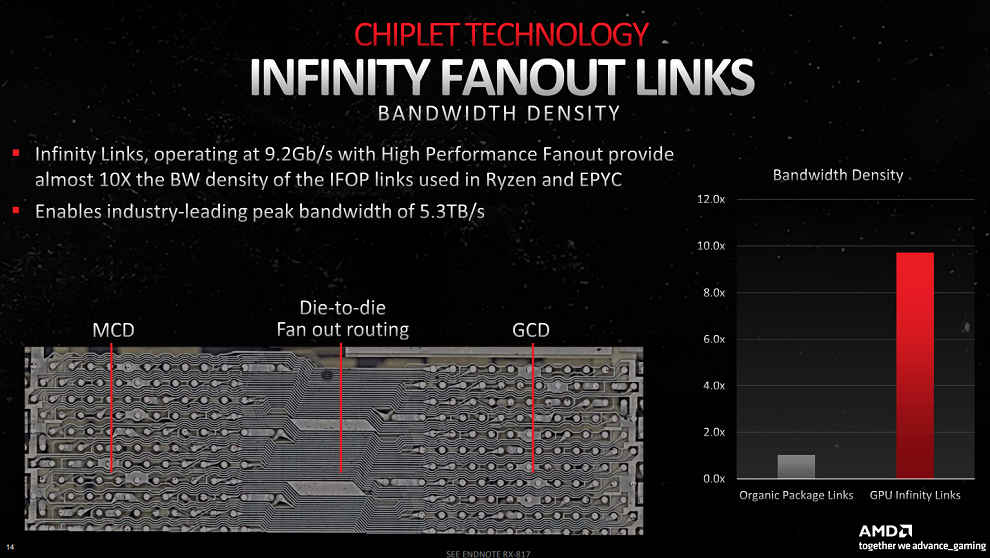

Röviden: A chiplet csatllakozás sávszélesség limitáló tényezőjő állhat a háttérbenA táblázatban láhatunk az oszlopoknál egy-egy teoretikus maximum sávszélességet és alatt a felbontásonként, hogy az adott felbontás hitrate-je mellett mennyi a hasznos(uló) sávszélesség.

Több cache esetén elvileg lehetne magasabb az elméleti maximális sávszélesség és magasabb hitrate esetén a ténylegesen hasznosuló is.

De úgy vélem, hogy ennek tényleges megvalósíthatóságának az infinity fanout link-nek nevezett chiplet-csatlakoztatási technika szab gátat.

A vonatkozó slide-on azt említik, hogy, hogy a linkek egyenként 9.2Gb/s (1.15GB/S) sávszélességet adnak. És hogy összességében ez így 5.3TB/s effektív sávszélességet biztosít. Tehát ez nem, vagy nem csak az infinity cache maximális sávszélsssége, hanem a chiplet interconnecté is egyben.

Ami azt jelenti, hogy még 128MB-ra esetleg érdemes lehetett volna emelni, de afölött már nem nagyon lenne érezhető a cache jótékony hatása, mert egységnyi idő alatt úgyse tudna több adat bejutni az MCD-k irányából.Abu, mi a véleményed?

Milyen irányban tudhat az AMD tovább fejlődni? Ez a 9.2gbps/lane elég limitálónak tűnik. Lehetséges, hogy újabb RDNA3 designokban már más linket használnak majd?

Találgatunk, aztán majd úgyis kiderül..

-

Yutani

nagyúr

válasz

S_x96x_S

#59692

üzenetére

S_x96x_S

#59692

üzenetére

A Fortnite pont egy olyan játék, amelynek látványához közel semmit nem ad hozzá az RT, mert a grafika eleve faék egyszerűségű, valalmitn mivel kompetitív FPS, nem igazán számít, hogy mennyire valósághű az árnyék és a tükröződés. Tehát számomra az AMD itt mutatott teljesítménye nem győzött meg.

#tarcsad

-

Abu85

HÁZIGAZDA

A Fortnite esetében azért erős raytracing mellett a Radeon, mert az Epic egy skálázható kétszintű gyorsítótárazási rendszert használ az UE5-ben, ami miatt maguk a hardveres RT effektek is nagyon gyorsak lesznek. Ennek az egésznek az a lényege, hogy a korábbi RTGI megoldásokkal ellentétben az RT Lumen pipeline úgy van kialakítva, hogy nem csak screen space alapon lesz jó a gyorsítórazás, hanem scene space alapon is, mert különböző trükkökkel és hash mappekkel próbálja őrizni a rendszer a másodlagos sugarak integritását.

Az előnye ennek egyértelmű, lényegégen minden hardveren gyorsabb lesz az RT effekt, mert okosabban kezeli az egész algoritmus az adatokat, kvázi sokkal többet lesz cache-hit, mint a hagyományos módszerrel. Az meg evidens, hogy minél kevesebbszer kell az adatért a memóriáig menni, annál jobb a sebességnek. Na most az Epic korábbi adatai szerint azért lett a Radeon gyorsabb az UE5-ben raytracingben, mert az új rendszerükkel már a caching a döntő tényező, és ez a része a kódnak sokkal jobban fekszik a Radeonnak, mert van külön L0 és L1 cache a hardverben, míg a GeForce a közös LDS+L1 miatt leginkább az L2-re alapoz, ami viszont nagyon szemetelhető a különálló L0 és L1-gyel ellentétben. Tehát az Epic kódja kevesebbszer megy adatért a memóriáig egy Radeonon, és ez az, ami az RT effekt sebességét az AMD-felé billenti összességében.

Korábban is írtam, hogy az RT-nek teljesítménye a hardverekben nem univerzális. Simán lehet olyan, hogy a Radeonnak jobban fekszik egy másféle algoritmus, és hirtelen gyorsabb lesz a GeForce-oknál. De összességében ez mindenkinek javulás, amit az Epic csinált, mert GeForce-on is gyorsult az RT a rendszerük hatására, csak Radeonon annyival többet, hogy az AMD RT dizájnja az NV RT dizájnjánál hatékonyabban működik az Epic algoritmusában.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

PuMbA

titán

Van valami új infód az NVIDIA RTXDI és RTXGI-ról? Mostanában kezdik meg útjukat, az előbbi fog hamarosan debütálni a Cyberpunk 2077-ben. Ugye nem UE5.1, hanem egyedi motorokba szánják, tehát olyasmi, mint amit az AMD barkácsol az új Snowdropba az Uborkasoft-tal. AMD-ken is szintén erős gyorsulást ígér, ugyanis a jelenlegi maximum 15 helyett több ezer RT-s fény lehet, ami árnyékot is vet. Az NVIDIA-nál is találtak valami nagyon okosat?

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

A Portal RTX-ben van már az RTXGI, és rém szar a működése. [link] - itt volt róla korábban adat. Igazából nem is az RT limitálja ezeknek az effekteknek a sebességét a mai VGA-kon, mert alig terheli az RT hardvereket. A gondot a shaderek okozzák, amelyek valamiért úgy vannak megírva, hogy a hardvereket LDS- és regiszterlimitbe rakják, így ne tudjanak állandóan működni. Tehát alapvetően ha elkezd futni a shader egy GPU-n, mindegy, hogy Radeon vagy GeForce, akkor állandóan adatra fog várni a multiprocesszor, mert nem lesz elég konkurens szálcsoport, hogy az adatbetöltést átlapolja más munkával.

A Cyberpunk 2077 is azért fut szarul a mai hardvereken magas RT-vel, mert maga a kód szándékosan úgy van megírva, hogy ne tudjanak a hardverek állandóan működni, hanem folyamatosan adatra várjanak, és eközben csak malmozni tudnak, mert adat nélkül nincs munkavégzés.Az Ubisofttal az AMD mást barkácsol. Ott maga az API cseréje a lényeg, hogy az API limitációkat kiüssék. Ez például teljesen más, mint a Portal RTX, mert itt a gyorsításon van a hangsúly. A Portal RTX-nél a kód arra van kihegyezve, hogy ne tudjon semmin se gyorsan futni, mert le van terhelve annyira a statikus erőforrás-allokáció, hogy ne tudjon aktívan dolgozni maga a GPU az adatra való várakozás miatt.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Az RTXDI egy másik rendszer. Az nem RTXGI, hanem pont az a lényege, hogy egy fake hatást generáljon, de dolgozhat sok területfénnyel. Viszont ezt már tudjuk sok-sok éve, lásd raszterizáció. Az RTXDI csak annyit csinál, hogy ezeknek a fake rendszereknek a felépítését egyszerűsíti. Tehát az RTXDI nem azért gyorsabb az RTXGI-nál, mert valami nagy áttörés, hanem azért, mert sokkal szarabb minőséget számol.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

T.Peter

őstag

válasz

Alogonomus

#59698

üzenetére

Alogonomus

#59698

üzenetére

RTX 3080 vs 7900 XTX vs RTX 4080: Don't get ripped off (RT on/off, Unreal Engine 5, 4K, 1440p) - YouTube

Szerintem hasznosabb megnezni tobb videot yt-on, mint ilyen szoveges tesztekbol informalodni, tekintve hogy nem latod mit es hogyan mertek. A videokban legalabb latod. -

PuMbA

titán

"Tehát az RTXDI nem azért gyorsabb az RTXGI-nál, mert valami nagy áttörés, hanem azért, mert sokkal szarabb minőséget számol."

Jah, látom, hogy amikor bekapcsolja, akkor zajos lesz a fény és kell denoiser. A denoisert erősen fejleszti az NVIDIA, úgy látom ebben látja a megoldást.

-

Abu85

HÁZIGAZDA

A denoiser az nem megoldás, hanem egy szükségszerű tényező, mert ha nincs elég mintavétel, akkor zajos lesz az eredmény.

Ilyet egyébként alkalmaznak raszterizáláshoz is. Ott is lehetnek olyan effektek, amelyek denoisert igényelnek. Például SSSR.

Ilyet egyébként alkalmaznak raszterizáláshoz is. Ott is lehetnek olyan effektek, amelyek denoisert igényelnek. Például SSSR.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Alogonomus

őstag

válasz

T.Peter

#59708

üzenetére

T.Peter

#59708

üzenetére

A linkelt videód ezen pontjánál válik nyilvánvalóvá, hogy sokkal kevésbé professzionális a tesztelő, mint a HU teszteket készítő Steven. Pont te mutattál rá helyesen, hogy a hw/sw RT együtt nem futhat. Más eljárással működnek. A tesztelő pedig simán kijelenti, hogy "akkor kikapcsolom a hw raytracinget, de továbbra is használja a Lumen-t" A kettő együtt nem használható.

Az édes-selymes tanáros hangját persze szívesebben hallgatja az ember, mint Steven karakán férfias hangját, de szakmailag sokkal képzetlenebb. -

Yany

addikt

Na igen. Pedig azt gondolom, hogy nem szükségszerűen "inferior" a termékük, ez a szomorú. Technikailag tök rendben van szvsz, a qc hangsúly és az erőforrások általában rossz helyre mennek ott, gyanítom más piacokra koncentrálás okán, csak hát a hírt a gamerek viszik, ők a hangosak, ha itt nem teljesít jól, a többi piacon is hasonlóan romlik a megítélés. Na én egy ilyen "terméket" várok AMD-től, ahol ezt felismerve tesznek bele apait, anyait.

Kicsit olyan a szitu, mint a boxban: látod a két félen, hogy melyik a domináns és melyik a túlélésre játszó, már az arckifejezésekből. Elég a nyilatkozatokat, a fiaskók miatti magyarázkodásokat és a "nagy" bejelentéseket figyelni, hogy lássuk ezt az arckifejezést. A szájuk hazudik, de az arcuk őszinte.

Építs kötélhidat - https://u3d.as/3078

-

fLeSs

nagyúr

A hangsúly nem az inferior producton van, hanem a "loss of consumer credibility"-n és a brand damage-en és hogy mit lehet ezzel kezdeni.

Az átnevezést/imageváltást lehet viccnek is felfogni, de talán meg is fontolhatnák."I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

Petykemano

veterán

Szerintem a "loss of consumer credibility"-n és a "brand damage" nem csak azon múlik, hogy a cég mit csinál. Hanem azon, hogy azt hányan és milyen módon interpretálják. Az Nvidia miért ússza meg a "brand damage" és "loss of credibility" nélkül azt, hogy a bemutatóin rendre számottevően nagyobb számokkal ámítja a közönséget? (pl: 3 x 3090) és persze ebből lehet, hogy mém lesz, de ennek ellenére a Nvidia nem néz szembe olyan számonkéréssekkel, mint amikkel az AMD.

KÍsértetiesen hasonlít a magyar politikai közéletre, amelyben az jelenti ma a pártatlanságot, el nem kötelezettséget, mérvadó középen állást ha valaki cinikusan röhögcsél az ellenzék alkalmatlanságán, vagy legjobb esetben is korholja, hogy miért nem szedik már össze magukat, de ha kormány dolgainak számonkéréséről van szó, akkor ¯\_(ツ)_/¯. Persze bármit el lehet mondani, csak minek? És éppen ezért változást is a másik - alkalmatlan oldalon kéri számon.

(Elnézést a kis kitekintőért, de fontos alapozója a következő gondolatnak)Ennek megfelelően egy átnevezésnek imázsváltásnak pont annyi haszna/eredménye lenne, mint egy új politikai párt indításának.

Egyébként a kis történetből a nekem az jött le, hogy papírbolt és a szemközti más márkanév alatt nyitott, de egy tulajdonoshoz tartozó konkurencia az NVidia és AMD analógiája.

[ Szerkesztve ]

Találgatunk, aztán majd úgyis kiderül..

-

T.Peter

őstag

válasz

Alogonomus

#59713

üzenetére

Alogonomus

#59713

üzenetére

"A tesztelő pedig simán kijelenti, hogy "akkor kikapcsolom a hw raytracinget, de továbbra is használja a Lumen-t" A kettő együtt nem használható."

Eddig is csak az ertekekre figyeltem, azt nem szoktam figyelni hogy miket mondanak, nyilvanvalo okok miatt. A kijelentese amugy helyes.Radiance Caching for Real-Time Global Illumination

Tekerj a lap aljara, ott lesz a pptxLumen: Real-time Global Illumination in Unreal Engine 5

26MB PDFEzekre kene hagyatkozni.

A Lumen a technologia marketing neve. A pipeline sw rt-t es hw rt-t is hasznalhat, de attol meg ugyanugy Lumen marad. Nincs masik rendszer. Ha a default sw rt fut, akkor sdf-re szamol utkozest, ha a hw rt akkor haromszogre. A pdf-ben benne van minden. -

fLeSs

nagyúr

válasz

Petykemano

#59716

üzenetére

Petykemano

#59716

üzenetére

A botrányok vagy rossz döntések amíg rövid életűek vagy csak ritkán, egyszer-egyszer fordulnak elő addig csekély hatással vannak egy márka vonzerejére, mert a fogyasztók általában megbocsátják és/vagy elfelejtik az ilyen félrelépéseket. Ez a helyzet az NV-vel. A kutyát nem érdekli, hogy a slide-okon a 4070 Ti 3x gyorsabb mint a 3090 Ti, mert ezt kb. senki sem látta és/vagy nem veszi komolyan és/vagy elfelejti 1 hét múlva és/vagy nincs hatással magára a termékre.

Amikor viszont egy márka (brand) következetesen nem képes teljesíteni az általa megfogalmazott ígéreteket olyankor vonzereje csökken, ilyenkor a márkanév (brand) megtépázásáról vagyis sérüléséről beszélhetünk az idő előrehaladtával. A márka károsodhat ha 1. rossz az ügyfélszolgálat 2. a megjelent termékek nem felelnek meg a márka imázsának, nem teljesítik az ígéreteket (Polaris fogyasztás? Poor Volta vs Vega? RX 5700 "Jebaited"? idióta termékelnevezések/számozások/átnevezések) 3. a gyártó weboldala rossz élményt nyújt 4. az ügyfelek véleménye rossz a termékekről (asszem erről sem kell mesélni - mindegy hogy igaz vagy sem, ha ez a többség véleménye akkor gáz van)

Hosszú távon ez a márkahű vásárlók csökkenéséhez vezethet illetve a legrosszabb esetben a piaci részesedés csökkenését vonja maga után.

Tehát pl. nem az RDNA2 kártyákkal van a gond, nem azért nem veszik őket mert rosszak lennének, hanem azzal van gond ami az RDNA2 előtt volt.Ezt most egy tervezett blogbejegyzésemből szedtem ki.

Sorry ha offtopic.[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

Petykemano

veterán

De mi az ok és mi az okozat?

A botrányok azért hosszú életűek az AMD esetében, mert hibáztatjuk őket értük, míg az Nvidiát nem. De valóban annyival gyakrabb és annyival jelentősebb az AMD oldalon elkövetett hiba, mint az Nvidia oldalon? Vagy azért emlékszünk ezekre hosszú életű és jelentős botrányokként, mert örökös felemlegetésükkel tesszük örökkön örökké megbocsáthatatlanná. Nem magyaráztad meg, hogy az Nvidiára ezek az ügyek miért nem égnek rá (a tápcsatlakozó esetén szó szerint) megbocsáthatatlan botrányokként.

Persze én azt elismerem, hogy az underpromise-overdeliver a jól működő, jó benyomást keltő hozzáállás.

De miért van az, hogy az Nvidia következetesen, több generáció óta másfél-kétszer nagyobb előrelépést hazudik az anyagaiban, mint amit aztán a valóságban kimérnek és ebből nincs botrány. De ha az AMD-nél 15%-ponttal lemaradnak az ígértettől és a következő 5-10 évben mindenki emlékezni fog arra, hogy az AMD elqrta az RDNA3 piacravitelét.

5 év múlva szerinted ki fog emlékezni (mármint úgy, hogy felemlegeti, mint érvet) még az NVidia tápcsatlakozós problémára? Nagyjából egy-két elvetemült AMD fan. De még 5 év múlva is az AMD orra alá lesz dörgölve a Polaris PCie áramfelvétele."kutyát nem érdekli, hogy a slide-okon"

De Miért?

És arra miért van pattanásig kifeszülve mindenki, hogy az AMD slide-jain mi van?Természetesen abban igazad van, hogy a márka megítéléséhez az emlékezetben élő botrányok hozzájárulnak. De szerintem nincs nagyságrendi különbség az AMD és az Nvidia hibáiban, csúsztatásaiban, driveres problémáiban. Időről időre itt is, ott is felbukkan egy kummantó slide, egy bugos driver, egy hardverhiba. És az emlékezetben mégis az marad meg, hogy az AMD folyamatosan bénázik, az Nvidia meg király.

Találgatunk, aztán majd úgyis kiderül..

-

fLeSs

nagyúr

válasz

Petykemano

#59720

üzenetére

Petykemano

#59720

üzenetére

Látom téged nagyon érdekelnek ezek a slide-ok.

Ez csak az enthusiast közösséget izgatja, az átlag vásárló nem is hallott ezekről a slide-okról, nem néz ilyen VGA bejelentő eseményeket.

De ha már slide-ok: az AMD következetesen +54% perf/wattról és "up to" 50-70%-ról beszélt több slide-on keresztül, a bejelentés nagy része erről szólt, míg az NV-ánál ez csak egy slide volt ami kb. 10 mp-ig volt a képernyőn.

A tápcsatlakozó problémáról kiderült, hogy user error (nemtom, hogy az-e, de ez a hivatalos magyarázat), szóval nem az NV sara.

Az AMD-t azért is övezi nagyobb figyelem az enthusiast körökben, mert ezek az emberek az AMD-től várják a piaci tendenciák helyrebillenését mivel két monopólium ellen harcolnak. Az Average Joek 90%-a viszont nem is hallott még az AMD-ről, de az Intelről és az Nvidiáról (valószínűleg) igen.

Nézd. Az AMD sokak szemében ez: forró, hangos, bugos driver, lassú RT, nem támogatja az nvenc-et, nem jó streamingre, olcsó (pejoratív értelemben), stb. Van ami igaz, van ami régről maradt rá a márkára.

Ez a vita abból indult ki, hogy ezeket a problémákat vhogy le kéne vetkőzniük (akár átnevezéssel). Azt nemtom megmondani, hogy mi miért van többszáz millió ember fejében.

[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

paprobert

senior tag

válasz

Petykemano

#59720

üzenetére

Petykemano

#59720

üzenetére

Én pont ugyanannyira vagyok mérges mindkét cégre, ha ez megnyugtat.

Az NV elérte, hogy teljes mértékben át lehet ugrani a teljesítményre vonatkozó részt a prezentációjukban.

De igazából az árra vonatkozót is, mert az sem a valóságról beszél.

Az elvárásokbeli különbségben szerintem az van, hogy az AMD-t körüllengi a "na most majd megmutatjuk ezeknek" étosz. Most jön a megváltás. Most fordul a 90-10. Gyakorlatilag a reddit hangulata.

A CES előadáson a két nagy ígéret is ezt támasztotta volna alá, és amikor kiderül, hogy lufi az egész, az visszafele sül el. Se teljesítmény, se megváltás.Ezzel szemben, ha a piacvezető lódít a +200%-ról, miközben +40-60% a vége, az az emberek szemében rendben van, mert van magas teljesítmény hazugság nélkül is.

[ Szerkesztve ]

640 KB mindenre elég. - Steve Jobs

-

Petykemano

veterán

Mégse a drivertől repedtek a lapkák... [link]

"The long story short is that it was not the driver after all. As it turns out, the graphics cards that were sent over to KrisFix also had one other thing in common that was previously not mentioned. Many of these cards were sold by the same seller within two weeks, with a strong suspicion that these cards were previously used for cryptomining."

Úgy tűnik, az AMD botrányt eredményező súlyos hibát véthetett a kártyák másodkezi értékesítési folyamatában. A felelősségük elvitathatatlan. Mindenki ódzkodjon az használt AMD kártyáktól! /sarcasm/Találgatunk, aztán majd úgyis kiderül..

-

válasz

Petykemano

#59723

üzenetére

Petykemano

#59723

üzenetére

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

HSM

félisten

válasz

S_x96x_S

#59699

üzenetére

S_x96x_S

#59699

üzenetére

Ajánlások... Azért az is megérne egy külön elmélkedést, vajon mennyire volt ez jó a szoftverfejlesztőknek/piacnak, hogy az egyik, igen meghatározó gyártó a saját ajánlásaival gyakorlatilag az ellentétét ajánlotta, mint amit a szabvány, és a platform tulajdonosa.

#59720 Petykemano : Szerintem itt a karizma is szerepet játszik. A zöldeket és víziójukat kitűnően el tudja adni a bőrkabátos. A piros oldalon nincs egy ilyen stabil, évtizedes múltú, karizmatikus vezető, jönnek mennek az emberek. Lásd, az almások sem buktak bele az iPhone4 antennás történetébe [link] ...

"... az emlékezetben mégis az marad meg, hogy az AMD folyamatosan bénázik, az Nvidia meg király"

Egyébként ebben benne lehet az is, hogy pl. a "poor volta" meg hasonlók után nem úgy alakultak a dolgok... Ehhez képest a zöldek, ha úgy adódott, inkább megépítettek valami irdatlan nagy és drága csúcs-GPU-t, mindegy hogyan, csak az legyen az aktuális benchek tetején... Ez pedig erősen kompetenciát sugall. Ehhez képest a pirosaknál néha komplett termékkategóriák estek ki...#59721 fLeSs : "kiderült, hogy user error"

A tökéletlen csatlakoztatás user error. Az viszont, hogy miért csak dísznek vannak a kommunikációs erek, és miért ilyen "félkész" állapotban lett ez az újfajta csatlakozási fajta kiadva, na az már nem annyira."Azt nemtom megmondani, hogy mi miért van többszáz millió ember fejében."

Egy ideig egyébként tényleg volt valóságalapja, hogy rövidebb pórázon voltak tartva a gyártópartnereik. A pirosaknál jobban meg kellett válogatni, ha jó kártyát akartál, nagyobb szórás volt. De ennek már elég sok éve, RDNA előtti időkben volt ez igaz... Ehhez képest ma ugyanúgy vannak gondok zöld oldalon is, pl. [link] , de a 3090-eken a VRAM hűtés sem volt sok példányon kielégítő, tele a net leírásokkal, hogyan lehet az elspórolt, silány gyári hőpadokat jobbakra cserélni, mindezt egy 1500$-os MSRP-jű terméken... -

Yany

addikt

válasz

Petykemano

#59716

üzenetére

Petykemano

#59716

üzenetére

Szerintem a kulcs az, hogy mindegyik hazudik, mint a vízfolyás, csak az NVIDIA termékei egyszerűen jobbak. Vagy ebben, vagy abban, vagy többmindenben, de drágább létük ellenére is egyszerűen a nagy többség tényleg jobban jár velük, ennyi. Itt nem a gyártók által elmondottak alapján mérkőzik meg a két termék, az kb. a retail debüt pillanatában szerte is foszlik és van nekünk GN és HUB és LTT (bár én ez utóbbit nem csipázom) akik megmutatják, hogy mi a tényleges szitu. És hangsúlyozom, nem az FPS értékekről beszélünk, mert ott hozza a kötelezőt az AMD is. De az a storynak csak egy pici része. És ez a story teljes terjedelmében szivárog szépen be az emberek tudatába, szó sincs vakon hívőségről. Legalábbis nem ott kell keresni a probléma gyökereit.

[ Szerkesztve ]

Építs kötélhidat - https://u3d.as/3078

-

mozesapo

tag

válasz

Petykemano

#59723

üzenetére

Petykemano

#59723

üzenetére

"

Úgy tűnik, az AMD botrányt eredményező súlyos hibát véthetett a kártyák másodkezi értékesítési folyamatában."És mi köze ehhez az AMD-nek? Semmi. Valaki felvásárolta bányászoktól és eladta. Sehol nem írják a cikkben, hogy az AMD-nek ehhez bármi köze lenne.

-

Petykemano

veterán

válasz

mozesapo

#59727

üzenetére

mozesapo

#59727

üzenetére

Semmi.

Szarkasztikusan fogalmaztam meg, hogy valószínűleg annak ellenére, hogy ez most kiderült, ez is rá fog égni az AMD-re, a second hand market terén.bányászatra használt AMD kártya másodkézből vásárolva tönkremegy => AMD szar minőség

bányászatra használt Nvidia kárty másodkézből vásárolva tönkremegy => Ja hát bányásztól vásárolni kockázatos.Találgatunk, aztán majd úgyis kiderül..

-

fLeSs

nagyúr

Az a gond ezekkel a példákkal, hogy ez a tápcsatis mizéria és a kondenzátoros mizéria is az AIB-ok sara igazából. Ha veszek egy ilyen kártyát és elolvad a tápcsati vagy kinyiffan egy cap akkor nem az NV-hez megyek (nem is tudnék), hanem pl. az MSI-hez. Végeredményben ezek a cégek tervezték a kártyát, ők rakták össze ezekkel az alkatrészekkel. Aztán legközelebb nem MSI-t veszek, hanem Asus-t (csak példák). Ez nem az NV-n csapódik le, szóval sztem nem jó példák.

Az utolsó ilyen dolog ami az NV-n csapódott le (és emlékszem rá) az a 3.5 GB-os GTX 970 volt. Az az NV sara volt, lett belőle pereskedés, az NV fizetett vmit aztán ennyi (btw a Bulldozerrel volt hasonló az AMD oldalán is).

Karizma: ennek lehet némi szerepe, de sztem túl van gondolva. Az NV-t ismerik sokan, de hogy ki vezeti az sztem egy nagy kérdőjel a legtöbb ember számára és nem is érdekli a vásárlókat. Az viszont tagadhatatlan, hogy az AMD marketingje pocsék régóta és sztem Lisa Su sem a legjobb választás a színpadra de nyilván sok AMD-snek más a véleménye (csak én nem AMD-s szemmel nézem ezeket a bemutatókat).

Az AMD mindig a kártyák tulajdonságait hangsúlyozza ki, az NV meg azt, hogy mi mindenre jó, mi mindent lehet csinálni a kártyájukkal. Van egyfajta üzenetük. Leegyszerűsítve Huang asszondja (hangsúlyosan), hogy nézd, DLSS3, dupla fps. AMD meg asszondja (hangsúlyosan), hogy chiplet és displayport 2.1 meg 60 teraflops. Melyik vonzóbb?

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

HSM

félisten

válasz

Petykemano

#59723

üzenetére

Petykemano

#59723

üzenetére

A legérdekesebb, hogy szerinte nem is a bányászat volt a gond, hanem a szakszerűtlen tárolás.

#59729 fLeSs : AMD-nél is a hangos/meleg/instabil tapasztalatok is gyakran rossz minőségű AIB termékekből fakadtak. Érdekes mód AMD-nél nem az jött magyarázatnak, hogy hangos/meleg/silány ez az XYZ kártya, meg blackscreenel az XYZ kártya, hanem így AMD meg úgy. Szerencsére az RDNA2-nél már egész jó modellek jöttek az AIB-októl is, és a referencia is végre kitűnően sikerült.

"Melyik vonzóbb?"

Értem a gondolatodat. Ugyanakkor számomra elég gáz a DLSS meg a túltolt AI téma. A DLSS 1-2-nél simán csak gyomor kellett a homályos képhez, a DLSS3 meg számomra egy trükk a számokkal, kb mint az AFR CF/SLI volt annak idején. Ezzel szemben én igen érdekesnek tartom pl. az RDNA3 belső fejlesztéseit, amit szépen be is mutattak a diasorban. Én szívesebben vásárolok olyan terméket, ahol transzparensebb a gyártó, abban, hogy mit ad el, mint amikor magabiztosan a főnök a kamerába néz, hogy "Ai van benne, hidd el, nagyon jó lesz".

Számomra az is vonzó egyébként, hogy nyílt technológiákat fejlesztenek, pl. GPUOpen, így pl. az RTX 3060-amon össze tudtam direkten hasonlítani az FSR2.1-et a DLSS-el, hiszen az FSR2.1 gyártófüggetlen/nyílt, míg az RX 6800XT-men sajnos nem tudom bekapcsolni a DLSS-t egy árva teszt erejéig sem, mert zárt technológia... Mondjuk túlzotan nem zavar, számomra egyik sem opció, nem tetszik a képminőségük, inkább játszom kisebb felbontásban, vagy kevesebb FPS-el.

[ Szerkesztve ]

-

fLeSs

nagyúr

A hangos/melegre: a tesztelők az elmúlt évtizedben szinte mindig MBA (made by AMD) kártyákat kapnak tesztelésre, és az AMD mindig blower hűtővel adta a kártyáit (gondolom azért, hogy olcsóbb legyen gyártani), ráadásul többségük sokat fogyasztott. Nagy fogyasztás + sz@r hűtő = probléma. HD 7970, R9 290X/390X, Vega, Radeon VII, RX 5700? Mind meleg és hangos, a VII még 3 ventivel is. A Fury X-re raktak vízhűtést aminek meg a pumpájával volt gond

(meg mással is, kevés memória többet között)

(meg mással is, kevés memória többet között)

Az első benyomás a leglényegesebb és az AMD ezt gyakorlatilag mindig elb@ssza. Most is sikerült nekik.

Most is sikerült nekik.

Az RDNA2 volt az első gen normális hűtéssel.

Nézd meg mit csinált az NV. Készítettek 300+ wattos kártyákat (3080 és efelettiek) és hozzátervezték a hűtést, batárnagyok lettek, de legalább nem hangosak és hűvösek (mégha a hő akkor is leadódik és a szoba bemelegszik tőle ), mert ez nagy mínuszpont a teztelőknél.

), mert ez nagy mínuszpont a teztelőknél.

Instabil alatt nemtom mire gondolsz, a kártyáknak nem kéne instabilnak lenniük mert akkor az azt jelenti, hogy hibás, és cserélni kell. Inkább a driverekkel volt/(van?) probléma.

Az enthusiast körök egy része nem komálja a DLSS3-at, de egy átlagvásárlónak komoly hívószó, nem tudja, hogy csak bizonyos esetekben érdemes használni és hogy emeli a latencyt.

Az opensource dolgokkal az a baj, hogy 1. az AMD-nek nem lesz belőle pénze 2. átlag vásárló ha ilyet lát (már ha egyáltalán tud ezekről), akkor kétségbeesettséget sejt emögött és elkönyveli a márkát olcsó alternatívaként. És hát valljuk be, van benne némi igazság.A videóra: én azt nem értem, hogy ezek hogy voltak bányászkártyák ha vadonatúj állapotban kapta őket kézhez, nem voltak szétszedve. Slaggal sem lehet úgy lemosni egy kártyát, hogy ne maradjon benne valamennyi kosz/pormaradvány, csak ha szétszedjük a kártyát.

[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

fLeSs

nagyúr

válasz

#32839680

#59732

üzenetére

#32839680

#59732

üzenetére

Ezekről is csak mi tudunk, de nem az aki az Alzában veszi a komplett PC-t, vagy a Delltől rendeli.

Ráadásul ha eleve NV kártyád van (és tudsz ezekről) akkor nem zavar a dolog.

Szóval emiatt nem kell hogy csökkenjen a részesedésük.[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

Abu85

HÁZIGAZDA

Az open source egy stratégia. Az NVIDIA is megy az open source felé, lásd Linux meghajtó megnyitása, mert rájöttek, hogy bizonyos piacokon fel sem kerültek a potenciálisan megvásárolható hardverekhez, mert nem volt open source stratégiája. És ezek a piacon már dollármilliárdos szintre nőttek. Ez géming szempontból is hasznos, mert a Steam Deck az open source miatt létezik.

Emellett nagyon sok open source Vulkan/D3D12 projektje van az AMD-nek, amik nélkül egy csomó játék nem is létezne úgy, ahogy létezik. Például ma már tipikus, hogy a top stúdiók sem írnak saját memóriamenedzsmentet, hanem letöltik ezeket: [link] , [link] - utólag lehet módosítani a forráskódot. Az előző évben az összes Ubisoft és Activision cím ezekkel jött, és idén már egy csomó EA cím is átáll erre a fejlesztési modellre. Például a Star Wars Jedi Survivor. Szimplán sokkal olcsóbb az AMD által megírt kész kódot felhasználni és finomhangolni, mint írni a nulláról egy sajátot. Ráadásul új dolog, hogy az újabb VMA és D3D12MA verziókba már az Intel is optimalizál, vannak kódrészek, amiket a saját Arc hardvereik miatt adtak hozzá. Rájöttek, hogy nem tudják lebeszélni róla a fejlesztőket, így beálltak ők is fejleszteni a kódot. Ez egy stratégia.És nem csak a memóriamenedzsmentet egyszerűsítik, hanem az egész Vulkan és DirectX 12 használhatóságát, ugyanis van egy új RPS SDK-juk. [link] Ennek tipikusan az a célja, hogy ha egy indie nem akart explicit API-ra váltani, mert túl bonyolultnak tartotta, akkor használjon RPS SDK-t, és úgy használhat explicit API-t, miközben az alkalmazásának bonyolultsága nem lesz nagyobb a DirectX 11-nél.

A képen látható is, hogy a fejlesztőnek nem kell azokat a sárga bonyolult dolgokat megírni, egyszerűen az RPS SDK megcsinálja helyette automatikusan. Ráadásul nem is szarul, mert az AMD mérései szerint 58 explicit API-t használó játékból 54-nél gyorsabb volt az alap kódnál az RPS rendszer. Tehát még a top fejlesztők számára is elgondolkodtató a használata, mert nem kell másfél évet szenvedni az optimalizálással, megoldható két hét alatt az SDK implementálásával, és mindent automatikusan csinál az RPS. Azt persze hozzá kell tenni, hogy az RPS licenc az nem MIT, tehát ott azért vannak kérdőjelek, de majd kiderül, hogy a végleges verzió milyen licencet kap.A stratégia az egész mögött annyi, hogy ha valaki fejleszt egy D3D12/Vulkan játékot, akkor ne is írjon saját memória-menedzsmentet, erőforrás-kezelést, ütemezést a GPU munkafolyamatokra és az erőforrás-korlátozásra, hanem töltse le a VMA/D3D12MA és RPS kombót, oszt kész. Az AMD előre megírt, minden hardveren működő (NV-n és Intelen is), több tízezer sornyi, bármilyen motorba beilleszthető kódot ad, amit később lehet módosítgatni a nyílt forráskód miatt. Persze, ha valaki akar ezzel foglalkozni. És tekintve, hogy a VMA/D3D12MA mennyire bevált, az RPS is kb. arra számíthat, hogy menni fognak érte. És ugye az NV és az Intel is fejlesztheti, hiszen ott a forráskód a GitHub-on. Az Intel már fejleszti is a VMA/D3D12MA-t.

És ez a fajta stratégia nagyon bevált eddig, mert tök egyértelmű a fejlesztők felé az üzenet. Miért akarnál 30-40 ezer sornyi kódot megírni, amikor le is töltheted, és helyből gyorsabb lesz minden elérhető hardveren, mint amit írni tudnál másfél év alatt?

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

fLeSs

nagyúr

OK. Én bevallom, hogy ebből nem értettem sokat (az ilyen szoftverdolgokhoz hülye vagyok

pontosabban nincs tudásom róla, mert nem érdekel), de azért egy kérdésem lenne.

pontosabban nincs tudásom róla, mert nem érdekel), de azért egy kérdésem lenne.

Az AMD-nek ebből van pénze vagy nincs?[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

fLeSs

nagyúr

válasz

#32839680

#59737

üzenetére

#32839680

#59737

üzenetére

"Pont ez az előnye hogy a piac kisebb szegmensét uraló gyártó tudja alakítani a piacot. "

A piaci részesedési számok nem azt mutatják, hogy ők alakítják a piacot.

Láttam anno egy videót AdoredTV-től (gondolom ismerik itt páran), asszem 6 éve készült, amiben előrevetítette az AMD dominanciáját amiatt, hogy a konzolokban AMD chip van. 6 évvel később vagyunk és nem látni belőle semmit, szóval vagy vmit félreértek, vagy csak porhintés ez amiről beszéltek.[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

Abu85

HÁZIGAZDA

Ezzel az AMD leginkább azt tudja elérni, hogy azok a kódok, amelyeket a játékok alkalmaznak, jók lesznek Radeonon, mert ugye a saját maguk által megírt menedzsment kódokat használja a játék. Tehát például a day0 driver support is leegyszerűsödik, mert ugye nincs szükség külön profilra, ami ilyen-olyan dolgokat cserélne. Out-of-box működik az így megírt játék, anélkül, hogy egy fillért is költöttek volna rá a driver oldalán.

A driveres erőforrás elköltése egy sarkalatos pont, mert az AMD egy ideje azt csinálja, hogy évente legalább egy nagyobb frissítést hoznak új funkciókkal, és ahhoz egyébként kell ám a humánerőforrás, mert a Chill, a Boost (VRS), az Anti-Lag, stb. dolgokat nem a hangyák hordják bele a driverbe.

Tehát minél több erőforrást meg tudnak spórolni a teljesítménycentrikus kódokkal, és a hatékonyabb fejlesztési modellel, annál több újítást tudnak hozni a driverbe. Ez különösen fontos manapság, hogy hozzáférnek egy rakás Xilinx technológia forráskódjához, amelyből elkezdtek szelektálni, hogy mit portoljanak át PAL-ra és/vagy a Tensilica DSP-k IR-jére. A Content Adaptive Machine Learninggel kezdtek, de van még ott más is.

Tehát minél több erőforrást meg tudnak spórolni a teljesítménycentrikus kódokkal, és a hatékonyabb fejlesztési modellel, annál több újítást tudnak hozni a driverbe. Ez különösen fontos manapság, hogy hozzáférnek egy rakás Xilinx technológia forráskódjához, amelyből elkezdtek szelektálni, hogy mit portoljanak át PAL-ra és/vagy a Tensilica DSP-k IR-jére. A Content Adaptive Machine Learninggel kezdtek, de van még ott más is.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

fLeSs

nagyúr

OK, szóval pénzük nem lesz belőle és piaci részesedésük sem lesz belőle (az is pénznek számít).

De azt mondod, hogy a drivertéren járnak jól. Hát nem ezt látni. Miért látni még mindig annyi panaszt a drivereikre? Pont a driver az ami miatt sokan ódzkodnak az AMD-től. Mindenki csak ismételgeti azt amit vhol olvasott/hallott hónapokkal/évekkel ezelőtt? Vagy van benne vmi igazság? (nekem nincs bajom az RX 470-emmel de én már alig játszok)

de én már alig játszok)

Az AMD 2021 közepén $4 milliárdos részvényvisszavásárlásba kezdett mert "nem tudta mire költeni a pénzt". Sztem jobb helye is lehetett volna annak a pénznek.[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

válasz

#32839680

#59732

üzenetére

#32839680

#59732

üzenetére

Az a Gsync 1 FPS től működik a a mai napig amit egy szabvány sem tud vagy követ..Azaz nincs minimum limit .Amíg nem volt DLSS és társai ez elég jól jött és nagyon sok mindennel Az van, hogy Nvidia csinál valami ami drága de jó de természetesen az olcsóbb hasonló, még ha kicsit rosszabb mindig több követőt fog találni. Miután kiderült hogy a freesync ugye elérhető bagóért és milyen alacsony minőségi követelményekkel megkapták a gyártók nagyon sok hulladék monitorra rákerült a freesync plecsni míg egy drága gsync monitor a mai napig 4-5 év távlatából is élvonalban jár frissítés, válaszidő stb tekintetében....mint ahogy nagyon sok AMD támogatott játék papíron RT támogatott látványban zéró,de kíméli az erőforrást míg az Nvidia támogatott RT játékok zabálják az erőforrást ,de van pár játék ahol az RT már értelmet is nyer látványban.

Mondhatnám a hairworks vagy a TressFx példáját vagy említhetném a DLSS vs FSR -t s mert mind ezt az útvonalat követi, hogy eleinte le volt húzva Nvidia, mert hardverhez köt szoftveres újításokat aztán jön egy gyengébb minőségű de nyílt megoldás amit többségnek jó már de a Zöldeknek kompromisszumos néhol és jön a pálcatörés.értem én hogy Abu it az AMD ben csak pozitívumokat sugall és minden jó ami itt születik, míg az Nvidásba átjön benyögni annyit hogy 549$ lesz a kártya meg ennél szarabb lesz aztán elmegy de valójában az Nvidia rohadt jól tervez bármilyen gyártásra ha először is lépnek ki már átveszik a stafétár lásd 4 nm jó dolgokat hoz be, és magas szoftveres szolgáltatási csomagot nyújt professzionális , gamer vagy média szinten is amit nehéz utolérni.

[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

Yany

addikt

Amiről fLeSsen kívül még nem nagyon hallottam embert beszélni az pedig a hangoztatott perf/consumption faszaság, ami iszonyat blama, mert ezzel akartak NVIDIA-nál jobban virítani, mert tudták, hogy netto perfben csúnyán lemaradnak. De a legnagyobb pofon épp az lett, hogy ebben is csúnyán kikaptak (kivéve ph tesztekben

). Vagyis a bejelentéskori húzóérvben bukott hatalmasat. Ez pedig azért ciki, mert ebben a kérdésben régóta bőven lenne mit fejlődni. Amióta létezik Tegra, az NV nagyon tudja, hogy kell (legalábbis a konkurens termékekhez képest) hatékonyabb chipet letenni.

). Vagyis a bejelentéskori húzóérvben bukott hatalmasat. Ez pedig azért ciki, mert ebben a kérdésben régóta bőven lenne mit fejlődni. Amióta létezik Tegra, az NV nagyon tudja, hogy kell (legalábbis a konkurens termékekhez képest) hatékonyabb chipet letenni.Akárhogy csűrjük csavarjuk, mindig ott lyukadunk ki, hogy rengeteg dologban fejlődhetne az AMD a köv. generációkkal, de épp nem az fps a baj. Legalábbis nem önmagában.

[ Szerkesztve ]

Építs kötélhidat - https://u3d.as/3078

-

Pahli

tag

Vagy csak aránytalanul több a power user amd oldalon és jobbak a hibák megtalálásában.

-

Én is beszéltem erről.[link] Hát igen ciki volt meg a beígért előrelépés sem lett meg, meg az a 34 játék sem amire Abu hivatkozott hogy állítólag létezik de szupertitkos lista és nem adhatják ki. Tudod ezek a dolgok gázak mert legalább itt el kellene hangoznia annak hogy ez kamu volt, nem mosdatni őket .

Nvidinál sem volt fair a 4070 Ti 3x 3090 Ti dolog amiből nem láthattunk semmit meg nem is fogunk soha.

Ezek a chartok és bemutatók már amúgy ennyit is érnek

Nem is az baj, hogy fejlődniük kell, mert Nvidiának is kell az AMD hez több dologban például a nyílt licenszek támogatása, Linux, vagy említhetném a Vram mennyiséget ami botrányosan kevés ma már és alapjaiban korlátozza a kártyák használatát.

A gond az, amikor ennek az ellenkezője van belesúlykolva itt sok emberbe, és elhiszik hogy az Nvidia pénzzel hatalommal bíró cég, aki nem tud semmit, mindig lemaradásban vannak az AMD szemben és minden jó dolog csak is az AMD konyhájából jöhet ami majd hoz egy sokkal jobb dolgot, mint amit most látunk a másik oldalon, ami amúgy is szar és meg fog halni hamarosan... Ebben amúgy nem az olvasók a felelősek, elég visszaolvasni az elmúlt pár kommentet...[ Szerkesztve ]

"A számítógépek hasznavehetetlenek. Csak válaszokat tudnak adni." (Pablo Picasso) "Never underrate your Jensen." (kopite7kimi)

-

S_x96x_S

őstag

> OK, szóval pénzük nem lesz belőle

> és piaci részesedésük sem lesz belőle (az is pénznek számít).Ez mind-mind összefügg a Konzol Biznisszel ( "console SoCs" ) is

és ott sokat kaszál az AMD.

( jelenleg sokkal többet mint a "consumer GPUs"-on ! )A következő konzolgenerációra valószínüleg az Intel is rá-startol

( van gyára és most már ARC-os GPU-ja is )

és ha nem figyel az AMD, akkor az Intel viszi el a sajtot ..

És itt már minden apróság is számít ..

nem mindegy, hogy a nagyobb Game Engine-ek milyen alap-optimalizációval rendelkeznek.

És ha az AMD a szoftveres támogatással boldogabbá/hatékonyabbá tudja tenni a játékfejlesztőket, akkor ez a Microsoft-nál és a Sony -nál is jó pontnak számít.-------------

"It usually takes about four to five years to build an all-new CPU or GPU from scratch. So we seriously doubt that Microsoft and/or Sony ordered development of its next-generation console SoCs in 2019 or even 2020 without hearing feedback about their next generation hardware (PlayStation 5 and Xbox Series X|S) from game developers. Even if AMD is looking for an engineer to work on a console SoC now, that console SoC will hardly power a next-generation console but rather a mid-cycle update machine. Perhaps, Microsoft and/or Sony want to offer improved version(s) of their XBX and PS5 system(s) in circa 2024 ~ 2025 or just radically cut down their costs, which is why they need a new SoC. "

AMD's Console and GPU Team Hiring for Next-Generation SoCs

By Anton Shilov published May 13, 2022

Development of next-generation Xbox 5, PlayStation 6 console SoCs may be underway.

https://www.tomshardware.com/news/amd-console-gpu-team-hiring-verification-engineer-for-next-gen-socs> Az AMD 2021 közepén $4 milliárdos részvényvisszavásárlásba kezdett

> mert "nem tudta mire költeni a pénzt".

> Sztem jobb helye is lehetett volna annak a pénznek.az AMD-nek ( és minden publikus tőzsdei cégnek ) óvatosan kell ellensúlyozni

a hosszú távú technikai fejlesztések

és a tőzsdei részvény árfolyamok között ( ~ tulajdonosi értékteremtés )bármelyiket is elhanyagolja .. megszívja ...

És az AMD-nek is meg kell tartania a dolgozóit és a fejlesztőit és a vezetőket ...

amit nagyrészt dolgozói részvényvásárlási opciókkal oldanak meg,

amihez nem árt, hogyha a részvényárfolyam folyamatosan emelkedjen

még akkor is amikor válság van.

( ~ AMD’s ability to attract and retain qualified personnel )Ki tudja, hogy mivel csábította át Raja Koduri-t az Intel,

de a kompenzációs csomagban biztos volt egy hatalmas részvényopció is.Az Intel CEO-nak (Gelsinger) opciója is publikus

és a befektetők ezt egyértelműen a tudtára is adták hogy nem mindegy az árfolyam

"For Gelsinger to exercise his performance-based stock options, he must now increase Intel's stock price by 50 percent — rather than the original 30 percent figure — over the five-year period after he received the options. Furthermore, Intel's stock price must hold above that 50 percent threshold for 90 days instead of the original 30 days for Gelsinger to receive the payout." https://www.theregister.com/2022/11/23/intel_gelsinger_shares/Mottó: "A verseny jó!"

-

Petykemano

veterán

"értem én hogy Abu it az AMD ben csak pozitívumokat sugall és minden jó ami itt születik, míg az Nvidásba átjön benyögni annyit hogy 549$ lesz a kártya meg ennél szarabb lesz aztán elmegy"

Általában az történik, h abu beharangozza, h az nv kártya drága, vagy szar, az AMD meg mennyivel olcsóbban tudja gyártani, vagy mennyivel jobb és versenyképesebb lesz.

Aztán (vegyük most ezt a 4060ti=3070=$500 pletykát) általában az nv végtermék jobb lesz annál, mint amennyire abu lehúzta (mondjuk a népharag elkerülése végett csak $449-479 lesz, vagy sokkal fogyasztással fog bírni az N6-on gyártott konkurenciával szemben. Egyébként ez se biztos, mert jelen állás szerint a 4060ti-4070ti közötti rész fedéséért az N32 felelhet) és az AMD termék pedig elmarad attól, amennyire.abu felmagasztalta. Nem lesz annyira gyors, többet fogyaszt, vagy nem is lesz annyira olcsó. Az AMD mindig beáraz az nv alá. Aztán csalódás.

(Aztán jön valaki vastag pénztárcábal és kioktatja a csalódottakat, hogy az élet nem mindenkinek fenékig tejfel.)Találgatunk, aztán majd úgyis kiderül..

-

S_x96x_S

őstag

II.

> OK, szóval pénzük nem lesz belőle

> és piaci részesedésük sem lesz belőle (az is pénznek számít).a trend az, hogy az AMD ( és az INTEL is ) az nVidia piaci kiszorításán dolgozik.

Az AMD következetesen dolgozik a következő generációs APU-kon,

ami teljesen kiütheti az alsó és alsó-középkategóriás diszkrét GPU-kat.

( vagyis az nVidia xx50 GPU családon ott a célkereszt ... )"Moving on to Strix Point’s RDNA 3+ iGPU, Paul suggests the GPU could feature up to 24 Compute Units and a 3 GHz+ clock speed. That said, the number of CUs isn’t final. Interestingly, Paul thinks the iGPU could make the lower-end discreet boards “irrelevant” with a minimum 9 TFLOPs of compute power if AMD meets the performance targets"

( via )amúgy a verseny jó!

[ Szerkesztve ]

Mottó: "A verseny jó!"

-

fLeSs

nagyúr

válasz

S_x96x_S

#59745

üzenetére

S_x96x_S

#59745

üzenetére

Na, végre egy jó válasz.

Ez tényleg egy olyan szitu, ami hosszútávon pénzt hoz a konyhára. Már ha igaz az, hogy az Intel is bele akar ugrani a konzolbizniszbe, én erről még nem láttam sehol szivárogtatást. Sztem előbb kéne írniuk egy normális drivert.Raja Kodurit nem kellett csalogatni, ment magától miután elvitték mellőle a Vega fejlesztőcsapat nagyját, hogy azok a Navin dolgozzanak inkább...

Részvényvisszavásárlás: a FAANG cégeknél ez inkább bevett gyakorlat (fizetés részvényben). Egy ilyen mértékű visszavásárlás nem mozgatja meg az árfolyamot (ahhoz túl kevés pénz) hacsak nem vmi kis cégről van szó (de annak meg nem lenne annyi pénze, hogy megmozgassa), szóval ez sztem nem az AMD melósairól szól, hanem ezekről a cégekről: [link] mert ők a valódi tulajai a cégnek (csak hogy a naivitást eloszlassuk

) .

) ."I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

-

fLeSs

nagyúr

válasz

S_x96x_S

#59748

üzenetére

S_x96x_S

#59748

üzenetére

Ehh, redgamingtech? Komolyan?...

Amúgy én is láttam a Strix Pointos videót.

9 tflops hogy jött ki neki?

24CU (64 shader/CU) 3 GHz-en AMD féle számolással 18.4 tflops lenne.

Normál számolással lenne 9.2 tflops, szóval vmi nem stimmel.

Ha az első számolás jó, akkor ez kb. RX 6600 sebességű, ha a második, akkor RX 6400.

24 CU kicsit sok (nagy területet igényel) iGPU-nak ahhoz hogy az AMD olcsó gépekben osztogassa.

Szóval vagy normál számolással 9 tflop vagy AMD-féle számolással 12CU.

Mindkét esetben max RX 6400 sebességre lehet számítani.A belépőszintű teljesítmény is elvileg egy mozgó célpont kéne legyen, szóval mire ez kijön, addigra a belépőszintű diszkrét VGA (RTX 4050?) gyorsabb kéne legyen, hacsaknem az NV már totál belesz..ik.

[ Szerkesztve ]

"I press keys on a keyboard all day and click a mouse in front of a glowing rectangle. Somehow that turns into food and shelter."

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

![;]](http://cdn.rios.hu/dl/s/v1.gif)