Új hozzászólás Aktív témák

-

frescho

addikt

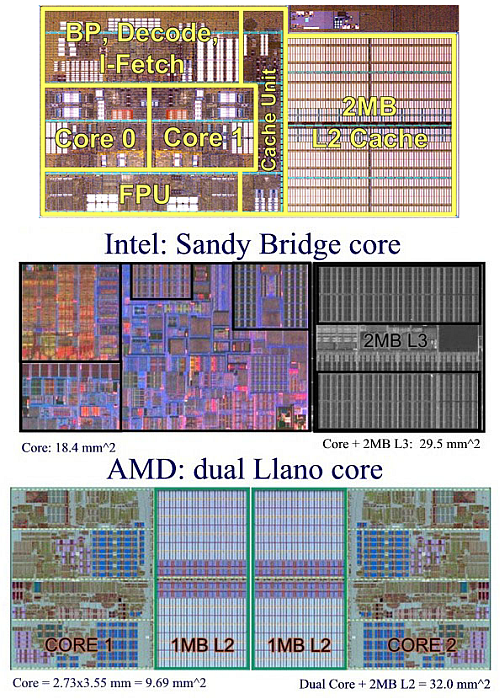

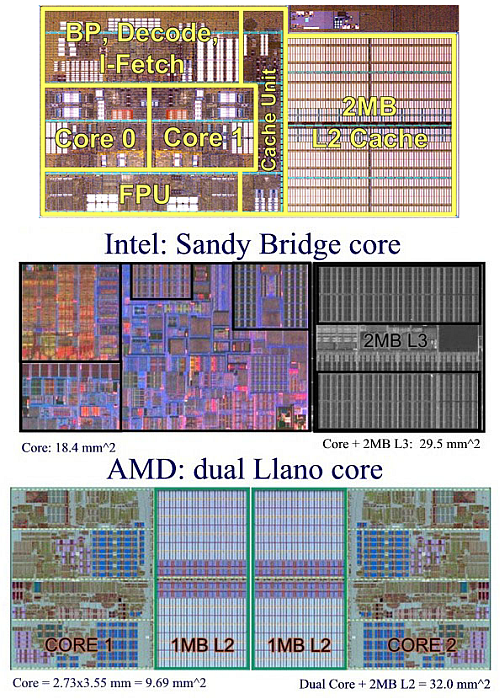

Kihagytad azt, hogy a komplett frontend rész is közös volt. A prohardveres cikkben ez jól látszik: [link] Alig volt néhány dolog ami tényleg duplikálva volt. Jó inulattal is csak 1.5 processzornak lehet mondani. Ami viszont nagyon fájdalmas, hogy még ezt a közös frontendet (fetc, decoder) is csúnyán alulméretezték. Ezért még azokban a programokban sem lehetett elérni 1 modulon 1 vs. 2 szál esetédn a dupla teljesítményt amelyikek amúgy jól skálázódtak. Ilyen pl. a cinebench, ami kb. 60%-kot gyorsul 2 mag használatánál. Szóval egy modul messze nem ért fel két maggal. Az ötlet maga amúgy jó lett volna, ha nem spórolnak a frontenden és nem bíznak a P4-nél már elhasalt frekvencia skálázódásban, na meg abban, hogy eljött a sok szálas programok kora.

https://frescho.hu

-

frescho

addikt

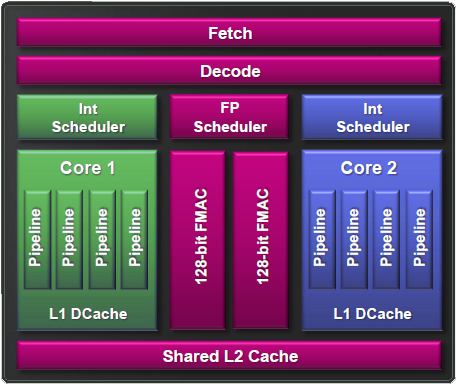

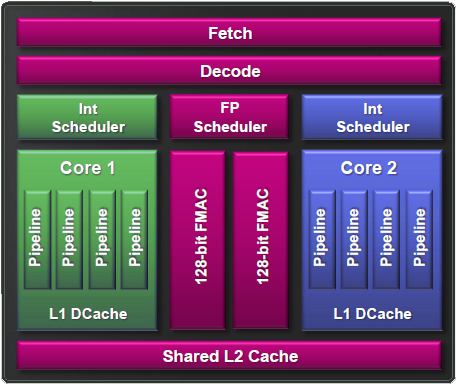

"A fenti képen zöld és kék színnel van jelölve az egy-egy mag dedikált része, lilával pedig a mindkét mag számára hozzáférhető egységek. Az utasítások végrehajtása a következő utasítások kiválasztásával, azok előfeldolgozásával és dekódolásával kezdődik, ezeket az összefoglaló néven front-endnek hívott megosztott részegységek végzik, órajelenként váltva a két szál között.

Az gyártó (AMD) figyelme leginkább egy úgynevezett Cluster-based multi-threading (klaszter-alapú többszálúsítás) felé irányult, mely a korai prognózisok alapján még plusz 50% szilícium felhasználása mellett 80% teljesítmény növekedést ígért."

---

"A Bulldozer front-endje nem volt alulméretezve. Konkrétan ezt kapta meg a Zen is. Még amikor az AMD a Zen briefingeket tartotta, akkor elmondták, hogy alig módosítottak rajta, mert ez volt a legjobb eleme a Bulldozernek, ami messze túl volt méretezve, így megfelelt a Zen magnak is."

Az, hogy a frontend megfelelt 1 Zen maghoz nem jelenti azt, hogy két Bulldozer maghoz nem volt alulméretezve. Ha jól emlékszem, akkor ezt azóta folyamatosan tovább fejlesztik, a Zen 2 esetében az IPC növelés fontos eleme volt. Analógia: Egy kis autó elég lehet egy 4 fős családnak, de 4 gyerekkel már nem férnek el benne.

"A modul lényege az egyszálú teljesítmény maximalizálása volt, mert ha egy szálon futott a számítás, akkor lényegében az a szál egymaga megkapta a túlméretezett, két szálra tervezett részeket."

A válaszodnak ez a részét gondold át. Egyértelműen elbukott a fejlesztő részleg, ha ez volt a cél, ugyanis 1 szálon a Phenom is simán iskolázta. Sokkal jobban megállja a helyét amit utánna írtál:

"A koncepció az volt benne, hogy ilyen formában sokkal kisebb mértékben kell növelni a lapkaterületet, a nagyobb százalékos előrelépéshez. A CMT +60-80%-ot jelenthetett, miközben lapkaterületben nagyjából +40-50%-ot fizettek. Plusz 100%-ért plusz 100%-ot kellett volna fizetni a lapkaterület szintjén."

Teljesen egyetértek, ha a CPU maximális sok szálú teljesítményét nézzük. De nem egy szál teljesítménye lett így nagyobb, hanem az adott sziliciumra vetített maximálisan elérhető. A kettő között negy különbség van ami miatt sikertelen lett a Bulldozer széria. Többek között ezért idéztem be a cikkeidből az első két képet. Jól látszik, hogy mi közös és az is, hogy a lapka méretében ez mit jelentett.

"Az AMD-nek van is egy compute core whitepaperje. Abban ezt értik mag alatt: egy mag olyan HSA-t támogató, tetszőlegesen programozható hardveres blokk, amely képes legalább egy folyamatot futtatni saját kontextusán, illetve virtuális memóriaterületén belül, függetlenül a többi magtól."

A második ok amiért a képeket beszúrtam a második mondatod. Egy maghoz eszerint kell fetc, decode, FP scheduler és L2 cache is. Ha kiveszem az egyik maggal ezeket, akkor a másik már nem felel meg az állításnak. A 1.5 magnak megfelelő szilicium azt is jelenti, hogy csak 1.5 mag került oda. 1 modul, de nem teljes értékű két mag. Analógiával egy társbérlet nem felel meg egy teljesen saját lakásnak.

Én úgy látom, hogy az AMD helyes döntést hozott. Ha biztosan nyertek volna, akkor az ügyvédi kültséget nem nekik kellett volna állni. Mérlegeltek és úgy látták, hogy a nyerési esélyük alatta van annak amit megér a megegyezés. Műszakilag is jó váltás a Ryzen vonal.

https://frescho.hu

-

frescho

addikt

Tisztában vagyok vele. Az FP scheduler közös. Az FMAC nem, ha megnézed az első képet.

Nem is írtam ilyet. Az ügyvédeknek sikerdíja van. Ha az AMD nyer, akkor egy fillért sem kellett volna fizetnie senkinek. A kifizetett összegből jön le az ügyvédi díj. Az AMD azért törekedett a megegyezésre valószínűleg, mert jó eséllyel nem nyertek volna.

https://frescho.hu

-

frescho

addikt

Erre adj légyszi valami AMD-s forrást:

"Pedig az egyszálú teljesítmény maximalizálása volt a cél, hiszen a modul egy erősebb összeállítás volt, és a részben osztozkodó erőforrásokat teljesen megkapta az egy szál, ha mellette nem futott semmi."

Kíváncsi lennék ki merte ezt leírni. Nem csak, hogy IPC-ben léptek hatalmasat vissza, de még az előd Phenom II alap órajelen is simán elverte kevés szálat kihasználó programok esetén.

"Az AMD sem tudja, hogy miért terjedt el az a legenda, hogy a front-end kevés volt, de nem volt az, a sokkal erősebb Zen magba is át tudták menteni, és semmi gondja nincs a kiszolgálásával."

Akkor mi volt az oka, hogy sima integer felhasználásnál sem duplázódott a teljesítmény ha egy modulban 1 vagy 2 "core" volt aktiválva? Meg tudod mondani, hogy sima fordításnál mondjuk mi lehetett a szűk keresztmetszet, ha az FPU és a fronted nem?

https://frescho.hu

-

frescho

addikt

"A Zen bemutatóján volt két mérnök. Az egyik mondta, hogy a Bulldozert anno úgy tervezték, hogy egy modulon belül maximalizálják az egyszálú teljesítményt. Ezért gyorsult a második száltól csak 60-80%-ot a rendszer két magra vetítve, mert az első szál már eleve megnövelt erőforrásokat kapott, így gyorsabban tudott dolgozni, mintha két kisebb magot alakítottak volna ki. Két kisebb maggal ugyanott lettek volna két szállal, de egy szállal lassabb lett volna a rendszer."

Tervezték, de végül nem lett igaz. Mérnökként nem lett volna képem kiállni és ezt elmondani. Nem értetted félre amit mondtak? Írásos/videó anyag van róla? Amiért még mindig kételkedek:

- Az elérhető anyagokban a tervezési alapelv a szilicium méret (transistor budget) / teljesítmény javításról szólt. Ilyen szempontból nagyon sok szálas programokban jól sikerült a Bulldozer. Az utolsó mondatod is ezt erősíti és azzal egyet tudok érteni.

A második mondatodra megint visszakérdeznék:

- Mik voltak a közös részek?

- Ha azok nem voltak alulméretezve, akkor miért nem tudtak kiszolgállni egy komplett modult? (Itt arra gondolok, hogy lehet, hogy egy maghoz képest 160%-ra volt méretezve, de két maghoz bizony 200% kellett volna.)A P4-es résszel nem értek egyet, mert ott a felépítés sokkal kevésbé volt egzotikus és a két problémából csak egy volt közös a Bulldozerrel. P4-nél a legegyszerűbb programok is gyorsultak. A közös probléma a gyártástechnológia volt. Nem véletlen, hogy ma is 4GHz körül mozog a procik értelmes órajel limite, az 5GHz bár elérhető de brutális TDP-vel. A P4-nél az Intel, a Buldozernél a GF nem tudta ezt átugrani. Egyszerűen érthetetlen, hogy az AMD mérnökei miért futottak neki ugyanannak a falnak amibe az Intelnek már beletört a bicskája.

A AMD másik hibájának bemutatásához tőled idézek.

"A limit a szoftver."

"A felhasználók tudása rendkívül korlátozott a mérnökökéhez képest. Nem értik, hogy mit miért csinálnak, rosszabb esetben félreértik. Lásd a Bulldozer esetében. Az volt a hit, hogy a modulos felépítés miatt volt lassú az egyszálú teljesítmény. Pont emiatt volt nagyobb, mint amilyen lett volna a modulos felépítés nélkül. Csak ugye nem tudod megmagyarázni nekik, mert nincsenek meg az ismereteik hozzá, hogy megértsék."

Aminél tévúton jársz és az AMD is belement ebbe a zsákutcába az a piac megreformálásának a hite. 10% alatti részesedéssel prófétának lenni nem működött. A szoftver adott volt és mindenki nagyon jól tudja, hogy évek kellenek egy új technológia bevezetésétől annak széles körű kihasználásáig. Ebbe a környezetbe az alapcsony IPC és órajel páros kihozatala hiba volt. Nem kicsit "mindenki szembejön a pályán" érzés lehetett a mérnököknek.

A felhasználókat az teljesítmény, illetve az ár/teljesítmény érdekli. Mérnökként lefuttattam rajta 10-20 tesztet és gyengének bizonyult. Még ott is, ahol elvileg sok szál volt maximum egyenlőt tudott hozni magasabb fogyasztással, azonos áron. Nem érdekelt senkit, hogy 10 vag 20 mm2-ert sziliciumot megspóroltak. A reakció az volt nem 1-2 embertől, hogyha az új architectúra lassabb IPC-ben és szinte abszolút értékben is, akkor miért nem a Phenomot kalapálták ki jobban.

"A célcsoportot nem választják. Viszi, akinek kell."

"célcsoport (Target Group): azon - marketing célok alapján meghatározott - emberek csoportja, akiket a kampány illetve egyéb kommunikációs tevékenység során elérni szeretnénk."

Márpedig azt a marketing/sales választja. Ha az AMD nem tudta kinek akarja eladni, akkor ott még nagyobb volt a gond. De ezt nem hiszem, nem merem elhinni.

Frawly: Az nem ekézés, ha kimondjuk, hogy a tervezésnél rossz irányt vettek. Intelnek is volt ilyen és most éppen az AMD-nek van jövőbemutatóbb, skálázhatóbb procija. Nekem az nem tetszik amikor nem mondjuk ki, hogy valami bizony el lett kefélve.

Az ARM már évek óta "jön" de valamiért nem akar ideérni. Két gondot látok. Az egyik, hogy amikor felskálázzák máris sokat veszít az energiahatékonyságából. Egy mai CPU-nál a fogyasztás nagy részét már nem is a klasszikus "mag" , hanem az azt kiszolgáló részek kérik. Az AMD ezt vágta szét most ügyesen, csak ehhez kellett a megfelelő interposer, a magok közötti összeköttetést biztosító busz és még kismillió más dolog. A másik gond az, hogy egy google-nél is nagyon sok pénznek számít egy meglévő komplett OS-nek akár más processzoros verzióját bevezetni. Csak pár dolog ami hirtelen eszembe jut:, hogy kell belőle szeparált: hardver tervezés, beszerzés, szoftver build, deploy, test/staging, repository...

[ Szerkesztve ]

https://frescho.hu

-

frescho

addikt

"Úgy magyarázták, hogy hardveres szinten alig volt közös rész. Annyi történt igazából, hogy az egyes kritikus részegységeket tervezték túl, hogy ki tudjanak szolgálni két szálat is."

Nem válaszoltál a kérdésemre, hogy konkrétan mik voltak a közös részek. Az eredeti Bulldozer bemutatódban a chip nagy része közös.

"A Pentium 4 ugyanott csúszott el, ahol a Bulldozer. Az nem véletlen, hogy az Intel és az AMD is letér a P6-szerű dizájnok irányáról, és együtt elcsúsznak."

Konkrétan mi volt az amiben a P4 elbukott és megegyezik ugyanez a hiba a Bulldozerben? Könnyű a szoftverre fogni, de semmi konkrétumot nem írtál, hogy mi volt a közös a P4 és a Bulldozer platformban. Konkrétan mit jelent az, hogy "P6-szerű dizájn" és a P4 miért skálázódott elfogadhatóan addig amíg nem futottak bele a maximális frekvencia/fogyasztás falba?

https://frescho.hu

Új hozzászólás Aktív témák

it Az AMD 12,1 millió dollárért kisakkozta magát a perből. Jól járt mindenki?

- Eladó WHARFEDALE EVO 4.3

- -61% Samsung Galaxy Book2 Pro 13:i5 1240P,8GB,256GB,13.3" AMOLED,400nit 100%sRGB,WiFi 6E,csupán 870g

- Amazfit GTS 2 új! (nem a mini)

- -62% HP EliteBook 845 G7 (840 G7):Ryzen 5 4650U,16GB,512GB SSD,vilI.MAGYAR bill.,Bang&Ol.,Win11ProHU

- Több db HP Thunderbolt dock 230W G2 230W -os töltővel MONITORCENTER