Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

Teljesen mindegy, hogy 8 vagy 10 nm. Amit a Samsung közöl az vagy valami ARM tesztdizájn, vagy gyűrűs oszcillátor. A half-node-ok igazából a gyakorlatban igazán minimális előnnyel rendelkeznek a full-node párjukhoz képest. Egy komplex lapka nem csak egyszerű áramkörökből áll.

(#9) Cifu: Éppenséggel jó lenne a 7 nm, mert azért az mégis egy full-node, és komoly tranzisztorsűrűséget ad. De a TSMC-nél túl kevés a leköthető kapacitás, mert licitálni kell érte az AMD-vel, az Apple-lel és a Qualcommal, vagyis az NVIDIA csak a maradékra tud pályázni. Nem tudnak annyi pénzt ajánlani, amit az előbbi trió, mert nem neveznek olyan piacokra. A Samsung pedig kockázatos. Sose gyártottak ám nagy és komplex lapkákat. Ez eleve nagy hibaforrás, pláne egy új node-on, amit kevésbé ismernek, mint a 10 nm-t, vagy annak a half-node-ját. Szóval szerintem a 10 nm leginkább azért lehet kézenfekvő, mert ismeri a Samsung, jó ideje gyárt rajta, és ez jó kísérlet lesz számukra is. De persze az NV-nek fontos a hibaforrások minimalizálása, tehát a legbiztosabb és gyakorlatban is elérhető relatíve modern node a Samsung 10 nm-es eljárása.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nem a nagyság a lényeg, hanem, hogy milyen piacokat tudnak célozni. Az AMD-nek sokkal jobb lehetőségei vannak az Apple-lel és a Qualcommal való licitálásra, mert a processzorpiac alapot ad erre. Ha viszont ugyanúgy csak a GPU-piacot céloznák, mint az NVIDIA, akkor ugyanúgy az olcsó megoldásokat keresnének, és nem a TSMC legtöbbet rendelő partnerévé lépnének elő.

Ha pusztán az anyagiakon múlna, akkor az NV is licitálna a 7 nm-re, csak el is úszna vele a nyereség. Nem céloznak olyan nagy és zsíros piacot a processzor nélkül, ahol fenntartható lenne a jelenlegi működés, ha nagyon zsebbe nyúlnak a waferért. Az AMD-nek azért nagyon könnyű úgy, hogy a processzorok kitermelik a GPU-kon ezt, tehát utóbbival is lehet menni a csúcstechnológiára, mert ott már csak mennyiségi tényezőt számolnak, a nyereséget maga a Ryzen és az EPYC, illetve a konzolok behozzák. Az NVIDIA-nak ezekből egyik sincs meg, tehát olyan megoldás kell számukra, ami a nyereséget egy nem optimális piacon termeli be, de úgy, hogy közben figyelni kell arra is, hogy ne vigyék a középkategóriás VGA-k árát ezer dollár fölé. Így már a TSMC-nek a licites waferlekötése egyértelműen kiesik. Láthatóan még a Samsungnak a 7 nm-es node-ja is drága. Nyilván kellene a modern gyártástechnológia, mert egy csomó tranyót költhetnének cache-ekre, de nem mindenáron. Nekik is számolni kell azzal, hogy ha most ugranának 7 nm-re, akkor megint növelni kellene az árat úgy bő 50%-kal, mert nem tudják megtenni azt, amit az AMD, hogy majd a procikon bőven behozzák, amit a VGA-kon elvesztenek.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Semmi ellentmondás nincs. A probléma az, hogy nézd mekkora piacot lehet támadni a processzorokkal, és nézd meg mekkorát a GPU-kkal. Összehasonlíthatatlanul nagy a különbség. Ha az AMD is olyan helyzetben lenne, mint az NV, hogy nincsenek processzorai, akkor ők sem lennének 7 nm-en. Egyszerűen a konzumer GPU-knak túl drága. A szerverbe szánt hardvereknek nem, de azok meg mennyiségben kevesek. Ez van.

Az AMD nem sokat keres a 7 nm-es GPU-kon. Szinte előállítási költségen mennek. De a processzorokat annyira sokért adják, hogy azok bőven felhúzzák az egész divíziót.

Nem, mert a 8 nm-es Samsung node valójában egy 10 nm-es half-node. Alapvetően nem sokkal tud többet, mint a TSMC 12 nm-es eljárása. Hiába sokkal kisebb a szám a nanométer előtt. A valós előrelépést a 7 nm adja a Samsungnál is, csak nagyon-nagyon drága.

Ugyanígy a 6 nm sem lesz igazán nagy ugrás a TSMC-nél, míg az 5 nm jelentős előrelépés. A 8 nm-es half-node-ra csak akkor érdemes menni, ha valami specifikus optimalizálás miatt jobban érinti a lapkát. Ha nem, akkor ugyanaz, mint a 10 nm. Az, hogy a TSMC meg a Samsung kimér 10%-nyi eltérést mondjuk egy gyűrűs oszcillátoron, nem jelent semmit egy komplex lapkára nézve.Ha a konkurenciát is idevesszük, akkor számításba kell azt is venni, hogy a 7 nm-es node-ot ki kell ismerni, hogy jól lehessen használni. Lásd a Renoir, aminél az AMD először felhasználta a 7 nm-es tapasztalatokat. Egészen sokat léptek vele előre perf/wattban. Az első 7 nm-es Vega dizájnhoz képest majdnem 3x jobb a Renoir Vega dizájnja. Az RDNA2-re is azért mernek akkora előrelépést írni, mint amennyit nyertek a 14->7 nm váltásnál, mert rájöttek, hogy miképp kell használni a TSMC gyártási eljárását. De ez első körben sosem megy, túl sok az ismeretlen. Az 5 nm még nehezebb lesz, tehát ott is az nyer, aki a legelőször vált, mert hamarabb tud tapasztalatot gyűjteni. Legközelebb a 3 nm lesz egyszerűbb a tervezés szempontjából, mert jön az új tranzisztorstruktúra. Csak az iszonyatosan drága lesz.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Mindenkinek a saját tapasztalatát kell megszereznie. Az NVIDIA most gyűjti majd össze, amit az AMD a Vega 20-szal. Valószínűleg a második generációs 7 nm-es fejlesztés, nekik is akkora ugrás lesz, mint amilyen az AMD-nek.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Persze, hogy a piac mérete határozza meg. Ha nem elég nagy a célpiac, akkor korlátozott mértékben termelhető csak ki a befektetés.

Az a baj, hogy csak a pénzügyeket nézed, de nem veszed figyelembe, hogy egy 7 nm-es lapka költsége legalább háromszor nagyobb, mint egy 16-12 nm-esé. Tehát elhiszem, hogy neked logikusnak tűnne, hogy erre menjenek, de például a befektetők nem örülnének annak, ha a nyereség sokkal kisebb lenne.

A 7 nm csak akkor reális opció, ha az adott cég céloz egy olyan piacot, amelyen belül masszív növekedési potenciállal rendelkeznek, vagy maga a piac növekedhet jelentősen. Mint írtam csak a GPU miatt az AMD-nek sem érné meg ez, mert a célozható piacokban nincs nagy potenciál. Egyetlen dolog miatt csinálják: az EPYC. A szerverpiacon jelenleg sorra nyerik a nagy kiírásokat, és ami ennél is érdekesebb, hogy az EPYC győzelme automatikusan nyeri nekik a gyorsítókat is. Lásd hiába az NVIDIA HPC-piaci fölénye, semmit sem érnek vele, mert a három nagy exascale megrendelésből jelenleg nullában vannak benne. Ezt jelenti a növekedési potenciál. Ha meg tudod nyeretni a CPU-val a GPU-kat is, akkor megéri, de más esetben igen kérdőjeles az elképesztően drága 7 nm-es node-ra menni minden fejlesztésnél, nem lesznek olyan termékeid, amelyek kitermelik a kicsiken a veszteségeket. Az NVIDIA egy teljes 7 nm-es termékskálával nem menne semmire. A Teslákra muszáj, mert ott versenyképesnek kell maradni, eleve hatalmas hátrány, hogy nincs processzoruk, és azon kell ügyködni, hogy az Intel és az AMD komplett HPC platformjait fúrják meg. Egyelőre elég kevés sikerrel, mert nem valószínű, hogy egy éve gondoltad volna, hogy a DOE három fő megrendeléséből kimaradnak. Valószínűleg az NVIDIA sem számított erre, főleg a CORAL-2 program tudatában, ami pont segítség volt a kisebb cégeknek, hogy az Intel ne vigyen el minden megrendelést. Ehhez képest két AMD és egy Intel csomagnál tartunk, miközben az IBM a közelében nincs a tendereknek, pedig kritikus fontosságú lenne az NV-nek, hogy be tudják rakni a GPU-ikat oda. Szóval jelen pillanatban nem sokat érnek a GPU-k, mert ha ez számítana, akkor most háromból három NV nyerésről írnánk, de ami ma eladja a GPU-t, az a CPU. Ha szabványosítunk valami memóriakoherens interfészt 2024-2025 körülre, akkor talán ez megváltozik, de addig a zárt interfészek lesznek a menők, tehát az NV-nek az kell, hogy az IBM nyerje a tendereket, mert akkor nyernek velük ők is.

Az RDNA2 az RDNA1-hez képest annyit hoz, mint az RDNA1 hozott a Vegához képest. Ugye ezt bejelentette az AMD. De ez mindegy amúgy, a fenti probléma miatt akkor is túl drága a 7 nm az NV-nek, és ráadásul ugyanúgy meg kellene tanulniuk használni, ahogy az AMD-nek, meg mindenki másnak, ami évek kérdése.

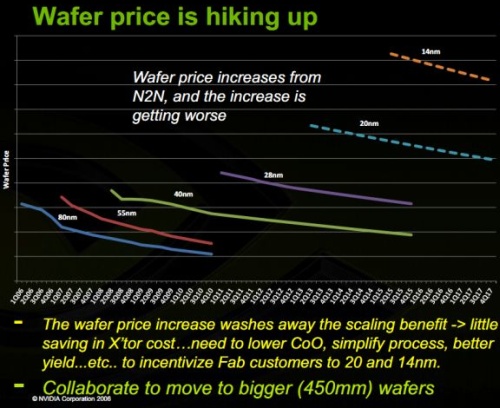

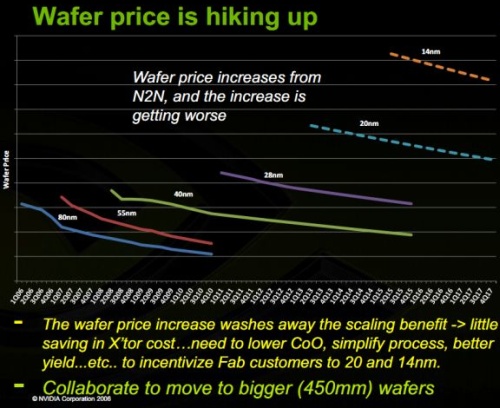

Az áraknak pedig a versenyhez semmi köze. Egyszerűen túl drágák az új node-ok a VGA-kra. A 20 nm volt az utolsó node, aminél a waferár elérte az előző node kezdő waferárát. Erről az NVIDIA is sokat beszélt régebben:

A 14 (16-12) nm-es waferek mindig drágábbak maradtak a 20 nm-nél, a 10 nm-esek a 14 nm-eseknél, és ugyanez igaz a 7 nm-re, csak az utóbbi esetben az a probléma, hogy a drágulás igen jelentős. Nem éri meg már bizonyos termékeket levinni rá, mert a technikai kétségtelenül nagy, de azt a terméket el is kell adni, ráadásul olyan nyereséggel, amiből finanszírozható a következő generáció. És eközben figyelni kell, hogy a célpiacok mennyire érhetők el. Az NV esetében a HPC-piac kritikus, és ahogy fentebb láthatod az exascale megrendeléseket, itt nemhogy növekedési potenciál nincs, de egyelőre sorra bukják a tendereket. CUDA ide vagy oda.Szóval ez nem olyan egyszerű ám, hogy termeltünk x nyereséget, és akkor ugorjunk a legmodernebb node-ra.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A Microsoft egy rakás EPYC-et és Instinctet is berendelt. [link] - ők mindig rendelnek mindent.

Teljesen mindegy, hogy ki miatt bukják el a projektet, a lényeg az, hogy nem jön belőle pénz. És emiatt kell úgy hozzáállni a fejlesztésekhez, hogy a jövőre vonatkozó igényt is figyelembe kell venni. Ha nem termelhető ki a teljes termékskálára a 7 nm, akkor nem szabad használni, mert csak baj lenne belőle.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#39

üzenetére

paprobert

#39

üzenetére

A Navi 10 ára mostanság olyan 55-60 dollár körül lehet tokozással. Talán nem tűnik soknak, de ez amúgy nagyon drága, mivel nem csak GPU-t adsz el, hanem egy komplett VGA-t, amire kell még egy rakás memória, számos egyéb komponens, hűtő, a NYÁK, stb. Régen a hasonló kiterjedésű lapkák 20-25 dollárba befértek, a drágulás egyértelmű.

Az önmagában nem sokat ér amúgy, ha több lapkád van. Akkor számít, ha a több lapkából legalább egy olyan piacra megy, ahol nagyon lehet kaszálni. Az AMD-nek ilyen a CPU-piac. Ez a szerencséjük. De a GPU-piac nem ilyen.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#41

üzenetére

paprobert

#41

üzenetére

Csak nulla GPU-t vásárolunk önmagában. Körítéssel együtt mennek el akármelyik piacra is kerülnek.

Nem sokat érsz el a négy lapkával, ha nem tudod velük kitermelni a váltást. Az, hogy egy csomó fejlesztési munka felhasználható később, még nem jelenti azt, hogy el is adható négyből kettő termék akkora mennyiségben és olyan nyereséghányaddal, hogy megérje új node-ra ültetni. Bőven lehet, hogy hamarabb kitermeled a váltást, ha két terméket sokkal olcsóbb node-on hagysz.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#43

üzenetére

paprobert

#43

üzenetére

Azért drága, mert a régen egy 250 mm2-es lapka ára 20-25 dollár között mozgott. Ma 55-60 dollár. Attól, hogy ez kevésnek hangzik, még messze nem az, mert egy 300 dolláros VGA-n nem csak ez van, hanem egy rakás komponens, memória, hűtő, NYÁK, stb. Ezért megy fel a VGA-k ára.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

ph Az egyiket a cég a grafikai munkára, míg a másikat csak compute feladatokra szánja.

- Háztartási gépek

- A Samsung hazánkban is piacra dob idén egy friss Micro LED tévét

- Kínai, és egyéb olcsó órák topikja

- Autós topik

- Vezetékes FEJhallgatók

- Vezetékes FÜLhallgatók

- Android alkalmazások - szoftver kibeszélő topik

- Politika

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Publikálta a Microsoft az MS-DOS 4.0 forráskódját

- További aktív témák...