Új hozzászólás Aktív témák

-

Kansas

addikt

válasz

MasterMark

#1

üzenetére

MasterMark

#1

üzenetére

RTX2080Ti-nak is elég... ez meg inkább egy 2070Super/RX5700XT szintű kártya...

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

2 éve nem ugyanannyi kraftot igényelt a FHD mint most(RT ugye kezd már terjedni)... ha megnézed, az RTX2060 is 160W-os TDP-kerettel bír.

FHD CS:GO-ra a GTX1650 is elég, de egy Metro: Exodus vagy egy RDR2, és újabb AA címek alá azért az már kevéske, feltáve hogy a megcélzott beállítási szint nem a "Low".Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

PowerBuldog

#8

üzenetére

PowerBuldog

#8

üzenetére

Ha nem azonos az architektúra(márpedig AMD és NV közt nagyon nem az), akkor mindig is lesznek olyan játékok, amik egyiknek vagy másiknak jobban fekszenek(a fizetett optimalizációról nem beszélve), a Cyberpunk pl. az NV terepe, a Valhalla meg az AMD-é, ott a 6700XT a 3090-et is veri FHD--ban, de QHD-ban is a 3080 teljesítménye körül van...

Akkor most írjam azt, hogy a 3090 el se éri a 6700XT szintjét...?Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

MasterMark

#10

üzenetére

MasterMark

#10

üzenetére

8x 3.0 már nem igazán, az már az 5500XT-t is visszafogta, leginkább VRAM-limites helyzetben. Mondjuk ebből nem lesz 4GB-s modell, szóval talán annyit nem fog számítani... viszont a GPU meg erősebb... meglátjuk a független tesztekben.

Ha csínján bánik az ember az AA beállításokkal és nem nagyon megy FHD fölé, talán nem lesz gond PCIe v3 slotban se.Visztont ezt az infót csak itt láttam eddig, LTT, GN, AnandTech pl. nem említette, pedig relatíve fontos pont lenne, szóval azért erre még néznék forrást...

TPU-n látok még ilyen infót, sehol máshol...[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Videocardz.com szerint x16-os. Szóval nem tudom...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

#95462144

#17

üzenetére

#95462144

#17

üzenetére

Nem keveri. Csak cseresznyézik a teszteredmények közt.

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

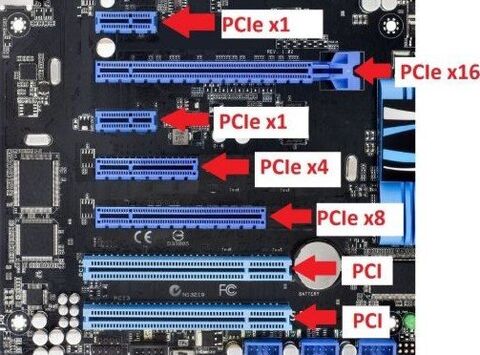

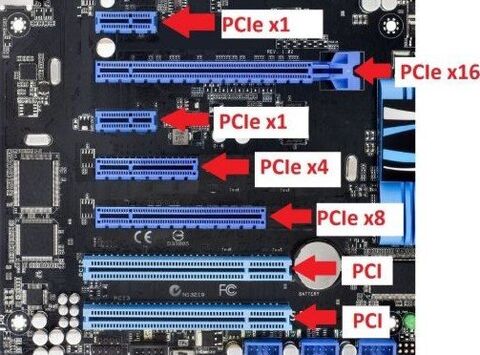

Konzumer alaplapon én még nem láttam PCIe x8-as slotot, mind az x16-osat használja az x8-hoz is... gondolom részben a slot-végi rögzítő pöcök miatt.

Őszintén szólva elég fillérb@szó hozzáállás az AMD részéről... 5500XT-nél is határeset volt, de ez egy jóval erősebb kártya... rendben, hogy már az Intelnek is vannak PCIe v4-es lapjai(és CPU-i) meg a B550 se eszelősen drága, de azért megvárhatnák, míg nagyobb részt kikopnak a PCIe v3 lapok...

Ha az ennél kisebb RX6xxx kártyák is x8-asok lesznek, akkor a budget vásárlókat az NV karjaiba terelik, mert pont ők nem fognak új procit/alaplapot venni a VGA-cseréhez.[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Ezzel arra akarsz utalni, hogy aki tudja, mit nézzen, az AMD-t vesz?

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

MasterMark

#25

üzenetére

MasterMark

#25

üzenetére

VRAM-limites helyzetben igen. Ha elég a 8GB VRAM, akkor aligha fog észrevehető (2-3%<) különbséget okozni. 5500XT esetében legalább is így volt... ez egy erősebb GPU, RT-vel, szóval majd meglátjuk a független tesztekben...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

MasterMark

#27

üzenetére

MasterMark

#27

üzenetére

Hááát... én egy hasonló erejű kártyával(RX5700XT) 4K-ban játszok, ott azért már erősen meglátszana a különbség(ha nem B550-es lapom lenne, persze).

És persze azok a játékok, amelyikek jobban terhelik a PCIe buszt(pl. Battlefield V), azok már 1080p-ben is 10+% bukóban vannak 5500XT/8G-n is...A magam részéről én kihagyom ezeket az x8-as kártyákat, és majd jövőre váltok vagy használt RX6700XT/6800-ra vagy új RX7600/7700-ra(ha így hívják), függően attól, mennyire állnak vissza addigra az árak(+ hogy állok épp akkor anyagilag)

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Hát eléggé idióta helyzet valóban... az RDNA2 előtti 5 évben az volt a gond, hogy az AMD nem ad ki középkategória fölé VGA-t, most meg az, hogy alá nem... de legalább már high-end van, kár hogy annyi pénzt kérnek el érte a kiskerben...

No nem mintha az NV-nek lenne kis kártyája... a 16xx-eknek még nincs utódja desktopon, a 1030-nak meg még laptopban se... szóval az NVidiának is össze kell kapnia még magát a budget szegmensben...Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

#16939776

#33

üzenetére

#16939776

#33

üzenetére

Akkor az van, hogy elbukják az eladásaik 80%-át, és vele a nyereségük tetemes részét.

Azt ne hidd, hogy akinek eddig csak $200 volt VGA-ra az hirtelen majd felköhög $4-500-at - és ők vannak többségben nyugaton is, nekik készültek az ilyen VGA-k mint a GTX1050/1650 meg RX560. A kínai netkávézókról nem is beszélve.

Nagy hangjuk van a fórumokon a HC gamereknek, csak épp apró kisebbségben vannak a vásárlók közt, akik nagy tömegben a középkategória közepét és alját vásárolják. A belépő szint meghalt, mióta majdnem minden Intel prociban van IGP, azok a kártyák senkinek nem hiányoznak, amik épp hogy képet adnak.

Azok hiányoznak, amikkel már épp játszani lehet.De beszéljünk magyar oldalról: azok a VGA-k hiányoznak, amikkel 40-80e Ft-ért cserébe már lehetett FHD-ban játszogatni, amiket az átlagember a gyerekei PC-jébe vett pl.

A gyártók ezt nem fogják a használt piacra bízni, mert abból ők egy fillért se látnak...Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Akkor marhaságot mondasz, vagy túl piros a szemüveged.

A jelenlegi piaci viszonyok mellett nincs DOA kártya, ha a 6600XT tényleg tud átlag 15%-ot verni a 3060-ra, akkor ugyanazt tudja bang/buck.

Nézd csak meg, az NV mit ad 3050 néven mobil szegmensben.... ők se jobbak a Deákné vásznánál... ha ugyanazt kidobják desktopra is, akor pláne(4GB VRAM...)

Én is nosztalgikus vagyok az első önálló fizetésből vett gépemben levő GF6800GS iránt, de az akkor még nem ennyibe volt(mint a mostani 6800, vagy pláne a 3080), inflációval korrigálva se...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

#16939776

#39

üzenetére

#16939776

#39

üzenetére

Lehet, hogy neked furcsa, hogy az így működik, de a kiöregedő gamerek után jönnek a felnövő fiatalok, akiknek szintén nincs több pénze.

Plusz az hogy valaki felnő, nem jelenti azt, hogy nem játszik, sőt, gyakran pont azt jelenti, hogy a gyerekek cseperedtével épp velük játszik pl LAN party-t vagy valami közepesen lájtosat.Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Optika alapok: ahhoz, hogy ne lásd a piros szöveget, csak a zöldet, piros színű szemüveg kell...

Én se örülök, nem tudom, honnan veszed ezt, de világvégét se kell belelátni... nem kell minden generációban váltani, ennyi az egész.

Árazni meg a konkurencia aktuális kínálatához képest fognak, nem a saját prev.gen.-hez képest, különösen, hogy az most nem is kapható.

A mostani piaci viszonyok mellett árversenyt ne várj, nem lesz. Majd akkor, ha már nem lehet bármit eladni, ami eljut a kisker raktárig...[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

GeryFlash

#52

üzenetére

GeryFlash

#52

üzenetére

Azért az a "FullHD kártya" elég becsapós duma, az én kártyám ennél valamivel gyengébb és vígan játszok rajta 4K-ban WoWs-et, Witcher3-at, AC: Odyssey-t, ATS/ETS2-t, Transport Fever 2-t, CoD: MW1-2-3-at...

Nyilván a legújabb AAA játékokban RT-vel meg 120+Hz/fps hez csak FHD/WQHD-ra lenne elég, de azok meg vígan futnak a PS5-ömön 4K/60Hz-en...[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Biztos vagy ebben?

Ez egy 5500XT innen:

És erről biztosra tudjuk, hogy PCIe v4 X8-as kártya.

#59 tasiadam: bocsi, de az önmagában nem jelent a világon semmit, ha azt nem mondod meg, mivel terhelted... Battlefield V volt közte? Abban elvileg szűk keresztmetszet a PCIe v3 x8. Arról nem is beszélve, hogy a 6600XT GPU-ja kb. kétszer fürgébb az RX680-nál...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

#32839680

#61

üzenetére

#32839680

#61

üzenetére

Én sokat nem adok leakekre... majd mikor TechJesus szétkapja, akkor kiderül minden... nem mintha ehhez szét kéne kapni persze...

A képet meg a következő állítás cáfolatára szántam:

"Az x16-asnál kb. 4.5x hosszabb a bal oldalánál a jobb oldala, az x8-asnál kb. 3.5x hosszabb a bal oldalnál a jobb oldala."[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Ha arra vagy kíváncsi, hogy a PCIe sávszél mennyire elég, akkor azt kéne terhelni, nem a GPU-t...

Amennyire tudom, a furmark elsődlegesen GPU tesztre való.

Azt egyébként mivel nézted, hogy épp mennyi PCIe sávszélt használ a kártya?Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Az a kép gyanús nekem, hogy nem a 6600XT-ről készült... nézd már meg, hány extra tápcsati van rajta: 1x8pin+1x6pin, ehhez képest a ref. RX6600XT az 1x8pin.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

GodGamer5

#72

üzenetére

GodGamer5

#72

üzenetére

Megéri neked a 2060-at erre cserélni? Nem mondom, újonnan ha választani kéne, nem gondolkodnék sokat a kettő közt, de cserélni... ez kb. a 2070S szintje fölött van valamivel átlagosan.

De te tudod...Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

huskydog17

#77

üzenetére

huskydog17

#77

üzenetére

A 128 biten lovagolsz, tényleg

? E-péniszt mérni kell, vagy mi?

? E-péniszt mérni kell, vagy mi?

A 200 dolcsi alatti 128 bites VGA-knak mekkora volt a VRAM sávszélje? Ennek 256GB/s... pont, mint a 256-bites RX580-nak és GTX1070-nek, és több, mint a 384-bites R9 280-nak.Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Demagógia csillagos ötös!

Elemi logika(technológiai, üzleti, józan paraszti) egyes, leülhetsz.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Hát, a sávszél az eleve GB/s-ben van mérve és nem bitben, ráadásul a memóriabusz szélességének(bit) és az üzemi frekvenciájának(GT/s) a szorzata.

Szóval magasabb freki mellett elég kevesebb bit, igen.Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Az NVMe SSD nem osztozik a VGA-kkal a sávszélen, annak külön van x4 kivezetve a prociról... AMD-nél legalább is az első m.2 slot így megy, ha van egy második is, az már elvesz a PCIe slot-oknak rendelkezésére álló sávokból(pl ha teszel bele SSD-t, kikapcsol, vagy lekorlátoz egy slot-ot pl x8-ról x4-re).

Egyébként meg nem úgy használja a VGA a PCIe sávokat, hogy csak annyit használ belőlük, amennyit 100%-ban ki tud tömni, hanem az adat elküldött byte-onként új csatornát használ, amivel elvileg valamennyit lehet javítani a latency-n. Viszont ez azt jelenti, hogy minden rendelkezésre álló sávot kb. egyszerre használ.[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

És szerinted a dollár nem inflálódik, ugyanannyit ér ma mint pl. 5 éve?

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Jajj nekem, tán nem azt hiszed, hogy a beosztottad vagyok, hogy utasítgathatsz? Vedd ki a kezed a biliből.

Majd megcáfolom tételesen, ha időm/kedvem lesz, egyelőre még munkaidő van, nem érek rá kisregényt írni a baromságaidra, annyi van belőlük.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

huskydog17

#106

üzenetére

huskydog17

#106

üzenetére

Honnan veszed, hogy engem nem zavar? A PCIe x8 dolog kifejezetten bassza a csőröm ahogy fentebb írtam is.

"

2019-ben az AMD 369 euróért ezt adta:

Radeon RX 5700 : 256 bit memóriabusz, GDDR6, 448 GB/s sávszél, 1440p kártya; PCI-E x16

2021-ben az AMD 379 dolcsiért ezt adja:

Radeon RX 6600XT: 128 bit memóriabusz, GDDR6, 256 GB/s, 1080p kártya, PCI-E x8

"

Ebben viszont egész egyszerűen nincs igazad, vagy felültél a Z10N-félék demagógiájának.

Amit felhozol, az nettó számháború, amíg nincs mellette teszteredmény.

Honnan tudod, hogy a 6600XT-nek nem elég a 256GB/s, az "InfinityCache"-el gyorsí,tva? Egyelőre ott tartunk, hogy az RTX3080 és 3090 nem lépi le az AMD versenytársait(RX6800XT illetve RX6900), pedig a RAM sávszélessége majdnem a duplája az NV kártyáknak az AMD-khez képest, egyedül 4K-ban van látható különbség, de ott se minden játékban."1080p kártya"/"1440p kártya": ugyan definiáld már ezt a két fogalmat légy szíves:

- milyen játékban?

- a játékok mekkora hányadában? milyen játékok mekkora hányadában?

- RT ON vagy OFF?

- DLSS/FSR ON vagy OFF?

- milyen egyéb settingek mellett? AA, AF, árnyékokEgyelőre annyit tudni, hogy a nyers számítási kapacitásban kb. 10%-kal lesz erősebb a GPU az RX5700XT-nél(ami ugye az általad említett RX5700-nál úgy 10%-kal gyorsabb), ami anno 1440p-s kártyának volt mondva(de ahogy említettem, engem 4K-ban is vígan kiszolgál).

Na most hogy 1080p-s kártya az ami egy korábbi 1440p-s kártyánál még vagy 10%-kal erősebb? Egy módon: RT-t bekapcsolva natív felbontáson(tehát DLSS/FSR OFF). Csak azt elfelejtetted ezek szerint, hogy mellesleg tud RT-t is. Hogy milyen szinten és az mennyit ér az árban, az véleményes.

Szóval nem, nem ad kevesebbet, éppenséggel 20%-kal többet ad, MSRP-t nézve 10 dolcsival(<3%) drágábban. Nyers erőben is több, meg feature-ben is.

Számokban itt-ott kevesebb, de nem számokon játszol, hanem VGA-n.Nem mintha az MSRP-nek bármekkora jelentősége lenne manapság - mire normalizálódnak az árak, addigra a következő generáció bejelentésénél fogunk tartani jövő nyáron.

Valóban olcsóbban is lehetne adni, ez saccra úgy 330-350 dolcsit ér(ha elfogadjuk, hogy az 5700XT ért 400-at), de ha belegondolsz, hogy az az 50 dolcsi az kb 15000 Ft, akkor röhöghetnékem támad, látva a 2-3-400e-s kisker árakat...

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Tessék akkor, ha tételes válaszra vágytál.

demagógia:

"Nagyhangú, hazug ígérgetés és az érzelmek, szenvedélyek felelőtlen felszítása a tájékozatlan néptömegek megnyerésére."#78Z10N:

"

Az Advanced Mining Devices kapzsisaganak es zsugorisaganak ujabb es egyben utolso csucsa. A 6500XT mar senkit sem fog eredeklni $279-ert... - nettó demagógia, hangulatkeltés és/vagy picsogás

A 6500XT mar senkit sem fog eredeklni $279-ert... - nettó demagógia, hangulatkeltés és/vagy picsogás2021. A 4K korszakban az 1080p gaming $379-ba kerul

- azt akarod elhitetni velem, hogy bevetted az AMD marketing-dumáját arról, hogy ez 1080p-s kártya? Lásd még #54-55 és #118

- azt akarod elhitetni velem, hogy bevetted az AMD marketing-dumáját arról, hogy ez 1080p-s kártya? Lásd még #54-55 és #1182012 HD7850 2GB 256bit $249

2016 RX480 4/8GB 256bit $199/239

2021 6600XT 8GB 128bit $379

- ezek között pontosan semmi összefüggés nincs

- ezek között pontosan semmi összefüggés nincsRTX3060 12G 192bit $329

RTX3060Ti 8G 256bit $399 - szóval akkor az NV is spórol 4GB VRAM-ot és még van képe drágábban adni? Vagy nem számít annyit az a VRAM mennyiség, csak arról van szó, hogy 6GB már kevés lenne, 8GB-t pedig nem lehet rendesen rákötni 192-bites buszra, csak úgy GTX970-módra...$329 + 15% = $379

Centire ki van merve az (up to), de DLSS es RTX sehol sincs. Meg hianyzik 4GB ram, meg olcsositott 128bites pcb, olcsositott pcie x8. Tele van sporolassal es vagdosassal (32MB). Mivel a DLSS és az RTX az NV technológiák, nem lehet őket bekapcsolni AMD-n. DXR-t lehetne, de akkor meg a DLSS-t hiányolnád, amely célra ugyan van az AMD FSR, de azt még nem valami sok játék támogatja, és van vagy 1-2 ami DLSS-t is és FSR-t is támogat. Egyébként meg nyilván 1st party marketinganyag, nem kell készpénznek venni.

RTX3060 276 mm² 192bit 12GB

6600XT 237 mm² 128bit 8GB - lásd feljebb.Elertuk azt, hogy az AMD kisebb lapkat es olcsobban gyarthato kartyat dragabban ad, mint az Ngreedia!!! Csak milyen market share-re alapozza ezt az arcoskodast?! Megeltuk, hogy az NV ajanlata jobb! - Honnan tudod, mennyiért lehet most kártyát gyártatni? Egyébként meg Linus egész közérthetően elmagyarázza, hogy miért annyi, amennyi.

Az "olcsobb es jobb" utod:

5600XT $279 36CU 192bit RDNA1

6600XT $379 32CU 128bit RDNA2 - #118komplett rendszerek:

XSS $299 20CU RDNA2 128bit 10GB

PS5D $399 36CU RDNA2 256bit 16GB

XSX $499 52CU RDNA2 320bit 16GB - pár paramétert kihagytál, egyébként meg ezek nem PC-k, a megtérülés java része a 1st party és a saját store-okban eladott játékok utáni részesedésből jön össze, a HW-t veszteséggel árulják.Ez am a visszafejlodes

- ez ám a demagógia!

- ez ám a demagógia!AMD GOES INSANE! Radeon RX 6600XT 1080P GPU for $379 in 2021

Mar a 6700XT is kicsapta a biztositekot kulfoldon, de a 6600XT mar kemeny karomkodasokat kapott (USA, CA, UK, AUS, EU). Hivatalosan is szajba sz@rjak a gamereket. Bye bye AMD

"

"Ez nettó hangulatkeltés - normális reviewereket(tudod, Linus, GN, AnandTech, HU, Computerbase, stb.) nem baszott fel annyira, mint az általad referencia nélkül(külön grat) összegyűjtött idézetek elkövetőit.

Nyugodtan vedd referenciának AngryJoe-t akár felőlem, csak akkor először is jelöld meg, másodszor ne várd hogy túl komolyan vegyem...Azt meg gondolom észre se vetted, hogy az általad beszólásnak aposztrofált kétsoros kommentem nem rád vonatkozik személy szerint, hanem arra a szemétre, amit hozzászólásként összehordtál a #78-ba...

És ezután még van képed engem vádolni az AMD védésével, miután a hsz-edből az tűnik ki, hogy te vagy az, aki kritika nélkül beszopta az AMD marketing-dumáját.

Vagy nem szoptad be, de akkor pedig tudatosan csúsztatsz, terelsz és hangulatot keltesz.[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Az, hogy ki a demagóg, nem attól függ, nekem tetszik e, hanem a mondanivalójának a megfogalmazásától és attól hogy tartalmilag mennyi köze van a valósághoz.

Hogy a kérdéses pontban miért nincs igazad, elmagyaráztam, csak fel kell fogni.

Érvelést szívesen fogadok, de érvekből láthatólag kifogytál, az eredeti érveid pedig erős csúsztatásokon alapulnak.Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

Hopkins95

#127

üzenetére

Hopkins95

#127

üzenetére

"Tehát te az AMD prezentációját félretéve próbálod megmagyarázni nekünk, hogy a kártya igazából magasabb felbontásokra is alkalmas lesz, szemben azzal, amit az AMD állít?"

Mert mit is állít az AMD?

Mit jelent az, hogy "Full HD kártya"? Mikor én egy ennél gyengébb kártyán vígan játszok 4K-ban, és ráadásul megjelenésekor WQHD kártyának volt címkézve.

Egy valamit biztos nem jelent: azt hogy ez a maximum felbontás amiben alkalmas a játékra. Mivel az nagyon durván játék és beállítás-függő, arról nem is beszélve, hogy az "alkalmas a játékra" kifejezés is ahány ember annyifélét jelent...

Véleményem szerint ez egy semmitmondó marketing-címke, amit vagy bekajálsz, vagy nem."ez alapján pedig nagyjából ugyanannyi ajánlott fogyasztói árba kéne kerülnie, mint az Nvidia RTX 3060-nak" - már mi alapján? Az alapján, hogy általában olcsóbbak szoktak lenni, mint az NVidia? És akkor ez már törvény, hogy olcsóbbnak kell lenniük mindörökké, vagy mi a franc?

Ha az AMD tesztjének hiszel, akkor létezik egy ~15%-os átlahos teljesítmény-többlet: a teszt szerint Cyberpunk-ban 3,7%, a Valhallában pedig 33%. 15%-kal magasabb teljesítményért máskor egy kategóriát ugranak.

Én speciel nem hiszek a 1st party teszteknek, legalább is készpénznek nem veszem őket - de ha tényleg van átlag 15% különbség, akkor jogosan áraznak följebb. A 3070 és 3080 közt csak 20% van, ha nem tudnád... árban meg 100 dodó.

Itt nem az a kérdés, hogy a 3060-hoz képest megéri-e 15%-kal drágábban, mert ha van 15% különbség akkor bang/buck ugyannyira érik meg. Inkább az a kérdés, hogy milyen messze van a 3060Ti-tól, aminél csak egy huszassal olcsóbb."Ha még ez igaz is, akkor is az Nvidia RTX 3060-hoz mérten képest nem látom az okát, hogy miért ne Nvidia RTX 3060-at preferáljam, ha a 2 kártya ajánlott fogyasztói áron elérhető lesz..." Hát mondjuk mert 15%-kal több teljesítményt szeretnél... a kérdés inkább az, hogy nem ério-e jobban meg még egy kicsit rádobva 3060Ti-t venni, ha a sima 3060 nem elég.

De ez mind MSRP árakról szól, ami az elmúlt egy-másfél évben kb. úgy viszonyul a valósághoz, mint az esti mese...

És még egyszer: még nincsenek független tesztek, nem tudjuk mennyire fogja vissza a 128bit, a 32MB IC vagy a 8 PCIe sáv(v4-es alaplapban alighanem semennyire), nem láttuk mennyit dob rajta az RSF, mi van ha nincs bekapcsolva a SAM/RBAR, milyen lesz az elérhetősége(ha nem lehet akár ezt akár a 3060-at kapni, akkor nem tökmindegy, mennyibe kerülne???).

Már csak 2 hetet se kell várni a megjelenésig, bírjátok ki vad konteók nélkül.#128 hokuszpk: jepp, pontosan, csak valamibe bele kell kötni

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

válasz

huskydog17

#148

üzenetére

huskydog17

#148

üzenetére

- "Ezek az AMD által közölt hivatalos adatok, tehát akkor szerinted az AMD hazudik saját termékéről, értem." Az ugye megvan, hogy nem csak az a két lehetőség van, hogy vagy hazudnak, vagy szentírás amit mondanak... a kulcsszó az a marketing: ez amit kiadtak, egy marketing anyag, úgy tesztelnek, hogy kidomborodjon az előnye és kicsit el legyen fedve a hátránya(meg is lepődtem, hogy kiadják a Cyberpunk számokat)

- "ha annál csak pár százalékkal lesz gyorsabb, akkor kb. egy szinten van az RX5700-al" - OK, de ezt honnan veszed, hogy a 3060-nál csak pár százalékkal lesz gyorsabb? Az AMD mérései szerint(amit te láthatólag készpénznek veszel) átlagosan 15%-kal erősebb a 3060-nál, ami több, mint amennyivel a 3090 erősebb 3080-nál...vagy amennyivel az RX5700XT erősebb az RX5700-nál

- "Az adott felbontásra ajánlott kártya, tudod, mint ahogy a Polarisok is 1080p kártyák voltak, meg a GTX 1060 is." - és a 6600XT nagyjából dupla olyan erős, mint a két említett kártya. Azt készséggel elhiszem, hogy RT mellett csak FHD-ra ajánlott, de RT nélkül(a játékok kb. 90%-ában, de az új AAA gémek fele is RT nélkül jön) bőven tud 1440p-t az új játékokban is, és ahol egy 1060 elég a FHD-ra még ma is, ott ez 4K-ra is elég tud lenni. Hangsúlyozom: RT nélkül.

- "A nyers számítási kapacitás játékokban nem sokat ér, de szerintem ezt te is nagyon jól tudod, így nem is értem ezt miért hozod itt fel" Azért hozom fel, mert azonos architektúra esetén igenis jól közelíti a valós teljesítmény-viszonyokat, és az RDNA1 és RDNA2 az RT-t nem számítva közel azonos architektúra, ha valami, akkor az RDNA2 inkább hatékonyabb, mint nem az RDNA1-hez képest. Nyilván egy NV-AMD vagy RDNA-GCN összehasonlítás esetében jóval kisebb lenne a jelentősége...

- "Nem egészen értem hogyan jött ki nálad a 20%. Pontosan mihez képest? Hogy számoltad?" Ahhoz az RX5700-hoz képest, amit te hoztál fel összehasonlítási alapként. Az RX5700XT kb 10%-kal erősebb a non-XT RX5700-nál, és annál a 6600XT várhatóan kb. 10%-kal erősebb lesz(ha a memória vagy a PCIe sávszél nem ad bottleneck-et, és mehet a GPU ameddig tud).

Ha az 5700XT-hez nézzük, akkor annál olcsóbb és erősebb induláskori MSRP-vel számolva.- "Akkor miért hoztad fel a nyers számítási kapacitásokat, amiknek nem sok köze van a játékokban nyújtott teljesítményhez?" Kevered a szezont a fazonnal. A számítási teljesítménynek igenis van köze a játékokban nyújtott teljesítményhez(honnan a francból veszed, hogy nem???), amit én kritizáltam számháborút az pl. a memóriabusz szélességén(128 bit) történő lovaglás, a frekvencia figyelembe vétele nélkül, ami nettó marhaság.

- És igen, he figyelted, én is pont azt írtam, hogy nem annyira a 3060-hoz képest kérdéses a 6600XT árazása, mert ha hinni lehet az AMD-s teszteredményeknek(és azok jól mutatják a teljesítmény-viszonyokat a nem tesztelt játékokra nézve is), akkor a 6600XT bang/buck-ban megegyezik a 3060-nal, inkább a 3060Ti-hez képesti ár és teljesítmény viszonyok lesznek érdekesek. És itt jön be megint a marketing kérdésköre... gyanítom pont ezért van a slide-okon a 3060 és nem a 3060Ti...

És azt se felejtsük el, hogy simán előfordulhat, nem első alkalommal lenne, hogy közvetlenül a megjelenés előtt/után módosítanak az MSRP-n... ez a kártya 340-350 dodó környékén valós konkurenciát jelentene mindkettő NV kártyának... aztán persze úgy se az MSRP számít, hanem a kisker ár és elérhetőség. Meg a független tesztekben mutatott teljesítmény.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

Kansas

addikt

Nézőpont és használati szokások kérdése... ahogy fentebb már említettem, én az RX5700XT-men 4K-ban játszok mindennel, Very High/Ultra grafikán, csak az AA-t kapcsolom ki teljesen, mert 28"-on 4K-ban abszolút nincs rá szükség. 60Hz-es a monitor, 40-60Hz tartományban műxik rajta a FreeSync, általában az fps is itt tartózkodik, fölé se engedem. Witcher 3, WoWs, AC Odyssey, ETS2/ATS, Transport Fever 2, CoD MW 1-2-3(csak single), ilyesmik mennek gond nélkül...

OK, pár játékot PS5-ön tolok, mint FIFA21, AC Valhalla(btw RT egyik AC-ban sincs, egyik platformon se tudtommal), új Spiderman, Ace Combat 7, Gran Turismo Sport, zömmel konzol exkluzívokat... de amelyik nem az, az menne a PC-n is ugyanúgy.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

Új hozzászólás Aktív témák

ph Az AMD középkategóriás megoldása a Full HD-s felbontást célzó játékosokkal szemezne.

? E-péniszt mérni kell, vagy mi?

? E-péniszt mérni kell, vagy mi?

- azt akarod elhitetni velem, hogy bevetted az AMD marketing-dumáját arról, hogy ez 1080p-s kártya? Lásd még

- azt akarod elhitetni velem, hogy bevetted az AMD marketing-dumáját arról, hogy ez 1080p-s kártya? Lásd még