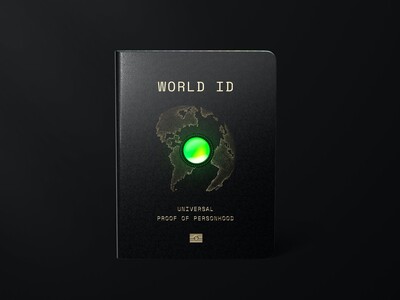

Az OpenAI új keretrendszerrel igyekszik megoldani a biztonsági aggályokat a legfejlettebb AI-modellek kapcsán, ennek részeként pedig az igazgatótanács visszavonhatja a vezetőség biztonsági döntéseit.

Az OpenAI egyes területeken (mint az atomipar vagy a kiberbiztonság) csak akkor telepíti a technológiáját, ha azt fenyegetésektől mentesnek, biztonságosnak minősítik. Tanácsadói csoportot is létrehoznak a biztonsági jelentések ellenőrzésére, ezt a vezetőség és az igazgatótanács is megkapja. A döntést az előbbi hozza, utóbbi azonban felülbírálhatja.

A kutatók és a nyilvánosság körében top téma az AI jelentette fenyegetés: egyesek a fizetésüket és a munkájukat féltik, mások pedig a társadalom szétzilálásától vagy egyenesen az emberiség kihalásától, a civilizáció megszűnésétől tartanak.